智慧工地AI能否规模化落地,关键不在模型有多大,而在算力、算法与工程闭环是否同时成熟。本文用Hinton与Jeff Dean的工业化逻辑,给出可执行的落地清单。

智慧工地AI为何能规模化落地:算力、算法与工程的三重成熟

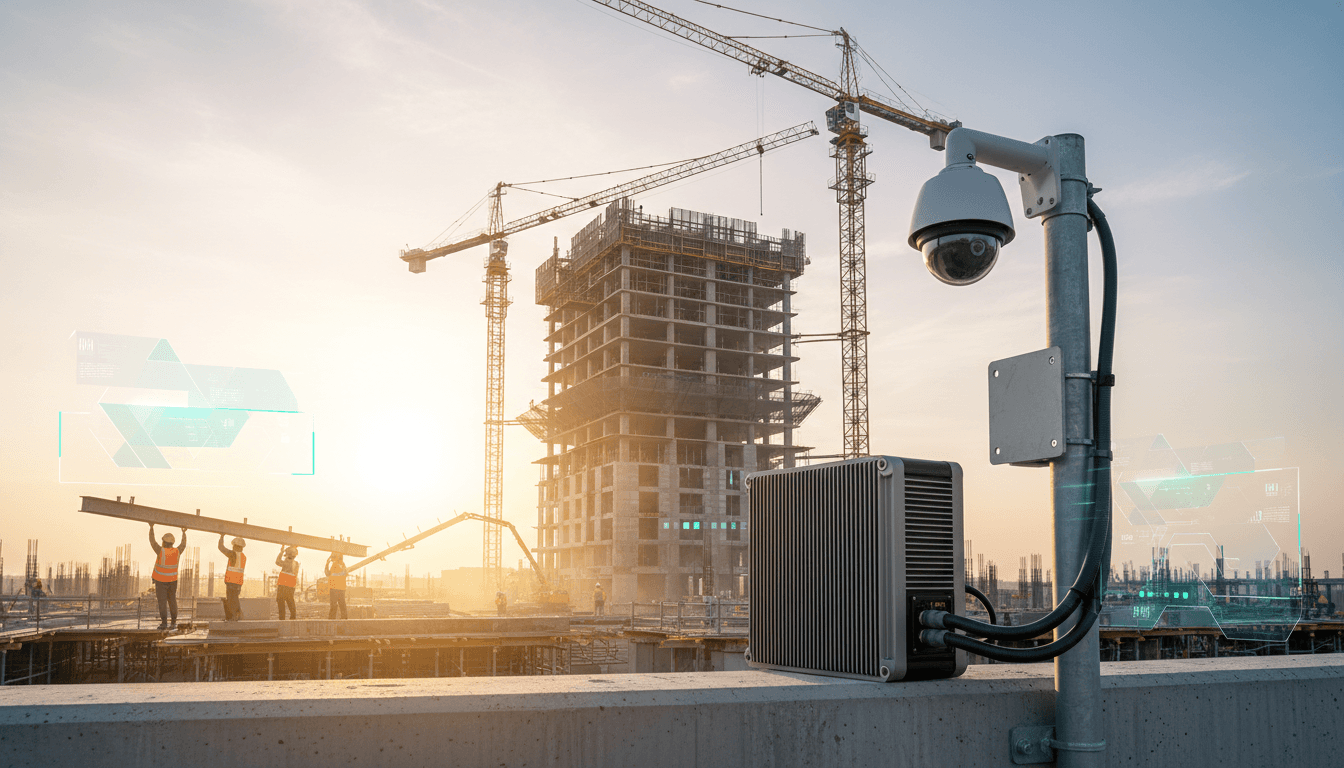

2025 年,很多建筑企业对“智慧工地”的态度变得更务实了:不是“要不要做”,而是“怎么做才不翻车”。我见过不少项目的试点,摄像头装了、平台搭了、模型也跑起来了,但三个月后就进入“数据没人用、告警没人信、系统没人维护”的状态。原因通常不是模型不够聪明,而是规模化所需要的三件事没有同时到位:算力、算法、工程体系。

这恰好与 Geoffrey Hinton 和 Jeff Dean 在 NeurIPS 的那场对谈相呼应:现代 AI 之所以能从实验室走向数十亿用户,靠的不是某个灵感时刻,而是算法可扩展、硬件能负担、工程能闭环的系统性成熟。

把这套逻辑放到建筑行业,你会发现:智慧工地也不是单点创新,而是一条“工业化”路线。只要把“算力—算法—工程”三件事按正确顺序补齐,AI 在工地的落地会变得可控、可复制、可持续。

算力:智慧工地的“隐形地基”,决定你能跑多大规模

答案先放这儿:智慧工地的 AI 能否规模化,首先取决于你能否在合理成本下持续提供推理算力,而不是一次性把模型训练出来。

Hinton 提到 AlexNet 时代“两块 GPU 板卡插在家用电脑上训练”的故事,核心不是怀旧,而是提醒:算力把“想法”变成“现实”。Jeff Dean 讲 2013 年在餐巾纸上算出语音助手推理成本,进一步点破了规模化的关键:推理端的成本会在用户量上来之后瞬间爆炸。

把它翻译成工地语言:

- 你可以在总部机房把安全帽识别模型训得很漂亮;

- 但当你要同时覆盖 20 个项目、每个项目 200 路视频、还要做到 7×24 小时实时分析时,真正掐住脖子的不是“准确率还差 1%”,而是每月电费、带宽、服务器折旧、运维人力。

智慧工地的算力架构,别一上来就“全云化”

我更赞成按“业务实时性”和“数据敏感度”分层:

- 边缘推理(工地侧):高频、强实时的任务优先放边缘(如人员闯入、吊装禁入区、临边防护缺失)。延迟低、带宽省,现场也更愿意信。

- 云端推理(企业侧):跨项目的统计、复盘与训练数据管理放云端(如月度风险画像、分包单位安全评分、隐患闭环率分析)。

- 训练与再训练(集中算力池):模型迭代要集中做,别让每个项目各训各的。否则数据标准不一、版本混乱,最后谁也不敢升级。

一句话:边缘负责“现在就要用”,云端负责“长期会更准”。

算法:别迷信“大模型上工地”,可扩展才是真生产力

答案先放这儿:建筑场景的 AI 算法价值,不在于模型参数有多大,而在于是否可扩展、可迁移、可压缩、可解释。

Jeff Dean 提到 Transformer 之所以重要,是因为它更适合并行计算,让规模化训练在工程上变得可行。对智慧工地来说,类比也成立:真正决定 ROI 的,不是你能不能“上一个最强模型”,而是你能不能让模型在不同项目、不同摄像头、不同光照遮挡下稳定复用。

施工现场算法要赢,靠“三个可”

- 可迁移:同一套能力从住宅项目迁移到市政、轨交、厂房,不需要每次从零开始标注。

- 可压缩:蒸馏、量化、低精度推理(类似 FP4 这类思路)让模型在边缘设备跑得动。

- 可解释:现场管理者不接受“模型说有风险”。他们要看到证据链:哪一条规范、哪一帧画面、哪一次整改超期。

大模型在智慧工地最靠谱的位置:做“协同与闭环”,不是做“盯视频”

很多团队把大模型直接用在视频识别上,成本高、效果不稳定。我更看好它在以下位置发力:

- BIM/进度/质量数据的语义对齐:把“图纸语言、规范语言、现场记录语言”统一成可查询、可推理的知识结构。

- 隐患闭环助手:自动生成整改通知、复核要点、复检清单;把“发现—派单—整改—复检—归档”打通。

- 跨项目经验复用:把一个项目的高风险工序经验抽象成可复用的 SOP,下一项目直接套用并自动提醒。

这也呼应“人工智能在科研与创新平台”的主线:AI 不只是替人干活,更重要的是让知识可沉淀、可复用、可加速迭代。

工程:智慧工地成败,80% 输在“工具链与组织方式”

答案先放这儿:AI 在工地跑得久,靠的是工程闭环与组织协同,不是一次性部署。

Jeff Dean 说 Google 曾经内部也早有聊天机器人,但没推向市场,一个原因是组织资源分散、目标不一致。建筑行业更典型:安全、质量、机电、进度、劳务、设备各管一摊,数据口径不统一,最后平台只能“看起来很全”,但“用起来很痛”。

工地 AI 的工程闭环,必须具备四个模块

我建议你用“最小可用闭环”去验收任何智慧工地方案:

- 数据采集标准化:摄像头点位、分辨率、时间同步、人员/设备编码规则先统一。

- 模型监控与回流:误报漏报要能一键回传,形成再训练样本;否则越用越不准。

- 工单系统打通:告警必须能落到责任人、时限、复核人;没有工单,AI 只是“提示音”。

- 指标可审计:至少有 5 个硬指标按周复盘,例如:告警采纳率、隐患闭环率、平均整改时长、重复隐患占比、关键工序覆盖率。

一句能落地的判断:如果 AI 发现问题但不能推动整改,它就不是生产系统,只是演示系统。

2025 年末的现实趋势:从“堆摄像头”转向“算账与治理”

临近年末预算收口,越来越多甲方开始要求智慧工地提供“可核算收益”。这其实是好事,会逼着方案从“功能清单”转向“运营指标”。典型的可核算方向包括:

- 塔吊/升降机等设备的停机等待减少(用调度与预测,而非单纯监控)

- 夜间违规作业与动火风险下降(用规则+识别+工单闭环)

- 重大危险源旁站覆盖率提升(用人机协同,而非全自动替代)

规模化后的三道门槛:能效、记忆、创造,对应工地的三类“难题”

答案先放这儿:智慧工地进入规模化后,最难的不是“再加一个功能”,而是跨过能效、记忆与创造三道门槛。

Hinton 与 Dean 提到的三道门槛,放到建筑场景非常贴切。

1)能效:不降本,就谈不上普及

工地 AI 的核心成本来自长时间推理。解决路径很明确:

- 低精度推理与模型压缩:把“够用”做到极致;

- 事件触发式推理:不是 24 小时全帧分析,而是先用轻量模型筛选,再对关键片段做重模型复核;

- 算力池化:企业层面集中采购与调度边缘/云算力,避免项目各自为政。

2)记忆:没有“长期上下文”,就做不好复盘与预警

工地管理需要“长记忆”:一个隐患是否反复出现?某分包是否在多个项目有同类问题?某工序的风险是否在特定天气/班组组合下上升?

这类问题本质是跨时间、跨项目的上下文。你需要的不只是更大的模型窗口,更是:

- 统一的主数据(人员、设备、分包、工序、区域)

- 可追溯的数据链路(告警→工单→整改→复检)

- 企业级知识库(规范、交底、方案、事故案例)

3)创造:从“识别违规”走向“提出更优方案”

Hinton 强调“联想”是创造。智慧工地也该有创造力:不是只会抓违规,而是能提出更优的组织方式。

例如:

- 根据历史吊装作业与现场拥堵数据,建议更合理的吊装窗口期;

- 根据混凝土浇筑记录与气温湿度,给出养护策略与风险提示;

- 在方案交底阶段就指出“高风险步骤”,并给出可替代工法或防护清单。

当 AI 能把“看似无关的数据”连起来,智慧工地才真正从监控系统升级为决策支持系统。

落地清单:想要 90 天游起来,别从“买平台”开始

答案先放这儿:智慧工地要快、要稳,第一步是选定一个高频闭环场景,并把算力、算法、工程三件事一口气做通。

我建议按下面顺序推进(很像 AI 工业化路径的缩小版):

- 选一个闭环场景:比如“临边洞口+人员闯入+工单整改”。别贪多。

- 确定算力策略:边缘设备型号、单路成本、并发上限写进方案。

- 建立数据标准:点位编码、班组编码、工序编码先统一。

- 把工单跑通:明确责任人、时限、复检规则、归档格式。

- 做周复盘:用 5 个硬指标盯住质量,持续回流样本。

做到这一步,你就拥有了可复制的“智慧工地最小系统”。后续再扩展到质量、进度、设备、能耗,会越做越轻松。

下一步:把智慧工地当成“企业的科研与创新平台”来建设

智慧工地最值钱的不是某个识别模型,而是你在一年里沉淀下来的数据资产、流程资产与知识资产。从这个角度看,它天然属于“人工智能在科研与创新平台”系列的核心叙事:把分散经验变成可计算、可迭代、可复制的能力。

如果你正在规划 2026 年的智慧工地路线,我的建议很明确:先把算力成本算清,再把闭环工程打通,最后才谈大模型与创新场景。当“算力—算法—工程”三件事同时成熟,规模化落地就不是口号,而是可预测的结果。

你更想优先解决哪一块:边缘算力成本、隐患闭环,还是跨项目的知识沉淀?