T5Gemma 2把多模态、128K长上下文与140+语言带入编解码器路线。本文从电商推荐、搜索、客服与供应链给出可落地评估模板。

电商多模态长上下文新底座:T5Gemma 2给推荐与搜索的答案

2025 年末,AI 模型发布节奏明显变快。对电商和新零售团队来说,这不只是“模型又更新了”的热闹:基础模型的架构选择,正在直接影响推荐、搜索、客服、供给预测这些核心链路的成本与上限。T5Gemma 2 的意义就在这里——它把主流已久的“仅解码器”路线之外的另一条路,重新摆到了台前:编码器-解码器(Encoder–Decoder)大模型。

我见过不少电商团队在做“全链路智能化”时踩到同一个坑:模型能生成,却不够“读得准”。推荐要理解用户多轮意图、搜索要吃进图文混合信息、客服要翻历史订单与对话,供应链要读长周期日志与促销计划。当输入变长、信息变杂,能不能先把上下文“编码清楚”,再稳定地产出答案,往往比“会不会写”更重要。

T5Gemma 2 提供了一个很现实的信号:编解码器架构在“长上下文 + 多模态 + 多语言”的电商基础设施场景里,可能比想象中更适配。

为什么电商更该关注“编码器-解码器”而不只看参数规模

**答案很直接:电商的核心不是写作文,而是读懂复杂上下文后做决策。**编解码器的结构天然把“理解输入”和“生成输出”分开:编码器负责把长文本、图像线索、结构化信息压成更稳的表示;解码器再基于这些表示生成回复、标签、摘要或行动建议。

对比常见的“仅解码器”大模型,编解码器在电商里至少有三类优势更容易落地:

- 检索增强与长文档处理更顺手:编码器适合做聚合、对齐、压缩——这对商品详情、评价、问答、物流节点、售后记录这些“长且碎”的输入尤其关键。

- 多任务更统一:同一套底座既能做生成(客服话术、商品文案),也能做判别与抽取(风险识别、属性抽取、意图分类)。

- 多模态更自然:电商数据天然是“图+文+结构化字段”的混合体。把图像先编码成稳定向量,再参与生成,会比把所有东西“拼成一串 token”更可控。

一句话总结:电商需要的是“读得准、看得懂、记得住”,编解码器更像为这件事量身定做。

T5Gemma 2 更新点:多模态、128K 长上下文与 140+ 语言的组合拳

**结论先放前面:T5Gemma 2 是目前社区里少见的“高性能编解码器 + 超长上下文(最高 128K)+ 多模态”的开放模型家族。**它建立在 Gemma 3 的能力之上,并延续了“适应(adaptation)”路线——把已预训练的仅解码器模型适配成编解码器。

多模态:让“以图搜货”和“图文理解”不再是两套系统

电商里最常见的多模态需求不是炫技,而是这些朴素问题:

- 用户发来一张穿搭图,想要“同款更便宜、相似不同材质、适合冬季的替代”。

- 运营要批量检查主图是否合规(露点、夸大宣传、低质图),并给出可执行的修改建议。

- 质检要识别“图文不一致”:标题写纯棉,细节图出现化纤标签;参数表写 500ml,包装图标注 450ml。

T5Gemma 2 的价值在于:同一个模型既能理解图片,又能结合长文本(详情、评价、规则)给出可落地的结论。这能显著减少“视觉模型 + 文本模型 + 规则引擎”的系统缝合成本。

128K 长上下文:对电商来说是“全链路记忆”的门槛

**长上下文不是为了塞更多废话,而是为了把“证据链”放进同一次推理里。**在电商与新零售场景,128K token 意味着你可以把下面这些内容尽量放在一次调用中完成闭环:

- 用户近 90 天行为摘要(搜索、加购、收藏、退款偏好)

- 当前会话多轮对话

- 订单与物流节点(尤其跨境/预售)

- 商品详情 + QA + 评价摘要 + 负面点

- 平台规则与活动机制(双12、年货节、跨店满减等)

对客服而言,这会带来一个非常具体的变化:从“先问一堆问题再处理”,变成“先读全量上下文再给方案”。响应更快,转人工更少,且更容易做到“解释清楚依据”。

140+ 语言:跨境电商的“本地化”开始从翻译走向理解

多数团队做多语言,第一步是翻译。但跨境电商真正难的是:不同语言里的尺码表达、材质习惯、禁限售规则、文化敏感点。支持 140+ 语言的意义在于:模型不只是把中文翻成英文,而是能在目标语言环境中完成分类、抽取、问答与合规判断。

对做东南亚、拉美、中东市场的平台来说,这会影响两件事:

- 上新效率:多语言标题、卖点、属性补全更自动化。

- 风险成本:对本地政策与平台规则的触发更可控。

架构层面的“省钱逻辑”:词嵌入绑定与合并注意力,为什么对平台工程重要

**一句话:T5Gemma 2 不是只追效果,它也在认真降低部署成本。**电商平台真正的 AI 成本常常不在训练,而在“日常高频推理”。

词嵌入绑定:把参数省在刀刃上

编码器与解码器共享词嵌入参数,会带来更小的总体参数量。对平台侧意味着:

- 同等显存/内存下,可以上更大 batch 或更长上下文;

- 同等预算下,可以用更多模型副本支撑大促峰值;

- 对边缘侧/门店侧小模型(如 270M–270M)尤其友好。

这类“架构节省”在大促期间很实在:你要么用更少机器扛住峰值,要么把算力挪去做更高价值的环节(比如更复杂的召回重排)。

合并注意力:复杂度下降,吞吐更容易上去

在解码器里把自注意力与交叉注意力合并为统一注意力层,减少参数与结构复杂度,工程收益往往体现在:

- 推理链路更短,延迟更稳定;

- 并行化空间更大,更适合多卡推理;

- 对“长上下文输入 + 中短输出”的任务更友好。

对电商来说,这正是大量任务的典型形态:输入很长(用户历史+商品信息+规则),输出不一定长(一个解释、一段话术、一个标签集合)。

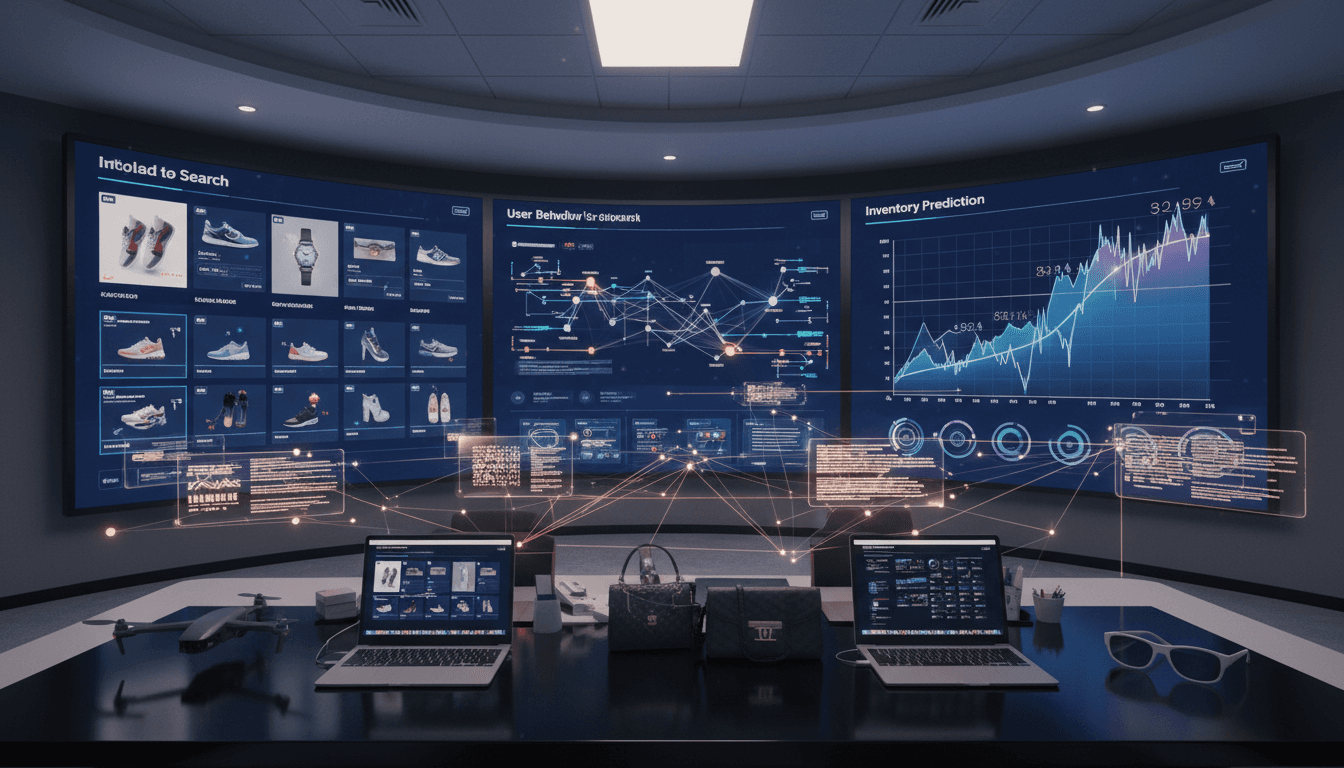

把 T5Gemma 2 放进电商链路:四个“立刻能评估”的应用模板

**判断一个模型值不值得引入,我建议先用“模板化任务”快速对齐收益。**下面四个模板,覆盖推荐、搜索、运营与供应链,且都能体现编解码器的长处。

1)多模态商品搜索:从“相似图”走向“可解释筛选”

做法:把用户图片、候选商品主图、商品标题/属性、评价摘要一起喂给模型,让模型输出:

- 相似点与差异点(版型/材质/颜色/图案)

- 过滤理由(比如“羽绒含量不足,不满足保暖诉求”)

- 可用于排序的结构化信号(相似度维度打分)

收益指标:搜索转化率、加购率、以及“用户二次筛选/跳出”下降。

2)长上下文推荐解释:用“证据链”提升信任与复购

做法:把用户近期行为、相似人群偏好、商品卖点、负面评价要点一起输入,要求输出两类内容:

- 面向用户的简短解释(30-80 字)

- 面向算法的结构化理由(3-5 条可追溯证据)

收益指标:推荐点击率提升并不一定显著,但退货率、差评率、复购率更可能先动。

3)多语言客服与售后:把“翻译”升级为“理解与处置”

做法:同一次调用中放入订单状态、物流轨迹、历史对话、平台规则,让模型输出:

- 本地语言回复(含礼貌与文化适配)

- 处置动作建议(补发/退款/升级工单)

- 风险提示(欺诈迹象、超时节点)

收益指标:首次响应时长、一次解决率、转人工率。

4)供给侧智能:用 128K 吃下“促销-库存-履约”的长链路

做法:把过去 4-8 周销量、活动节奏、渠道投放摘要、库存与到货计划、异常事件(断货/物流延迟)作为长上下文,要求输出:

- 未来 7/14/30 天需求区间(不是单点)

- 关键不确定性来源(活动强度、竞品降价、天气/节假日)

- 可执行动作(补货阈值、调拨建议)

收益指标:缺货率、滞销库存、履约时效。

选型与落地建议:别被“开放模型”四个字迷惑

**开放模型不等于开箱即用的业务系统。**我更建议用“科研与创新平台”的思路去推进:先做可复现评测,再做小范围灰度。

一套务实的评估清单(适合电商/零售团队)

- 长上下文是否真能用:把输入从 8K 拉到 32K、64K、128K,观察答案一致性与证据引用能力。

- 多模态是否可控:同一张图换不同描述,输出是否稳定;对“图文不一致”是否敏感。

- 多语言是否懂行业黑话:尺码、材质、物流、售后场景的本地表达是否准确。

- 成本曲线是否匹配业务峰值:在双12、年货节这类节点,算力预算能不能扛住。

我更看重的一个结论

电商的 AI 竞争,越来越像“基础设施竞赛”:谁能用更低成本把图文、长上下文、多语言接入统一底座,谁就更容易把智能能力铺到每个业务角落。T5Gemma 2 的出现,让编解码器这条路线重新具备了工程说服力。

写在最后:科研路线正在反哺零售工程

这篇文章属于「人工智能在科研与创新平台」系列,我想强调的是:科研并不遥远。架构选择、注意力机制、适配训练这些看似学术的东西,最终都会落到电商平台的吞吐、延迟、转化与风控上。

如果你正在规划 2026 年的电商智能化项目,我建议把 T5Gemma 2 视为一个“可验证的选项”:先用上面的四个模板做 2 周评估,跑出你自己的成本与收益曲线,再决定是否进入更深的系统集成。

下一步更值得追问的是:当编解码器在长上下文和多模态上证明了工程优势,**电商推荐与搜索会不会从“模型能力竞赛”转向“证据链与可控性竞赛”?**这会决定很多平台未来两年的产品形态。