Generativ AI i skadehantering fastnar ofta i piloter. Här är varför det skalar dåligt – och hur försäkringsbolag kan bygga robust AI med kontroll och effekt.

Generativ AI i skadehantering: därför skalar det dåligt

I många försäkringsbolag är skadeavdelningen den plats där kundlöftet antingen infrias – eller spricker. Och när volymerna ökar (vinterväglag, stormar, vattenskador, inbrottstoppar runt helger) är det samma sak varje gång: köer, stress, fler fel, sämre kundupplevelse.

Här kommer generativ AI in med ett löfte som låter enkelt: sammanfatta, föreslå beslut, skriva kundtexter och hjälpa handläggare snabbare i mål. Problemet? Det som fungerar i en pilot blir ofta svårt att få att fungera i stor skala. Och det är precis där många organisationer fastnar.

Jag tycker att diskussionen ibland hamnar fel. Det är inte modellen som är “för dålig” – det är systemet runt omkring som inte är byggt för att bära AI i produktion. Skadehantering är en blandning av data, juridik, medicin, fordonsteknik, bedrägerimönster, kunddialog och mänskliga bedömningar. När man ska skala generativ AI över den verkligheten blir friktionen tydlig.

Skala i skadehantering handlar inte om fler ärenden – utan fler undantag

Skalproblemet uppstår när generativ AI möter variation, undantag och ansvar. I en kontrollerad demo kan man mata in “typiska” ärenden. I verkligheten är varje skada en kombination av:

- ofullständiga uppgifter (saknade kvitton, otydliga bilder, motstridig information)

- olika produktvillkor och självrisklogik

- flera parter (verkstad, motpart, vårdgivare, mäklare)

- tidskritik (stillestånd, hyrbil, akuta bostadsskador)

- regulatoriska krav och intern styrning

I praktiken betyder det att AI inte bara behöver vara bra på text. Den måste också vara bra på process.

Det som skalar dåligt: beslutsnär AI utan hårda räcken

Generativ AI är stark på språk. Men skadehantering kräver att varje steg kan motiveras. Om AI skriver en “rimlig” motivering som inte stämmer med villkoren eller praxis blir konsekvensen snabbt dyr: felaktiga utbetalningar, omprövningar, klagomål och i värsta fall tillsynsfrågor.

Det som skalar dåligt är därför lösningar där AI:

- gissar när data saknas

- blandar ihop villkor mellan produkter

- uppfattas som beslutande, trots att den “bara föreslår”

En enkel princip jag brukar utgå från: AI får gärna vara snabb – men den måste vara spårbar.

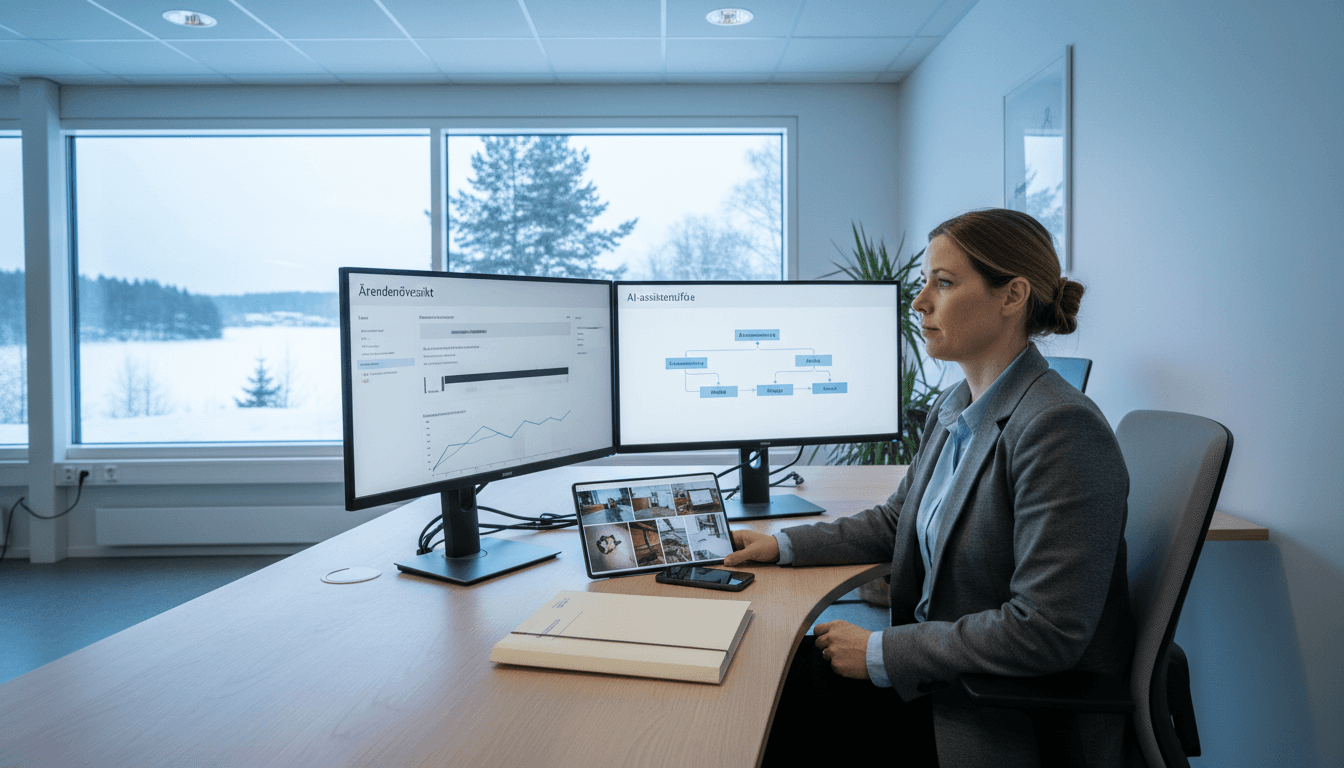

Det som skalar bättre: AI som höjer kvaliteten i varje handläggarsteg

När AI används som “copilot” för handläggaren – inte som fristående beslutsmaskin – blir den ofta mer robust. Exempel:

- sammanfattning av ärendehistorik (kontaktlogg, bilagor, tidigare skador)

- utkast till kundkommunikation med tonalitet och tydlighet

- checklista för nästa bästa åtgärd baserat på ärendetyp

- identifiering av saknade dokument och tydliga frågor att ställa

Det här är inte lika flashigt som helautomatisk skadereglering, men det är ofta där ROI faktiskt blir stabil.

Specialiserad riskkontroll är en ledtråd: generativ AI måste också bli branschsmart

Generisk riskhantering fungerar dåligt i specialiserade branscher – och generisk AI fungerar dåligt i specialiserade skadeflöden. Det är samma lärdom.

I den internationella försäkringsmarknaden har många aktörer satsat på branschspecialister inom riskkontroll: personer som kan telekom, medtech, tillverkning, IT, flotta, cybersäkerhet. Poängen är enkel: när rådgivaren förstår hur verksamheten faktiskt fungerar går man från inspektion till partnerskap.

Översatt till AI i skadehantering: modellen måste matas med rätt kontext, rätt regler och rätt språk för varje segment.

Branschsmart AI = segmenterade regler, data och utvärdering

Skadehantering i motor, egendom, ansvar, sjuk/olycksfall och cyber ser helt olika ut. Ändå ser jag samma misstag om och om igen: man försöker rulla ut “en AI” över alla linjer.

En bättre struktur:

- Segmentera use case (t.ex. vattenskador i villa, glasskador i bil, enklare reseärenden)

- Knyt AI till regelverk (villkor, beloppsgränser, skadeorsaker, undantag)

- Utvärdera per segment med egna kvalitetsmått (felutbetalningar, omprövning, NKI, handläggningstid)

Det är tråkigare än en stor lansering. Men det är så man faktiskt skalar.

Case-lärdom från riskkontroll: när man “stannar kvar” minskar skadorna

Ett talande exempel från riskkontrollvärlden är hur en stor telekomaktör med ökande vagnparksskador inte blev av med sin försäkring – i stället genomfördes ett strukturerat förbättringsprogram: standardiserade rutiner, uppföljning och operativt stöd tills frekvens och allvarlighet gick ned.

Samma logik behövs för AI: det räcker inte att lansera. Man måste drifta, följa upp, justera promptar, uppdatera kunskapsbaser, förbättra datakvalitet och utbilda användare.

Varför generativ AI “fastnar” i piloter: fyra praktiska hinder

De flesta skalproblem är inte tekniska – de är organisatoriska och datarelaterade. Här är de fyra hinder som oftast stoppar en utrullning i skadeprocessen.

1) Data som inte är redo (och aldrig var tänkt för AI)

Skade- och kundsystem är byggda för transaktioner, inte för semantisk förståelse. Bilagor ligger som PDF:er, foton saknar metadata och viktiga uppgifter finns i fri text.

Åtgärder som brukar ge mest effekt först:

- standardiserade skadeorsakskoder och åtgärdskoder

- tydliga krav på bilagor per skadetyp

- bättre struktur i kontaktlogg (vad hände, när, vem, nästa steg)

2) Kunskapen är spridd i människor och dokument

Mycket av “hur man gör” finns i erfarna handläggare, inte i en central kunskapsbas. Då blir generativ AI inkonsekvent.

Här fungerar retrieval-augmented generation (RAG) bra – men bara om ni har:

- en kuraterad, versionsstyrd kunskapsbank

- tydliga prioriteringsregler (villkor före FAQ, interna riktlinjer före malltexter)

- spårbarhet: vad AI använde för att ge sitt svar

3) Risk, compliance och modellstyrning kommer in för sent

Skadebeslut påverkar ekonomi och kundrättigheter. Därför måste AI-styrning byggas in från start:

- definiera vilka steg AI får göra (skriva utkast, inte fatta beslut)

- logga AI:s underlag och output

- sätt kvalitetsgränser: när ska ärendet alltid eskaleras?

4) “Tidsvinst” mäts, men kvalitetsvinst glöms

Om ni bara mäter minuter per ärende missar ni det som verkligen kostar: omtag, klagomål och felaktiga beslut.

Jag föredrar en balanserad uppsättning KPI:er:

- handläggningstid (median, inte bara snitt)

- omprövningsgrad / återöppnade ärenden

- utbetalningsprecision (stickprov mot policy och praxis)

- kundnöjdhet per kontaktpunkt

- andelen ärenden som kräver senior eskalering

En realistisk väg till skala: bygg AI som en “riskkontrollfunktion” i skador

Vill ni skala generativ AI i skadehantering behöver ni behandla AI som en operativ kontrollfunktion, inte en engångsinstallation. Här är ett upplägg som fungerar i praktiken.

Steg 1: Börja där variationen är låg men volymen hög

Bra startområden är ofta:

- standardiserad kundkommunikation (status, nästa steg, begäran om bilagor)

- sammanfattning av ärenden inför överlämning

- triage: sortera rätt ärende till rätt kö

Steg 2: Bygg “räcken” innan ni höjer automationsgraden

Tre räcken jag tycker är icke-förhandlingsbara:

- Policy- och villkorskoppling via RAG, med källhänvisning internt

- Regelbaserade spärrar (beloppsgränser, vissa skadeorsaker, avvikelseflaggar)

- Human-in-the-loop med tydliga ansvarspunkter

Steg 3: Segmentera, träna och utvärdera som om varje produkt är en egen produkt

Skapa ett “AI-scorecard” per segment. Exempel för vattenskador i villa:

- andel ärenden där AI korrekt identifierar saknade handlingar

- kvalitet på frågebatteri till kund (relevans, tydlighet)

- minskning i antal kontakter per ärende

Det är så ni ser vad som faktiskt förbättras.

Steg 4: Gör specialister till medskapare – inte mottagare

Branschspecialister inom risk, skador, juridik och bedrägeri behöver vara med och forma:

- ordlistor (vad betyder “självriskreduktion”, “återställandekostnad”, “följdskada” i praktiken?)

- exempelärenden och “golden answers”

- eskaleringsregler

Det här är samma tanke som i modern riskkontroll: när kompetensen finns nära verksamheten blir resultatet bättre.

Vanliga frågor jag får om generativ AI i skador (och raka svar)

Kan generativ AI fatta skadebeslut själv?

Ja i vissa smala flöden, men bara med tydliga beloppsgränser och strikt regelstyrning. För de flesta skadeprodukter i Sverige är ett assisterande upplägg mer hållbart.

Kommer AI att minska behovet av handläggare?

Den minskar behovet av administrativ tid – inte behovet av omdöme. De bästa teamen använder AI för att frigöra tid till de svåra ärendena och till proaktiv kunddialog.

Är bedrägeririsken ett argument mot generativ AI?

Nej, men det är ett argument för bra kontroll. AI kan både upptäcka avvikelser och skapa mer övertygande falska narrativ. Därför måste bedrägeriindikatorer och spärrar byggas in.

Nästa steg: skala med disciplin, inte med hype

Generativ AI i skadehantering är här för att stanna, men den skalar bara när den får samma typ av struktur som bra riskhantering: specialisering, uppföljning och tydligt ansvar. Den organisation som vinner är inte den som automatiserar mest – utan den som minskar flest omtag och förbättrar kundupplevelsen utan att tappa kontroll.

Om ni arbetar med AI inom försäkring och riskhantering och vill få ut mer än demo-resultat är min rekommendation enkel: börja med ett segment, bygg räcken, mät kvalitet, och iterera tills det sitter.

Vilket skadeområde i er verksamhet har hög volym, relativt låg variation och tydliga regler – och skulle därför vara mest tacksamt att skala generativ AI i under 90 dagar?