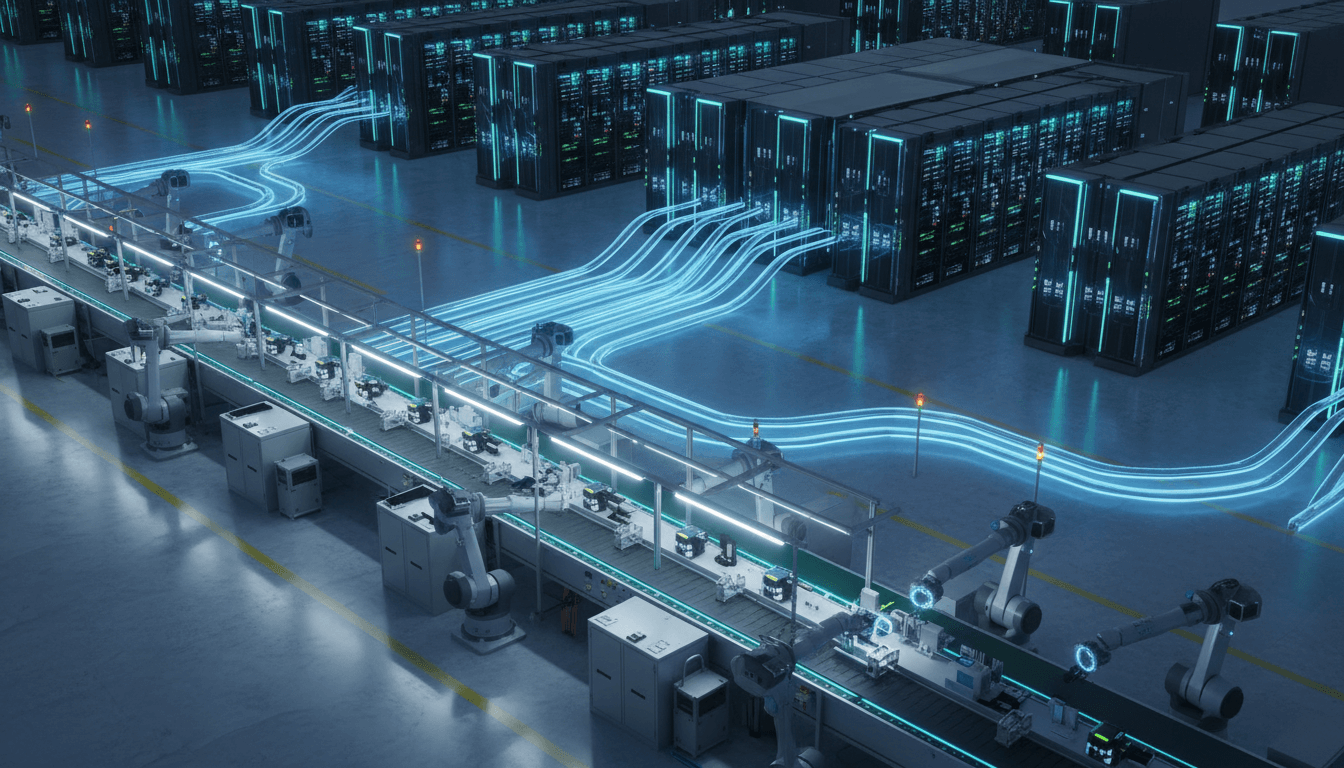

ソフトバンクの最新GPU基盤増設を手がかりに、製造業でLLM・生成AIを現場実装するための計算基盤設計と実務ポイントを解説します。

製造業のAI導入を加速するGPU基盤投資の実務ポイント

AIで工場を賢くする――と言うのは簡単ですが、現場で詰まるのは「計算資源が足りない」「学習が終わらない」「PoC止まりで量産に乗らない」という、ごく地味な壁です。AIの精度以前に、回せる計算基盤があるかどうかで勝負が決まる場面が増えています。

2025/12/25、ソフトバンクが最新GPU(NVIDIA Blackwell世代)を72基搭載するラック型システム「GB200 NVL72」を用いたAI計算基盤を増設し、GPU 1224基規模で稼働させたと発表しました。液冷を採用し、将来は4000基超へ拡張し、10.6エクサFLOPS規模へ引き上げる計画です。自社の国産LLM「Sarashina(サラシナ)」に使うだけでなく、国内企業・研究機関向けの提供も予定されています。

このニュースが製造業にとって意味するのは、「LLMや生成AIはソフトウエアの話」ではなく、工場の品質・保全・段取り替え・教育を変える“基盤産業”になったということです。ここでは、AIが日本の製造業をどのように変革しているかという連載の文脈で、GPU計算基盤がスマートファクトリーにどう効くのか、そして導入を成功させる現実的な設計ポイントを整理します。

GPU計算基盤の強化は、製造業AIの「待ち時間」を消す

結論から言うと、GPU投資の価値は「精度を少し上げる」より、学習・推論の待ち時間を短くして、改善サイクルを回し切れる状態を作る点にあります。

製造業のAIは、データの更新頻度が高い。材料ロット、設備状態、作業者、季節、サプライヤー変更…条件が変わればモデルも陳腐化します。モデル更新が月1回なのか週1回なのかで、現場の信頼は大きく変わります。

ソフトバンクが導入したGB200 NVL72は、1ラックにBlackwell GPU 72基、Grace CPU 36基を搭載する構成です。こうした「GPUを束ねる」設計は、単体GPUを増設するのとは違い、

- 大規模学習(LLMやマルチモーダル)の並列化

- 生成AIの低遅延推論(工場内の対話・検索・要約)

- 複数部門での同時利用(設計、品質、保全、SCM)

を“同時に”成立させやすい。

製造業AIのボトルネックはアルゴリズムより運用。運用を回すには計算資源の余裕が必要です。

「エクサFLOPS」は製造業にどう関係する?

エクサFLOPSは計算性能の規模感を表す指標で、生成AIのように膨大な行列演算を回す用途で効いてきます。製造業の現場感で言い換えるなら、

- 現場の質問に“数秒で答える”(作業手順、異常対応、過去トラブル、図面の要点)

- 不良の兆候を“ラインを止める前に”検知する(異音、振動、電流波形、画像)

- 日々更新されるデータを“明日から反映する”(モデル再学習の頻度向上)

に直結します。

データセンターから工場へ:LLMは「現場の知識」を使える形にする

LLMの強みは、文章生成そのものではなく、散らばった知識を“作業できる形”に編集する力です。製造業では、情報が各所に埋まっています。

- 設備の保全履歴(CMMS)

- 品質データ(検査記録、不適合票、是正処置)

- 作業標準書、手順書、教育資料

- 生産計画、段取り替え履歴

- 現場ノート、メール、議事録

LLMをRAG(社内検索+生成)で使うと、現場は「探す」から「聞く」に変わります。ただし、ここで現実に効くのは、**社内に閉じた形で使えること(データ主権)**と、推論コストと遅延が読めることです。今回のような国内向け提供や、助成制度(特定重要物資クラウドプログラム)の認定対象といった流れは、製造業にとって「安心して載せられる土台が増える」ことを意味します。

スマートファクトリーで“まず効く”LLMユースケース

私は、最初から夢の全自動工場を狙うより、現場の時間を奪っている雑務を削るほうが成功率が高いと感じています。具体例は次の3つです。

- 異常対応の初動支援:アラーム内容→関連手順→過去事例→安全注意→切り分け手順を数十秒で提示

- 品質トラブルの要約と展開:不適合票・写真・検査ログを要約し、関係部署への共有文面を自動作成

- 教育(OJT)支援:新人が手順書を読まずに質問しても、根拠資料付きで答えられる

この3つは、センサーや画像AIが未整備でも始めやすく、効果が見えやすい。

「液冷」は他人事じゃない:工場AIの電力・熱・設置設計

答えはシンプルで、GPUを本格運用するなら熱が最大の制約になります。ソフトバンクの基盤が液冷を採用している点は、単なる設備トレンドではありません。

製造業がオンプレやエッジでGPUを持とうとすると、次が課題になります。

- 受電容量・電力単価(ピーク含む)

- 空調の増強(工場内設置ならなおさら)

- 騒音、粉じん、保守性

- 夏季の性能低下リスク

液冷は、同じ床面積で高密度に積める一方、運用や保守の設計が必要です。現場目線での要点は「冷却方式そのもの」より、

- どこに置くか(データセンター/工場内サーバ室/エッジラック)

- 誰が運用するか(情シス/工務保全/外部MSP)

- 止められないシステムか(冗長化と切替)

を先に決めること。ここを曖昧にすると、PoCは動いても本番で詰まります。

製造業が学ぶべき「GPU基盤の使い方」:買うより先に決めること

最初に決めるべきは、GPUの型番でもクラウドかオンプレかでもなく、ワークロードの棚卸しです。私はここをやらずに基盤を先に押さえる案件で、だいたい失速するのを見てきました。

1) 学習(Training)と推論(Inference)を分けて設計する

- 学習:まとまった時間、まとまったGPU、データの前処理が重い

- 推論:24/365、遅延と安定性が重要、コスト最適化が効く

製造業では推論が“現場のアプリ”なので、推論設計が弱いと使われません。LLMでも画像AIでも同じです。

2) 「どのデータを、どの粒度で」使うかを決める

品質・保全・生産はデータ粒度が違います。

- 設備:ミリ秒〜秒(波形、振動)

- 品質:ロット〜日(検査結果、抜取)

- 生産:分〜時間(タクト、停止、段取り)

GPUが強力でも、データが同期しなければ意味がない。時刻合わせ(NTP/PTP)、タグ設計、欠損処理は“地味だけど勝敗を決める”領域です。

3) ROIは「人件費削減」より「損失回避」で置く

スマートファクトリーのAIは、残業削減よりも、

- ライン停止の回避

- 不良流出の回避

- 段取り替えミスの回避

- トラブル再発の回避

のほうが金額が大きく、意思決定が早い。LLMなら、**トラブル対応時間の短縮(平均何分短くなるか)**で置くと、現場も経営も腹落ちしやすいです。

よくある疑問:国産LLMや外部提供は、工場に何をもたらす?

Q1. 国産LLMは、製造業に本当に必要?

必要なのは「国産」というラベルではなく、日本語の現場文書(手順書・品質票・略語)に強く、社内データを安全に扱える運用です。国産LLM開発の動きは、製造業が求める要件(データ主権・国内運用・日本語現場適性)に寄せやすい、という意味で追い風です。

Q2. 自社でGPUを持つべき?クラウドで十分?

現実的にはハイブリッドが強いです。

- 日中の推論はエッジや近接基盤で低遅延

- 夜間や週末にまとめて学習・評価を回す

- ピーク時だけ外部基盤を使う

今回のように計算基盤が外部提供されるなら、「全部自前」以外の選択肢が増えます。

Q3. セキュリティはどう考える?

LLM導入で怖いのは、モデルそのものよりデータの持ち出しと権限設計の破綻です。

- 社内文書のアクセス権(部署・役職・プロジェクト)

- ログ監査(誰が何を聞いたか)

- プロンプト経由の情報漏えい対策

この3点は、製造業でも最初から要件化したほうが後で楽です。

次の一手:2026年に向けた“工場AI”の勝ち筋

2025年末の時点で、生成AIは「試す」段階を超えました。次に差が付くのは、工場で回る業務に落とし込み、改善を反復できる計算基盤を確保した会社です。ソフトバンクのGPU基盤増設は、その前提条件(計算・運用・提供体制)を国内で厚くする動きとして、製造業にとっても無視できません。

私なら、2026年に向けて次の順で進めます。

- ユースケースを3つに絞る(異常対応、品質要約、教育)

- データと権限を整える(RAG前提で棚卸し)

- 推論のSLAを決める(何秒で返すか、止めない設計)

- 学習は外部基盤も含めて計画する(ピークを買わない)

スマートファクトリーは派手なデモより、毎日の改善の積み重ねで強くなります。GPU計算基盤は、その改善を止めないための“エンジン”です。あなたの工場では、AIの改善サイクルを回す計算資源と運用設計が、もう準備できていますか。