MedNeXt-v2: nagy léptékű 3D CT/MR szegmentálás erős backbone-nal. Mit jelent ez a diagnózistámogatás és kórházi hatékonyság szempontjából?

MedNeXt-v2: pontosabb 3D szegmentálás CT-n és MR-en

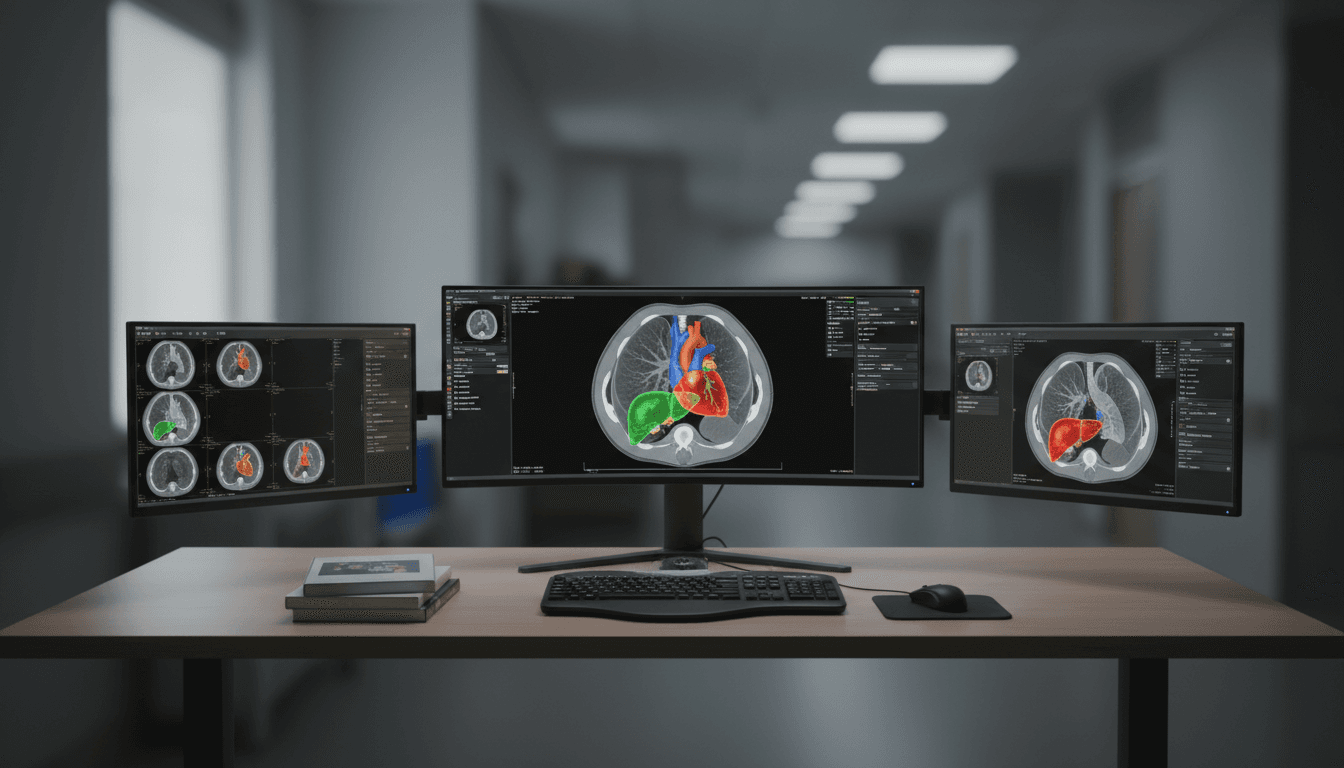

A modern radiológiában a „munkadarab” egyre gyakrabban nem egyetlen kép, hanem több száz szeletből álló 3D térfogat (CT, MR). Ezt végignézni, majd kézzel körberajzolni egy tumort, egy szervhatárt vagy egy érképletet: idő, koncentráció és sokszor idegőrlő rutin. A klinikai valóságban ez nem csak kényelmetlenség, hanem átfutási idő, erőforrás, és végső soron diagnosztikai konzisztencia kérdése.

Pont ezért fontos a 3D orvosi képszegmentálás (medical image segmentation): az a feladat, amikor egy algoritmus voxelről voxelre megmondja, mi tartozik például a májhoz, a veséhez, egy vérzéshez vagy egy áttéthez. A 2025 végén publikált MedNeXt-v2 kutatás egy nagyon praktikus irányt erősít: nem elég csak nagyobb adathalmazt adni a modellnek – a háttérháló (backbone) minősége dönti el, mennyire tanul jól nagy léptékben.

A „Mesterséges intelligencia az egészségügyben” sorozatban sokat beszélünk diagnózistámogatásról és működési hatékonyságról. A MedNeXt-v2 azért érdekes, mert egyszerre szól pontosságról (jobb szegmentálás), skálázhatóságról (18 000 CT-térfogaton előtanítás), és bevezethetőségről (elérhető modellek a jól ismert nnU-Net ökoszisztémában).

Miért épp a 3D szegmentálás a „csendes nyereség” a képalkotásban?

A 3D szegmentálás nem látványos marketing-szólam, hanem a képalkotó folyamat egyik legdrágább pontja. A kulcsmondat: amit ma manuálisan körberajzolnak, azt holnap egy jó modell előrajzolja – és az orvos ellenőriz. Ez óriási különbség.

Hol jelentkezik a haszon a gyakorlatban?

A szegmentálás több terület „alap-infrastruktúrája”:

- Sugárterápia tervezés: céltérfogat és rizikószervek kontúrozása.

- Sebészeti tervezés: anatómiai viszonyok 3D értelmezése.

- Onkológiai követés: tumortérfogat-változás, terápiás válasz mérése.

- Kórházi működés: gyorsabb leletezéshez köthető throughput (különösen akkor, ha sok kontrollvizsgálat érkezik).

És van egy kevésbé emlegetett pont: a szegmentálás standardizálja a mérést. Két szakember kétféle határt húz; egy jó modell viszont ugyanazon szabályok szerint „rajzol”, így a variancia csökken.

Mit állít a MedNeXt-v2, és mi benne az igazi üzenet?

A MedNeXt-v2 fő állítása egyszerű és elég merész: a nagy léptékű felügyelt előtanítás (supervised pretraining) csak akkor fizet igazán, ha a backbone eleve erős reprezentációtanuló. Magyarul: ha a motor rossz, hiába tankolunk tele.

A szerzők több, a gyakorlatban is fontos megfigyelést tettek:

- A megszokott backbone-ok sokszor szuboptimálisak nagy előtanítási pipeline-okban.

- A „from scratch” (nulláról) teljesítmény megbízhatóan előre jelzi a későbbi, előtanított és finomhangolt teljesítményt.

- A reprezentáció skálázása különösen a patológiás szegmentálásnak kedvez (pl. tumor, laesio), nem csak a „szép, szabályos” anatómiai struktúráknak.

- A modalitás-specifikus előtanítás előnye elolvad, ha teljes finomhangolás történik (tehát ha rendesen ráengedjük a céladatra).

Ez utóbbi egészségügyi oldalról kimondottan érdekes: sok intézmény gondolkodik „külön CT-modell” és „külön MR-modell” irányban. A MedNeXt-v2 üzenete ennél pragmatikusabb: ha van jó backbone és van rendes finomhangolás, a tisztán modalitásra szabott előtanítás nem feltétlenül hoz akkora pluszt, mint remélnénk.

Hogyan lett „v2”: mitől erősebb backbone a MedNeXt-v2?

A MedNeXt-v2 a ConvNeXt architektúra 3D-s, volumetrikus szegmentálásra optimalizált vonalán építkezik. A kutatás nem egyetlen trükkről szól, hanem arról, hogy mérnöki fegyelemmel végigtesztelik: mi működik skálán, és mi nem.

3D Global Response Normalization (GRN): stabilabb tanulás volumetrikus adaton

A szerzők beépítenek egy 3D Global Response Normalization (GRN) modult. Ennek lényege, hogy a háló aktivációit úgy normalizálja, hogy a globális válaszok kezelhetőbbek legyenek. 3D-ben ez különösen számít, mert a memória, a kontrasztkülönbségek és a voxeleloszlás miatt könnyű „félretanulni”.

A gyakorlati olvasat: stabilabb reprezentáció → jobb előtanítás → kis adaton finomhangolva is jobb eredmény.

„Compound scaling” 3D-ben: mélység, szélesség, kontextus

A MedNeXt-v2 skálázása három tengely mentén történik:

- Depth scaling: több réteg, mélyebb háló.

- Width scaling: több csatorna, nagyobb kapacitás.

- Context scaling: nagyobb effektív kontextus (3D-ben ez a „mit lát egyszerre a modell” kérdése).

A kontextus különösen fontos patológiánál: egy góc megítélése gyakran nem egy szelet „pixelmintája”, hanem az, hogy hol helyezkedik el, milyen környezetben, milyen alakban folytatódik 3D-ben.

Mit jelent az, hogy 18 000 CT-térfogaton előtanították?

Az előtanítás 18k CT volume-on (18 000 darab 3D vizsgálat) azért nagy szám, mert a 3D tanítás drága: memória, idő, infrastruktúra. A supervised pretraining itt azt jelenti, hogy a modell felügyelt módon tanul reprezentációt, tehát címkézett (annotált) jellegű információval építi fel a „belső világképét”.

Miért számít ez a kórházi bevezetésnél?

Egy intézmény tipikus problémája: van 50–200 jól annotált eset egy speciális feladatra, és kész. Ebből csodát várni nehéz. Ha viszont a kiinduló modell már megtanulta a CT anatómiát és varianciát nagy tömegen, akkor a helyi adaton végzett finomhangolás:

- gyorsabb,

- kevesebb adatot kér,

- jobb általánosítást ad,

- és kevésbé érzékeny a protokoll-variációkra.

A MedNeXt-v2-t a szerzők hat, nehéz CT/MR benchmarkon finomhangolták, összesen 144 struktúrával. A cikk állítása szerint több, publikusan elérhető előtanított modellhez képest konzisztens javulást hozott.

Gyakorlati következmények: mire figyeljen egy intézmény 2026-ban?

A MedNeXt-v2 nem azt üzeni, hogy „holnaptól minden automatikus”. Azt üzeni, hogy a modellválasztás és az előtanítási stratégia már kórházi szinten is stratégiai döntés.

1) Backbone-benchmark nélkül sok projekt elvérzik

Ha egy csapat azonnal „ráhúzza” a legdivatosabb előtanított modellt a saját problémájára, gyakran csalódás jön. A tanulság: érdemes először backbone-okat tesztelni from scratch egy kis piloton.

Egy egyszerű, működő pilot-recept:

- Válassz ki 2–3 backbone-ot (pl. MedNeXt-v2 jellegű ConvNeXt-variánsok + egy transzformer-alapú baseline).

- Tanítsd őket azonos protokollal 30–50 esetre.

- Nézd meg nem csak a Dice-t, hanem:

- határminőséget,

- kis laesiók recallját,

- és a hibák típusát (túl- vs alulszegmentálás).

A cikk egyik legerősebb, „kórháziul is érthető” mondata átírva így hangzik: ami nulláról jobban megy, nagy előtanítás után is általában jobban fog menni.

2) A patológiák kapják a nagyobb hozamot

Ha egy intézmény ROI-t keres, én nem azzal kezdeném, hogy „rajzoljuk ki tökéletesen a lépet”. Kezdeném a patológiával, mert ott:

- több a klinikai döntés,

- nagyobb a variancia,

- és nagyobb a hibaköltség.

A reprezentáció skálázása (nagyobb modell + jobb tanulás) a cikk szerint aránytalanul is segíthet a patológiás szegmentálásban. Ez a diagnózistámogatás egyik legközvetlenebb útvonala.

3) Modalitás-külön modell helyett: finomhangolási fegyelem

Sok helyen a vita arról szól, hogy „CT-re és MR-re külön modellt kell-e”. A MedNeXt-v2 üzenete gyakorlatias: ha teljes finomhangolás van, a modalitás-specifikus előtanítás előnye kicsi lehet.

Ami viszont nem megspórolható:

- jó adatnormalizálás,

- protokoll szerinti adat-szétválasztás (nehogy ugyanaz a beteg kerüljön train és test oldalra),

- és minőségi validáció (nem csak metrika, hanem esetalapú review).

Rövid Q&A: tipikus vezetői és radiológusi kérdések

„Ettől gyorsabb lesz a leletezés?”

Igen, ha a szegmentálást tényleg beépíted a workflow-ba. Az igazi nyereség nem a modell futási ideje, hanem hogy kevesebb a manuális kontúrozás és újramérés.

„Kell hozzá rengeteg helyi adat?”

Nem feltétlenül. Az előtanított modellek pont azt célozzák, hogy kevesebb helyi címkézett adattal is értelmes minőséget érj el. De nulláról induló, validált minimum adatmennyiség akkor is kell.

„Mitől lesz biztonságos?”

A biztonság nem attól lesz meg, hogy „AI-t használunk”, hanem attól, hogy van:

- bevezetési protokoll,

- ember a hurokban (human-in-the-loop),

- drift-monitoring,

- és dokumentált visszamérés.

Hol illeszkedik ez a nagyobb AI-egészségügyi képbe?

A MedNeXt-v2 típusú fejlesztések szerintem egy irányba mutatnak: a képalkotó AI nem egyetlen „okos lelet”, hanem sok apró, automatizált döntés-előkészítő komponens. A szegmentálás ezek közül az egyik legértékesebb, mert egyszerre táplál:

- diagnózistámogató modelleket,

- strukturált leletkészítést,

- terápiatervezést,

- és telemedicinás együttműködést (amikor több helyen kell ugyanazt a struktúrát ugyanúgy értelmezni).

A realitás 2026-ban: aki komolyan gondolja az AI-t az egészségügyben, annak modell-stratégiája lesz, nem csak „egy AI projektje”. A MedNeXt-v2 pedig jó példa arra, hogy a stratégia alapja sokszor unalmasan hangzik: backbone-minőség, skálázás, és fegyelmezett benchmarking.

Ha most indítanék szegmentálási projektet, én azzal kezdeném, hogy kiválasztok egy erős, skálázható backbone-ot, és már az elején úgy mérek, ahogy később élesben is számítani fog: patológiákon, kis gócokon, valós protokoll-varianciában.

A kérdés már nem az, hogy lesz-e AI a képalkotásban. Hanem az, hogy melyik intézmény építi be úgy, hogy a radiológus és a beteg is nyerjen vele.