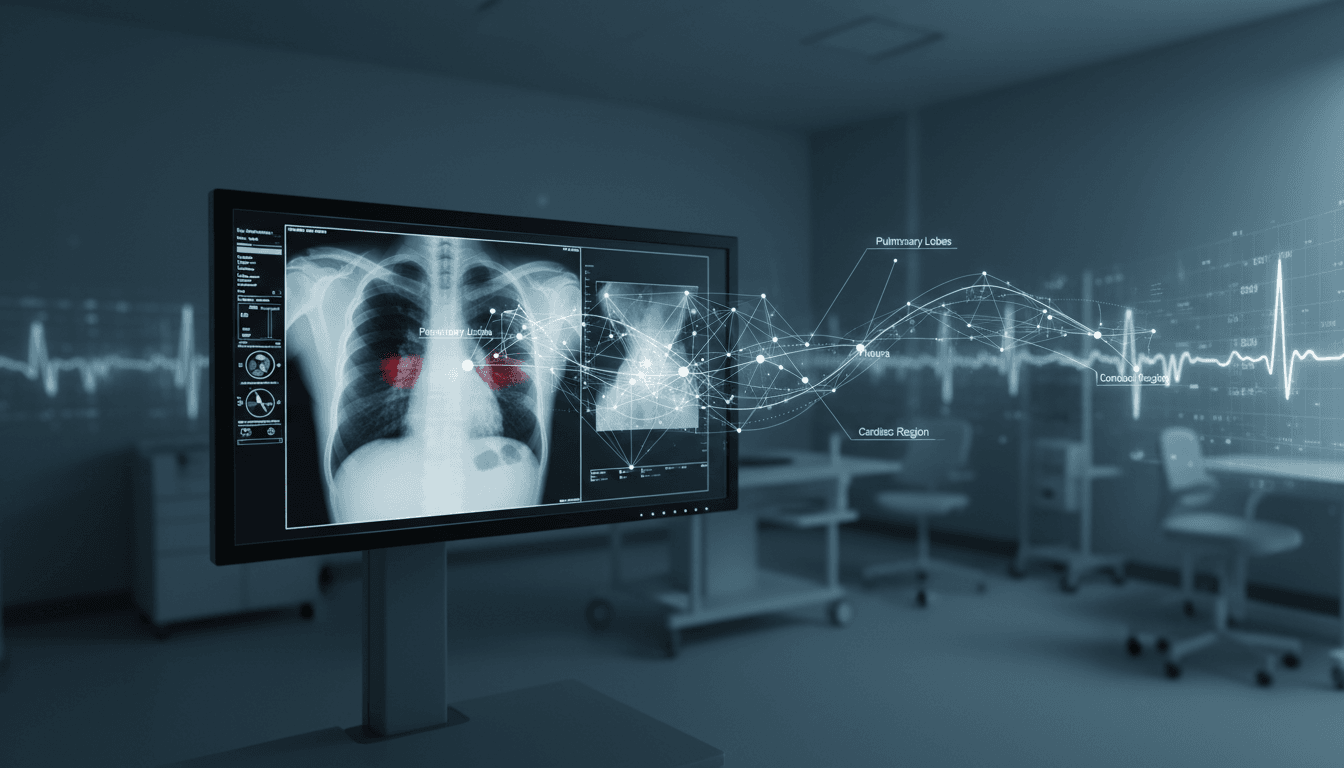

CheXPO-v2: tudásgráf-konzisztenciával csökkenti a mellkasröntgen-AI hallucinációit, és 5k mintával is erős. Nézd meg, mit jelent ez a gyakorlatban.

Kevesebb hallucináció a mellkasröntgen-AI-ban: CheXPO-v2

A mellkasröntgen az egyik leggyakrabban kért képalkotó vizsgálat, mégis sokszor fárasztóan „apró betűs” műfaj: rengeteg normál variáns, kórtörténeti csavar, és a leletben egyetlen elhibázott mondat is félreviszi a döntést. Amikor pedig a mesterséges intelligencia (AI) képet kap és szöveget ad — például válaszol egy klinikai kérdésre vagy magyarázza a látottakat — a legnagyobb kockázat nem az, hogy néha téved. Hanem az, hogy magabiztosan talál ki dolgokat.

A 2025.12.22-én publikált CheXPO-v2 kutatás (mellkasröntgenre épített vizuális-nyelvi modell, azaz VLM) pont ezt a problémát veszi célba: hogyan lehet az AI-t úgy „nevelni”, hogy ne csak jó választ adjon, hanem közben végig követhető, ellenőrizhető és klinikailag koherens gondolatmenetet.

A „Mesterséges intelligencia az egészségügyben” sorozatunkban rendszeresen azt keressük, hol lesz az AI valódi segítség a diagnosztikában — és hol kell fék. Nekem ez a munka azért érdekes, mert egy régi tévhitet bont le: nem attól lesz biztonságosabb egy modell, hogy hosszabban indokol, hanem attól, hogy az indoklása ellenőrizhető egységekre bontható.

Miért hallucinálnak a VLM-ek, és miért baj a „túlmagyarázás”?

A kulcsállítás egyszerű: az orvosi VLM-ek hajlamosak hallucinálni, vagyis olyan állításokat generálni, amelyek nem következnek a képből (vagy a kérdésből), mégis hihetően hangzanak. Ez mellkasröntgenen különösen veszélyes, mert a leletnyelv rutinszerű — a modell könnyen „rááll” tipikus panelekre.

A kutatás szerint a jelenleg népszerű, alacsony költségű megerősítéses tanulási (RL) illesztések — például a GRPO (Group Relative Policy Optimization) — gyakran kimenet-alapú jutalmazással dolgoznak: a modell akkor kap jutalmat, ha a végső válasza jó. Csakhogy ennek mellékhatása van: a modell rájöhet, hogy hosszú, körülményes magyarázattal könnyebb „megvédeni” a választ.

A hosszú indoklás nem bizonyíték

A klinikumban a „túlmagyarázás” ismerős jelenség: egy rossz következtetés is lehet gyönyörűen felépítve. AI-nál ez még rosszabb, mert a Chain-of-Thought típusú hosszú levezetések sokszor:

- nehezen verifikálhatók (mit is állít pontosan a modell?),

- elfedik a konkrét tényhibát,

- és hamis biztonságérzetet keltenek a felhasználóban.

A CheXPO-v2 ebbe nyúl bele: nem azt kérdezi, „helyes-e a végső mondat”, hanem azt, hogy a köztes lépések összhangban vannak-e egy orvosilag értelmezhető tudásstruktúrával.

CheXPO-v2 dióhéjban: folyamat-felügyelet tudásgráffal

A CheXPO-v2 legfontosabb újítása az, hogy az illesztést kimenet-felügyeletről (outcome supervision) részben átteszi folyamat-felügyeletre (process supervision). Magyarul: a modell ne csak „találjon el” valamit, hanem közben következetesen gondolkodjon.

A módszer központi eleme egy Tudásgráf-konzisztencia jutalom (Knowledge Graph Consistency Reward), amelyet entitás–reláció illesztés (Entity-Relation Matching) vezérel.

Tripletek: „Betegség – Reláció – Anatómia”

A CheXPO-v2 a modell magyarázatát nem egyben nézi, hanem feldarabolja ellenőrizhető „atomokra”. Ezek a tripletek ilyenek:

- Betegség (pl. pleurális folyadék, pneumothorax, infiltrátum)

- Reláció (pl. „jelen van”, „nincs”, „kiterjed”, „lokalizálódik”, „súlyosbodik”)

- Anatómia (pl. jobb alsó lebeny, pleuratér, hilus)

Ez azért nagy szám, mert egy röntgenlelet tipikusan ilyen mikróállítások sorozata. Ha a modell azt írja: „bal oldali pneumothorax látható”, akkor az megfeleltethető egy (pneumothorax – jelen van – bal pleuratér) típusú állításnak.

Mit jutalmaz a rendszer, és mit büntet?

A rendszer a tripletek szintjén képes:

- jutalmazni a konzisztens, orvosilag értelmes kapcsolatrendszert,

- büntetni az inkonzisztens vagy „odadobott” állításokat (klasszikus hallucináció),

- és visszafogni a körítés jellegű, ellenőrizhetetlen „okoskodást”.

Ezt én úgy szoktam elmagyarázni laikusoknak, hogy nem esszét javítunk, hanem állításlistát pipálunk: az AI nem „szép beszédért”, hanem ellenőrizhető egységekért kap pontot.

Miért számít ez a diagnosztikában? (MIMIC-CXR-VQA és 5k minta)

A szerzők azt állítják, hogy a CheXPO-v2 jelentősen felülmúlja a GRPO-t és több erős alapmodellt olyan benchmarkokon, mint a MIMIC-CXR-VQA (mellkasröntgen kérdés–válasz feladatok). Két részlet különösen fontos a kórházi bevezethetőség szempontjából:

- Adatéhség csökkentése: az új állapotcsúcs pontosságot (SOTA) mindössze 5 000 mintával is elérik.

- Ellenőrizhetőbb érvelés: nemcsak az a cél, hogy jó legyen a válasz, hanem hogy a magyarázat „szétszerelhető” legyen klinikai logikára.

Miért nagy dolog az 5 000 minta?

Az egészségügyben a minőségi annotáció drága. Röntgen-VQA feladatban ráadásul nem elég „címkézni” — sokszor kontextus, kérdés, válasz és levezetés is kell. Ha egy módszer kevesebb mintából is erős, az:

- gyorsabb pilotot,

- olcsóbb finomhangolást,

- és intézményi szintű adaptációt tesz reálisabbá.

A valóság az, hogy a legtöbb kórház nem tud tízezres-többszázezres, tökéletesen tisztított adathalmazokat előállítani. Az adatefficiencia tehát nem „szép bónusz”, hanem a bevezethetőség egyik feltétele.

Hogyan néz ki ez egy kórházi workflow-ban?

A legjobb diagnosztikai AI nem az, ami „átveszi” a radiológus helyét, hanem az, ami csökkenti a hibák esélyét és gyorsítja a döntést. A CheXPO-v2 típusú megközelítést három gyakorlati helyen látom különösen erősnek.

1) Lelet-ellenőrzés és „konzisztencia riasztás”

Válasz elsőként: a tudásgráf-alapú konzisztencia alkalmas arra, hogy a modell saját szövegében találjon ellentmondást.

Példa: ha a modell egyszer azt írja, „nincs pleurális folyadék”, később meg „bal oldali pleurális folyadék kismértékben”, az tripletszinten ütközik. Egy ilyen riasztás nem diagnózist ad, hanem minőségbiztosítást.

2) VQA a triázs támogatására (szigorú korlátokkal)

Az AI-alapú VQA (kérdés–válasz) akkor hasznos, ha:

- a kérdés szabályozott („Van-e pneumothorax?”),

- a válasz rövid és strukturált,

- és a rendszer hozzáteszi a tripletek szintű indoklást (mi alapján).

Itt a CheXPO-v2 üzenete az, hogy a rövidebb, atomokra bontott magyarázat sokszor biztonságosabb, mint a hosszú narratíva.

3) Oktatás: „miért ezt gondoljuk a röntgenen?”

A rezidensképzésben rengeteget számít, hogy a megfigyelések és a következtetések szétváljanak. A tripletek pont ezt kényszerítik ki:

- mi a jelenség?

- hol van?

- milyen relációban áll a diagnózissal?

Ha az AI erre van ránevelve, oktatási segédként is jobb: nem csak kimondja, hanem szerkezetben mutatja.

Amitől ez még nem „kész termék”: biztonság, szabályozás, felelősség

Válasz elsőként: a CheXPO-v2 egy erős irány, de nem helyettesíti a klinikai validációt és a kockázatkezelést.

Három területet érdemes nagyon konkrétan kezelni, ha valaki kórházi pilotban gondolkodik:

Adateltérés (domain shift)

A MIMIC jellegű adatok nem ugyanazok, mint egy magyar kórház heterogén gépparkja, protokolljai, populációja. A modell lehet kiváló benchmarkon, és közepes a helyi valóságban. Ez ellen:

- helyi kalibráció,

- folyamatos teljesítménymérés,

- és „out-of-distribution” jelzés kell.

Hallucináció ≠ csak tényhiba

A hallucináció lehet:

- anatómiai (rossz oldal/terület),

- relációs („nincs” vs „van”),

- vagy következtetési (túl messzire megy).

A tripletek azért jók, mert mindhárom típus célzottan „fogható”. De a klinikai felelősséget ettől még nem veszik le a rendszerről.

Ember a körben (human-in-the-loop)

Ha diagnosztikában AI-t használunk, a minimum:

- a felhasználó lássa, mit állít a rendszer (strukturáltan),

- legyen visszajelzési csatorna (hibajelentés),

- legyen protokoll, mikor nem használható (rossz minőség, hiányzó projekció, sürgős esetek stb.).

Egy diagnosztikai AI akkor jó, ha gyorsít — de közben nem kéri el a bizalmat bizonyíték nélkül.

Gyakori kérdések, amiket a döntéshozók feltesznek

„Ha a modell rövidebben magyaráz, nem lesz kevésbé átlátható?”

Nem. A rövidség nem cél, az ellenőrizhetőség a cél. A tripletek szintű magyarázat sokszor átláthatóbb, mint egy féloldalas narratíva.

„Ez személyre szabott diagnózist ad?”

Nem így. A „preference optimization” itt inkább azt jelenti, hogy a modellt a kívánatos viselkedéshez igazítják (kevesebb hallucináció, koherensebb érvelés), nem azt, hogy betegszinten személyre szab.

„Mire jó ez 2026-ban egy magyar intézményben?”

A legreálisabb első lépés szerintem a minőségbiztosítás és döntéstámogatás: strukturált megállapítások, konzisztencia-ellenőrzés, triázs jellegű kérdések szigorú keretben.

Következő lépés: hogyan lesz ebből lead és valódi pilot?

A CheXPO-v2 üzenete a gyakorlatnak szerintem kristálytiszta: a diagnosztikai AI értéke nemcsak a pontosság, hanem az, hogy a hibát ne tudja „szép szöveggel” eltakarni. A tudásgráf-konzisztencia és a folyamat-felügyelet pont ebbe az irányba tolja a mezőnyt.

Ha intézményi oldalon gondolkodsz (radiológia, sürgősségi, minőségirányítás, IT), én a pilotot így keretezném:

- Válasszatok 1–2 konkrét klinikai kérdést (pl. pneumothorax, pleurális folyadék).

- Határozzátok meg a „nem használható” eseteket (minőség, projekció, eszköz).

- Mérjetek: pontosság és konzisztencia (ellentmondás/100 vizsgálat).

- Építsetek visszacsatolást: radiológusi jelölésekből finomhangolható szabályok/tripletek.

A „Mesterséges intelligencia az egészségügyben” sorozatban én ezt a vonalat látom a legérettebbnek 2026 küszöbén: nem több AI-szöveg kell a diagnosztikába, hanem jobban számonkérhető állítások.

Te melyik részét tartod a legnagyobb féknek a saját környezetedben: az adatminőséget, a workflow-integrációt, vagy a felelősségi/szabályozási kérdéseket?