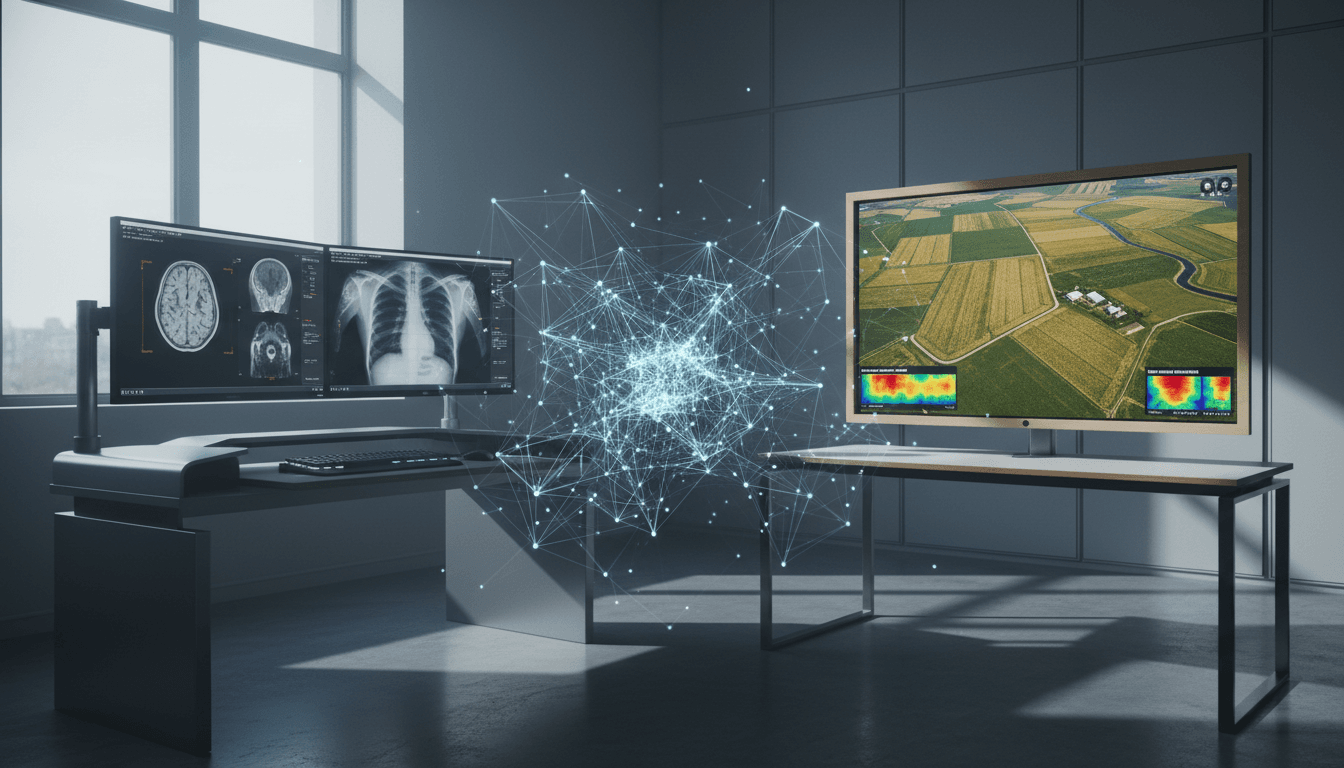

LaLoRA: új megközelítés a LoRA finomhangolás felejtésének csökkentésére. Stabilabb AI diagnosztikában és agrárképfeldolgozásban.

LoRA felejtés nélkül: megbízhatóbb AI a gyakorlatban

Egy telepített AI-modellnél nem az a legnagyobb kockázat, hogy néha téved — hanem az, hogy csendben „átneveljük” egy új feladatra, és közben elveszíti azt a tudást, amiért eredetileg bevezettük. A gépi tanulásban ezt nevezik katasztrofális felejtésnek, és 2025 végén, amikor egyre több szervezet akar gyorsan testre szabni nagy nyelvi modelleket (LLM-eket), ez már nem elméleti probléma, hanem üzemeltetési.

A 2025.12-ben megjelent friss kutatás egy konkrét irányt mutat: hogyan lehet LoRA-val (Low-Rank Adaptation) finomhangolni úgy, hogy közben kevesebbet felejtsen a modell. A szerzők LaLoRA néven egy súlytérbeli regularizációt javasolnak, amely a Laplace-közelítésből indul ki, és azt a gyakorlatias kérdést teszi kezelhetővé: mely paraméterekhez „szabad” hozzányúlni, és melyekhez nem?

És bár a kampányunk fókusza a mesterséges intelligencia az egészségügyben, ezt a gondolatot nem érdemes bezárni a kórház falai közé. Ugyanez a kihívás köszön vissza a precíziós mezőgazdaságban és agrártechnológiában is: szenzorok, drónfelvételek, szezonális mintázatok, új fajták, új kártevők — a modellnek tanulnia kell, de nem felejthet.

Miért „felejt” a LoRA, és miért baj ez a terepen?

A rövid válasz: mert a finomhangolás során a modell paraméterei olyan irányokban mozdulnak el, amelyek elrontják a korábbi reprezentációkat. LoRA ugyan „parameter-efficient” (kevés plusz súlyt tanítunk), de ettől még a modell viselkedése jelentősen megváltozhat.

LoRA egy mondatban (gyakorlati szemmel)

A LoRA lényege, hogy nem a teljes modellt finomhangoljuk, hanem alacsony rangú (low-rank) mátrixokkal adunk hozzá egy „korrekciót” bizonyos rétegekhez. Ettől:

- gyorsabb a tanítás,

- kevesebb GPU-memória kell,

- könnyebb több feladatra külön „adaptereket” fenntartani.

A gond ott kezdődik, amikor a célfeladat adatai erősen eltérnek az eredeti tanítási eloszlástól. Ilyenkor az adapterek olyan irányba viszik a modellt, hogy:

- diagnosztikában romolhat egy korábban stabil triázs-logika,

- telemedicinában elcsúszhat az utasításkövetés,

- agrárképeknél elfelejtheti a korábban jól működő „általános vizuális” mintákat (árnyék, talajtextúra, levélerezet), miközben új betegségjelekre optimalizáljuk.

A katasztrofális felejtés nem látványos hiba, hanem bizalmi erózió: egyszer csak nem azt kapod vissza a modelltől, amit tegnap még tudott.

LaLoRA: Laplace-alapú „korlát” a LoRA-súlyokra

A rövid válasz: a LaLoRA megbecsüli, mely paraméterirányok „érzékenyek” (nagy görbületűek), és ezekben az irányokban visszafogja a frissítést. Ezzel a modell jobban őrzi a korábbi tudását.

A paper ötlete elegáns abban az értelemben, hogy nem próbál mindent újraértelmezni: a szerzők a Laplace-közelítést használják, ami a Bayes-i gondolkodásból ismert eszköz a paraméterbizonytalanság (vagy itt: „konfidencia”) közelítésére.

Mit jelent a „görbület”, és miért számít?

A veszteségfüggvény (loss) tájképét képzeld el úgy, mint egy domborzati térképet:

- nagy görbületű irány: meredek völgy, kicsi elmozdulás is nagy teljesítményváltozást okoz

- kis görbületű irány: laposabb rész, itt biztonságosabb kísérletezni

LaLoRA azt mondja: ha egy irány nagyon meredek, akkor ott a modell „biztos” volt valamiben — ne rángassuk el onnan agresszíven. Ehelyett inkább a laposabb irányokban tanuljon.

Miért fontos, hogy „csak” a LoRA-súlyokra alkalmazzák?

A gyakorlati nyereség: könnyű marad. A Laplace-közelítés klasszikusan drága lehet, ha az egész nagy modellt akarod lefedni. Itt viszont a szerzők csak az adapterekre teszik rá, így:

- nem borítja fel a LoRA egyszerűségét,

- skálázhatóbb üzemeltetési döntés marad,

- adapter-szintű kontrollt kapsz.

A cikkben a módszert egy Llama modell matematikai gondolkodásra hangolásán mutatják be, és azt állítják: javul a tanulás–felejtés kompromisszum, ráadásul ez a kompromisszum a regularizáció erősségével közvetlenül szabályozható.

Mit jelent ez az egészségügyben (diagnosztika, képalkotás, triázs)?

A rövid válasz: a LaLoRA-típusú megközelítések stabilabbá teszik a folyamatos finomhangolást, ami az egészségügyi AI bevezetés egyik legkritikusabb pontja.

1) Orvosi képalkotás: új protokollok, régi tudás

Egy radiológiai modell (pl. tüdő CT vagy mammográfia) sokszor intézményenként eltérő:

- más géppark,

- más kontrasztanyag-protokoll,

- más annotációs szokások,

- más betegpopuláció.

LoRA-val gyorsan lehet intézményi adaptációt csinálni. De ha közben romlik a korábban stabil „általános” teljesítmény (például ritka leleteknél), akkor az üzemeltetés rizikója ugrik. A LaLoRA logikája itt azt adja, amit a klinikai csapatok kérnek: kontrollált változás.

2) Telemedicina és betegkommunikáció: konzisztens stílus és biztonság

Ha egy LLM-et helyi ellátási útvonalakra, gyógyszernevekre, beutalási rendekre hangolsz, nem fér bele, hogy közben:

- gyengébb legyen az általános utasításkövetés,

- „elcsússzon” a biztonságos válaszadás,

- több hallucináció jelenjen meg.

Itt a felejtés mérséklése nem luxus, hanem betegbiztonsági követelmény.

3) Kórházi működésoptimalizálás: folyamatos tanulás drift mellett

A műtői kapacitás, ágyszámtervezés, sürgősségi várólisták mind szezonálisak (influenza-szezon, ünnepi időszak, járványhullámok). A modellnek alkalmazkodnia kell, de nem felejtheti el az alapösszefüggéseket. A LaLoRA-féle „ne nyúlj a meredek irányokhoz” szemlélet jól illik ehhez.

És hol jön képbe a mezőgazdaság? Ugyanaz a drift, más terep

A rövid válasz: a precíziós gazdálkodásban a drift nem kivétel, hanem alapállapot, ezért a felejtéscsökkentő LoRA-adaptáció különösen értékes.

A blog-sorozatunkban sokszor előjön, hogy a mezőgazdasági AI egyszerre „adatéhes” és „adat-széttöredezett”: parcellánként, évjáratonként, fajtánként, talajtípusonként változik minden.

Konkrét példa: növénybetegség-felismerés több szezonon át

Tegyük fel, hogy van egy drónképeken tanított modell, ami 2023–2025 között jól felismeri a levélfoltosságot. 2026-ban viszont:

- új fajta kerül be,

- más a növényvédőszer-használat,

- szokatlanul csapadékos tavasz volt.

A modell új adatot kap, finomhangolod LoRA-val. Ha felejt, könnyen előfordul, hogy:

- az új fajta jobban megy,

- de a régi fajtákon romlik,

- vagy a korábban jól kezelt fényviszonyok (ellenfény, árnyék) miatt újra hibázik.

LaLoRA-szerű regularizációval cél: tanuljon az új szezonból, de tartsa meg a stabil „vizuális alapokat”.

Miért jó ez a „precision ag” üzemi realitásában?

- kevesebb újratanítási ciklus,

- kiszámíthatóbb modellverziók,

- könnyebb audit és visszamérés,

- kisebb esély, hogy egy gyors adapter-frissítés „szétver” egy korábban működő pipeline-t.

Hogyan érdemes gondolkodni a bevezetésről? (praktikus ellenőrzőlista)

A rövid válasz: ne csak azt mérd, mit tanult meg az új adaton — mérd azt is, mit rontott el a régi feladatokon.

1) Kétirányú értékelés: tanulás és felejtés

Én a gyakorlatban ezt két külön dashboardként szeretem látni:

- Célfeladat metrikák (pl. új intézményi adatokon AUC/F1, vagy új kártevő felismerési pontosság)

- Megőrzési metrikák (korábbi validációs készleteken ugyanazok a metrikák)

Ha csak az első van, az a „gyors siker” csapdája.

2) Regularizációs erő: üzleti döntés, nem csak hiperparaméter

A LaLoRA egyik ígérete, hogy a felejtés–tanulás kompromisszum direkt állítható. Ezt érdemes úgy kezelni, mint egy kockázati csúszkát:

- ha klinikai döntést támogat: inkább konzervatív

- ha belső folyamatot optimalizál: lehet bátrabb

- ha agrár-előrejelzés és kockázatkezelés: a „rossz riasztás vs. kihagyott riasztás” aránytól függően állítsd

3) Milyen adaton „mérd fel” a konfidenciát?

A cikk külön vizsgálja, hogy a Laplace-hoz használt adatok hogyan hatnak. Gyakorlatban ez azt jelenti: ne rutinból válassz.

- Ha általános tudást akarsz megőrizni, legyen benne a régi eloszlásból is.

- Ha intézményi stabilitást akarsz, legyen reprezentatív a helyi forgalomra.

4) Robusztusság hiperparaméterekre

A való életben nem az nyer, ami laborkörülmények közt szép, hanem ami kevésbé érzékeny a beállításokra. A paper robusztusságot is elemez — ezt én jó jelnek veszem, de ettől még pilot nélkül nem engedném élesbe.

Gyors Q&A: amit a csapatok tényleg meg szoktak kérdezni

„Elég, ha adaptereket tárolunk feladatonként?”

Adapterekkel sokat nyersz, de a felejtés nem csak tárolási kérdés. Az új adapter betanítása is ronthat a viselkedésen bizonyos teszteken, főleg, ha a kiértékelésed nem elég széles.

„A felejtéscsökkentés nem lassítja le a tanulást?”

De, jellemzően van ára. A cél az, hogy tudatosan fizess érte, és kontrolláltan. Egészségügyben és termeléskritikus agrárfolyamatokban ez az ár sokszor olcsóbb, mint egy regresszió miatti leállás.

„Ez csak LLM-ekre vonatkozik?”

A gondolat nem. A drift és a felejtés minden adaptált modellnél felmerül (kép, idősor, tabuláris). A LoRA a transformer-ökoszisztémában lett sztenderd, de a tanulság általános.

Mit vigyél magaddal ebből a 2025.12-es friss irányból?

A LaLoRA üzenete egyszerű és hasznos: ne egyformán taníts mindent. A paraméterek (vagy LoRA-súlyok) egy része „tartóoszlop”, más része „változtatható burkolat”. Ha ezt a különbséget be tudod építeni a finomhangolásba, kevesebb lesz a váratlan regresszió.

A „Mesterséges intelligencia a mezőgazdaságban és agrártechnológiában” sorozatban gyakran írunk arról, hogyan lesz az AI-ból napi szintű eszköz a gazdaságban. Ugyanez a minta az egészségügyben is: a modellek nem egyszeri projektek, hanem hosszú életű rendszerek. Márpedig hosszú életnél a felejtés a legdrágább hiba.

Ha most tervezel LoRA-alapú finomhangolást diagnosztikában, telemedicinában vagy agrárképfeldolgozásban, én ezt javaslom következő lépésnek: állíts fel egy „tanulás vs. megőrzés” mérőrendszert, és kezeld a regularizációt kockázati döntésként. A kérdés nem az, hogy a modelled tud-e tanulni. Az, hogy tud-e tanulni úgy, hogy közben ne veszítsd el a bizalmat benne.