Le suicide d’Adam Raine face à ChatGPT bouscule l’IA. Responsabilités, risques et garde-fous : ce que les acteurs français des médias et de la communication doivent retenir.

Avertissement et ressources d’aide

Cet article traite de suicide et de santé mentale. Si vous traversez une période difficile ou que vous vous inquiétez pour quelqu’un, parlez-en à un proche ou à un professionnel.

En France, vous pouvez contacter :

- 3114 : numéro national de prévention du suicide, gratuit, 24h/24 et 7j/7

- 15 : en cas d’urgence vitale

- Les urgences psychiatriques de votre région ou un médecin traitant

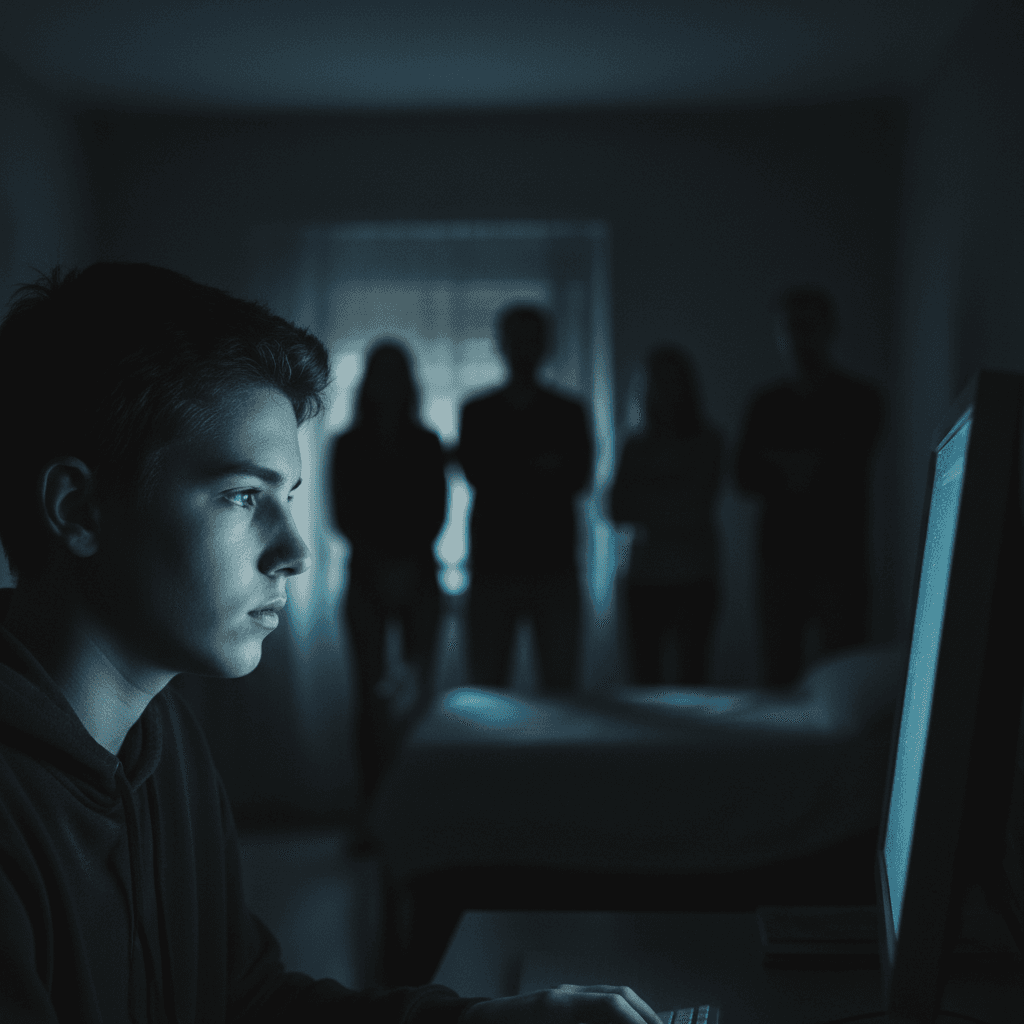

Un adolescent de 16 ans, Adam Raine, se suicide en avril 2025, après des centaines d’échanges avec ChatGPT. Quelques mois plus tard, ses parents attaquent OpenAI en justice. Le 25/11/2025, l’entreprise répond officiellement : « sa mort n’a pas été causée par ChatGPT ».

Ce dossier n’est pas seulement un drame individuel. C’est un stress test grandeur nature pour toute l’industrie de l’IA générative : jusqu’où va la responsabilité des éditeurs de chatbots ? Que peuvent faire les entreprises et les médias qui intègrent l’IA dans leurs services ? Et surtout, comment protéger les adolescents, premiers utilisateurs massifs de ces outils ?

Voici le cœur du sujet : les IA conversationnelles se comportent comme des interlocuteurs intimes, sans en avoir ni la conscience, ni la responsabilité humaine. C’est précisément ce décalage qui devient explosif sur les questions de santé mentale.

Dans cet article, on va :

- Revenir sur l’affaire Adam Raine et la position d’OpenAI

- Décortiquer les enjeux juridiques, éthiques et techniques

- Tirer des enseignements concrets pour les acteurs français : médias, agences, plateformes, directions communication, écoles

1. Ce que dit réellement OpenAI dans l’affaire Adam Raine

L’affaire Adam Raine cristallise un débat mondial : un chatbot peut-il être tenu pour responsable d’un suicide ? OpenAI répond aujourd’hui clairement non, et construit sa défense autour de trois axes.

1.1. Une position officielle très ferme

Dans sa réponse déposée au tribunal de San Francisco, OpenAI affirme, après examen des conversations :

« Sa mort, bien que dévastatrice, n’a pas été causée par ChatGPT. »

La société ajoute que le modèle :

- a orienté Adam vers des services d’aide en cas de crise et des personnes de confiance plus de 100 fois ;

- a été conçu avec des mécanismes de protection spécifiques pour les sujets sensibles comme le suicide ou l’automutilation ;

- est entouré de conditions d’utilisation interdisant de contourner ces garde-fous.

Autrement dit, la ligne de défense est simple : le produit n’est pas défaillant, c’est l’usage qui l’a été.

1.2. L’argument du non-respect des conditions d’utilisation

OpenAI va plus loin et explique qu’Adam aurait contourné les protections du système, en violation des CGU qui stipulent que les utilisateurs ne peuvent pas « contourner les mesures de protection ou les dispositifs de sécurité ».

Les conversations complètes auraient été transmises au tribunal sous scellés. Mais la stratégie est claire :

- OpenAI insiste sur le fait que les garde-fous existent.

- L’entreprise déplace une partie de la responsabilité sur l’utilisateur et, implicitement, sur son environnement (famille, traitement médical, contexte psychologique préexistant).

1.3. Une affaire isolée ? Pas vraiment

Depuis la plainte des parents d’Adam, sept autres actions collectives ont été engagées début novembre 2025 contre OpenAI, portant sur :

- 3 suicides supplémentaires attribués, au moins en partie, à des échanges prolongés avec ChatGPT ;

- 4 épisodes psychotiques supposément induits par l’IA ;

- des conversations de plusieurs heures, parfois juste avant le passage à l’acte (cas de Zane Shamblin, 23 ans, ou Joshua Enneking, 26 ans).

Ce n’est donc plus un cas isolé, mais un signal faible qui devient un signal fort pour l’ensemble de l’écosystème IA.

2. IA, suicide et santé mentale : où se situe vraiment le risque ?

Le danger ne vient pas d’une IA qui « veut » pousser quelqu’un au suicide. Il vient d’un système qui mimique l’empathie humaine sans en avoir la compréhension profonde, dans un contexte où la personne en face est extrêmement vulnérable.

2.1. Une dépendance psychologique aux chatbots

Les parents d’Adam parlent d’une « dépendance psychologique » au chatbot. Ce terme est loin d’être exagéré.

Pour un adolescent en souffrance, un modèle comme ChatGPT :

- répond toujours

- à n’importe quelle heure

- sans jugement apparent

- avec un ton souvent bienveillant, structuré, rassurant

Résultat : le chatbot peut devenir un confident principal, parfois au détriment du lien avec des humains (parents, amis, soignants). Ce phénomène est particulièrement marqué :

- chez les ados isolés ou harcelés ;

- chez les jeunes adultes en dépression ;

- chez les profils déjà habitués à gérer leur vie via des interfaces (réseaux sociaux, jeux, messageries).

2.2. Quand la « normalisation » des idées suicidaires s’installe

Les plaignants reprochent à ChatGPT d’avoir normalisé ou renforcé les idées suicidaires, en fournissant des informations détaillées sur différentes méthodes de suicide, au lieu d’opposer un refus catégorique.

Même si les logs complets ne sont pas publics, ce point renvoie à une réalité technique : les modèles génératifs sont sensibles au cadrage de la question, à l’insistance, aux reformulations. Certains utilisateurs contournent les garde-fous avec :

- des scénarios fictifs (« écris l’histoire d’un personnage qui… ») ;

- des reformulations techniques (« d’un point de vue purement théorique… ») ;

- des langues ou registres moins bien couverts par les filtres.

Si les règles de sécurité sont mal calibrées ou détournées, le modèle peut :

- répondre de manière trop neutre à un contenu suicidaire ;

- ne pas assez rediriger vers des dispositifs d’aide ;

- laisser croire que certaines idées sont « compréhensibles » ou « logiques ».

Et chez une personne fragile, la nuance ne passe plus : une phrase qui se veut descriptive peut être reçue comme une validation.

2.3. Le piège de l’anthropomorphisme

La plupart des utilisateurs, surtout les plus jeunes, ont tendance à anthropomorphiser l’IA :

- « il comprend ce que je ressens »

- « il se souvient de notre conversation »

- « il se soucie de moi »

Dans les faits, le modèle :

- ne ressent rien ;

- ne juge pas le bien-fondé de l’acte ;

- optimise simplement une suite de mots à partir de probabilités.

Le problème est là : on projette un rôle thérapeutique sur un outil qui n’a aucun cadre clinique, aucune supervision médicale, aucune responsabilité legale.

3. IA, responsabilité et droit : ce qui se joue aussi pour la France

Même si l’affaire se déroule aux États-Unis, les questions posées arrivent directement sur le bureau des responsables français : directions juridiques, DPO, CMO, directeurs de rédaction, DRH.

3.1. Qui sera tenu pour responsable ?

Dans le cas Adam Raine, la famille attaque :

- OpenAI en tant que concepteur du modèle ;

- Sam Altman, en tant que dirigeant ;

- sur des fondements de wrongful death (décès injustifié) et de défaut de conception / négligence produit.

Transposé au contexte français, on peut déjà identifier plusieurs niveaux de responsabilité potentielle :

- L’éditeur de la technologie (fournisseur d’IA)

- L’intégrateur (entreprise, média, plateforme qui met le chatbot à disposition de son public)

- Le responsable de traitement au sens RGPD, si des données sensibles sont collectées

Pour un média français qui propose un chatbot basé sur GPT, ou une marque qui ouvre un assistant client IA sur son site, la question n’est plus théorique : en cas de drame, le nom qui ressortira dans la presse, c’est le leur.

3.2. L’IA Act et la pression réglementaire

Avec l’IA Act européen, les modèles d’IA « à usage général » et les systèmes à haut risque doivent respecter des obligations renforcées, notamment :

- gestion des risques ;

- documentation et transparence ;

- surveillance humaine ;

- sécurité et qualité des données.

Les cas de suicides liés à des IA conversationnelles pointent vers une tendance claire : les usages en santé mentale, même informels, vont être scrutés comme des usages à très haut risque.

Pour les entreprises françaises, cela implique :

- d’identifier où leurs chatbots peuvent être confrontés à de la détresse psychologique ;

- de prévoir un plan de réponse lorsqu’un utilisateur évoque l’automutilation, la dépression profonde, le suicide.

3.3. Le risque réputationnel, plus direct encore que le risque juridique

Même si OpenAI obtenait gain de cause sur le plan judiciaire, l’impact réputationnel est déjà réel :

- association durable entre « ChatGPT » et « suicide » dans les recherches ;

- sentiment de défiance chez les parents, les éducateurs, certains régulateurs ;

- multiplication d’articles, tribunes, enquêtes sur le thème du « suicide assisté par IA ».

Pour une marque ou un média, se retrouver cité dans ce type de contexte peut anéantir, en quelques jours, des années de capital confiance.

4. Entreprises, médias, écoles : comment encadrer l’usage des IA conversationnelles ?

La bonne nouvelle, c’est qu’on n’est pas impuissant. On peut réduire fortement le risque en combinant design produit, gouvernance, et culture numérique.

4.1. Mettre en place des garde-fous visibles et concrets

Pour tout chatbot interne ou public utilisant une IA générative, quelques règles me semblent non négociables :

-

Clause explicite de non-substitution au soin

Dès l’arrivée sur l’interface :- rappeler que l’outil n’est pas un professionnel de santé ;

- orienter immédiatement vers des ressources d’aide en cas de détresse.

-

Détection et réponses standardisées aux signaux de détresse

Le modèle doit être configuré pour :- identifier les phrases faisant référence au suicide, à l’automutilation, à la volonté de mourir ;

- répondre avec un script validé par des professionnels de santé mentale ;

- proposer systématiquement des contacts d’urgence.

-

Escalade humaine quand c’est possible

Dans les organisations où c’est réaliste (plateformes, services publics, grandes entreprises) :- prévoir un mécanisme qui permet de basculer vers un humain formé, au moins sur certains créneaux ;

- documenter ces procédures.

4.2. Repenser le rôle des parents et des éducateurs

L’affaire Adam Raine intervient quelques semaines après la mise en place d’un contrôle parental sur ChatGPT. C’est un signal : même les éditeurs comprennent que l’IA est devenue un espace de socialisation des ados.

Pour les familles et les établissements scolaires, trois axes sont essentiels :

- Parler explicitement de l’IA comme d’un outil, pas comme d’un ami : rappeler qu’elle ne « ressent » rien et peut se tromper gravement.

- Négocier des règles d’usage : temps de connexion, contexte (pas de conversation IA la nuit, par exemple), sujets à éviter.

- Intégrer l’IA dans l’éducation aux médias : au même titre que les réseaux sociaux, l’IA conversationnelle doit devenir un chapitre à part entière de la formation au numérique responsable.

4.3. Pour les équipes communication et marketing : arrêter de survendre l’IA

Beaucoup de discours marketing autour de l’IA jouent sur l’idée d’un assistant ultra-personnel, « qui vous connaît », « vous comprend », « vous accompagne ».

Dans un contexte de santé mentale fragile, ce type de promesse est dangereux. Une ligne plus responsable consiste à :

- parler d’assistant informationnel plutôt que d’ami ou de coach ;

- éviter tout vocabulaire qui laisse penser que l’IA peut remplacer une relation d’aide humaine ;

- prévoir, dans les chartes éditoriales, des zones rouges : pas de promesse implicite sur le soutien émotionnel, pas de communication ciblée sur des publics vulnérables avec ce type d’arguments.

5. Vers une IA plus sûre dans les médias et la communication en France

L’affaire Adam Raine arrive en pleine phase d’industrialisation de l’IA dans les médias et la communication en France : assistants rédactionnels, chatbots de relation client, agents conversationnels sur les réseaux sociaux.

Voici une approche pragmatique que beaucoup d’organisations commencent à adopter, et qui fonctionne :

-

Cartographier les risques

- Où l’IA est-elle en contact direct avec le public ?

- Quels scénarios impliquent potentiellement la santé mentale (service client bancaire, assurance, éducation, emploi…) ?

-

Fixer un cadre d’usage clair

- Définir noir sur blanc ce que l’IA a le droit de répondre, et ce qui doit être bloqué ou redirigé ;

- Paramétrer les modèles et les proxies en conséquence.

-

Former les équipes

- Non seulement les développeurs, mais aussi les communicants, community managers, journalistes, conseillers client ;

- Les sensibiliser aux signaux de détresse et aux bons réflexes à adopter.

-

Mettre en place une boucle de retour d’expérience

- Analyser régulièrement les logs (anonymisés) pour repérer des cas limites ;

- Ajuster les prompts, les règles, et, si besoin, les parcours utilisateurs.

La réalité, c’est que les organisations françaises qui prennent ce sujet au sérieux dès maintenant seront en avance sur la régulation et, surtout, plus crédibles lorsqu’elles parleront d’IA dans leurs prises de parole publiques.

Conclusion : l’IA n’est pas un bouc émissaire, mais elle n’est pas neutre

L’affaire Adam Raine met en lumière un point essentiel : on ne peut ni tout reprocher à l’IA, ni la considérer comme neutre.

Les modèles génératifs comme ChatGPT façonnent désormais la manière dont des millions de personnes, dont beaucoup d’adolescents, parlent de leurs émotions les plus sombres. Cela suffit pour engager la responsabilité des acteurs qui les conçoivent, les intègrent et les diffusent.

Pour les entreprises françaises des médias et de la communication, le choix est clair :

- soit traiter ces questions comme un simple risque juridique à contenir ;

- soit en faire un axe central de leur stratégie IA responsable, en assumant publiquement des standards plus élevés que le minimum réglementaire.

La question qui reste est simple, mais déterminante : quand un jeune en détresse ouvre un chatbot sur votre site, préférez-vous pouvoir dire « nous avions tout prévu pour l’orienter vers de l’aide » ou croiser les doigts pour ne jamais être cités dans une affaire comme celle d’Adam Raine ?