La course IA OpenAI–Google révèle une leçon : l’IA utile est fiable et bien intégrée. Voici comment l’Algérie peut moderniser l’administration et la formation.

Course IA : un signal fort pour moderniser l’État algérien

Le 06/12/2025, une info a fait sursauter le secteur : OpenAI serait passé en « code red », un mode d’urgence interne, pour remettre ChatGPT au niveau face à la montée de Gemini 3 de Google. Ce n’est pas un simple épisode de rivalité entre géants technologiques. C’est un indicateur très concret d’un fait souvent mal compris : l’IA qui compte n’est pas seulement la plus “intelligente” en laboratoire, c’est celle qui est fiable, rapide et bien intégrée aux usages.

Pour l’Algérie, et particulièrement pour la modernisation de l’administration (et, par extension, de l’éducation et de la formation professionnelle), cette course mondiale ressemble à un miroir. La vraie question n’est pas “quel modèle gagne ?”, mais : comment créer des services publics plus simples, plus cohérents, plus accessibles, en s’appuyant sur des briques IA qui progressent à un rythme extrêmement rapide.

Une phrase à garder en tête : une IA moyenne, bien déployée, peut améliorer un service public plus vite qu’une IA brillante, mal intégrée.

Pourquoi la guerre OpenAI–Google concerne l’Algérie

Réponse directe : parce que la concurrence accélère l’amélioration des modèles (fiabilité, personnalisation, coûts), et ces progrès deviennent rapidement disponibles sous forme d’outils utilisables par des administrations, des universités et des centres de formation.

Dans l’article source, Google aurait franchi un cap de distribution : son mode conversationnel intégré à la recherche (AI Mode) exposerait déjà des milliards d’usagers à une IA générative. OpenAI, de son côté, mise sur ChatGPT et une feuille de route recentrée (pause de projets secondaires, focus sur la vitesse et la réduction des refus).

Pour une administration publique, ce match met en évidence trois réalités utiles :

- La “qualité perçue” prime : les citoyens jugent un service sur la clarté, le délai, la cohérence des réponses, pas sur des benchmarks.

- L’intégration est le nerf de la guerre : si l’IA n’est pas au bon endroit (portail, guichet, numéro, application), elle reste un gadget.

- Le coût total est central : calcul, infrastructure, sécurité, maintenance, formation… L’IA n’est pas “gratuite” parce qu’elle est logicielle.

Cette lecture est précieuse pour un pays qui cherche à moderniser ses processus, réduire la paperasse, et rendre l’accès aux droits plus fluide.

Le vrai enjeu : fiabilité et “refus”… comme dans un guichet

Réponse directe : une IA utile au secteur public doit être prévisible, traçable et utile même quand elle ne sait pas.

OpenAI veut réduire les “refus intempestifs” et améliorer la fiabilité. Dans un contexte administratif, c’est exactement le point douloureux : un usager ne tolère pas qu’un service réponde parfois “oui”, parfois “non”, ou renvoie vers des étapes contradictoires.

Ce que “fiabilité” signifie pour l’administration

Dans un service public, la fiabilité n’est pas un mot marketing. Elle se traduit par :

- Des réponses cohérentes avec les textes applicables (circulaires, décrets, procédures internes).

- Une gestion explicite de l’incertitude : “Je ne trouve pas l’information dans les documents officiels fournis” plutôt que d’inventer.

- Des parcours guidés : checklists, prérequis, documents à préparer, erreurs fréquentes.

- Un historique et des preuves : journalisation, versions, justification des réponses sur la base de documents de référence.

Et si l’IA se trompe ? On conçoit des garde-fous

J’ai constaté que la plupart des projets échouent parce qu’on attend de l’IA qu’elle “comprenne tout”. La bonne approche consiste à délimiter et sécuriser.

Exemples de garde-fous concrets :

- Base documentaire officielle unique (procédures, FAQ validées), utilisée par l’IA.

- Réponses structurées (étapes, délais, coûts, pièces) plutôt que prose libre.

- Routage vers un agent humain dès qu’il y a : litige, situation atypique, contradiction.

- Tests réguliers sur des cas réels (les 50 questions les plus posées au guichet).

Ce sont exactement les types d’améliorations que la concurrence OpenAI–Google pousse : moins d’hallucinations, plus de stabilité, plus de vitesse.

Leçons de l’“AI Mode” de Google : l’IA doit être là où l’usager est

Réponse directe : l’intégration dans un point d’entrée massif (la recherche pour Google) multiplie l’adoption. Pour l’État, le point d’entrée, c’est le portail et le parcours usager.

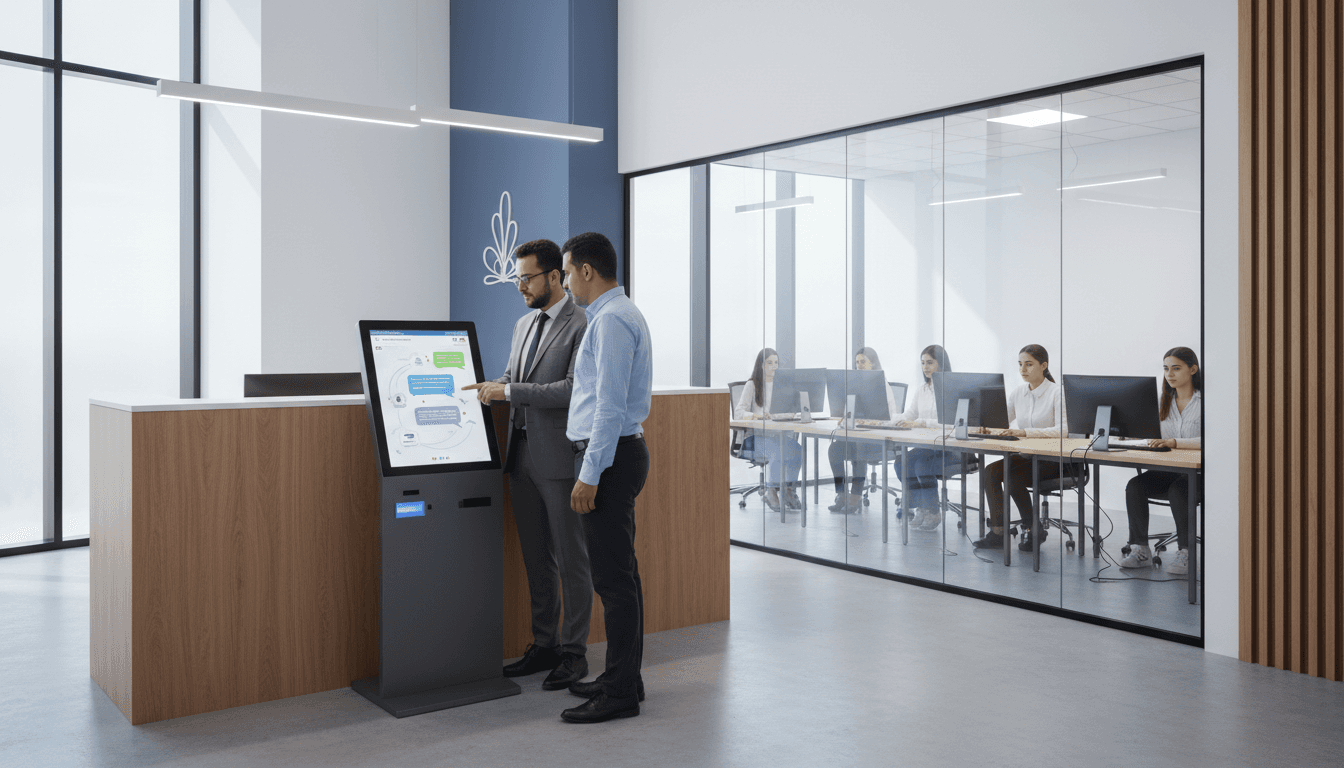

Google place Gemini dans un environnement déjà utilisé quotidiennement. Résultat : l’IA devient un réflexe. L’administration algérienne peut s’inspirer de cette logique : mettre l’assistance IA au cœur des démarches les plus fréquentes, pas dans un coin “innovation”.

Où intégrer l’IA, concrètement, dans l’administration algérienne ?

Priorité aux parcours à forte volumétrie et à forte friction :

- État civil et documents (extraits, légalisation, rendez-vous, suivi de dossier).

- Prestations et droits (éligibilité, pièces, étapes, délais prévisionnels).

- Orientation et information (où déposer, quelle direction, quels formulaires).

- Réclamations (catégorisation, tri, réponses types, escalade).

Un bon assistant IA administratif n’a pas besoin d’être “généraliste” au départ. Il peut être extrêmement performant sur un périmètre limité, puis s’étendre.

Pont vers notre série “éducation et formation”

Même logique dans l’éducation : l’IA utile est celle qui s’insère dans les outils du quotidien.

- Dans un ENT ou une plateforme e-learning : aide à comprendre une consigne, synthèse de cours, quiz adaptatifs.

- Dans un centre de formation professionnelle : tuteur de pratique (maintenance, comptabilité, bureautique), corrections, plan de révision.

- Dans l’orientation : cartographie compétences ↔ métiers ↔ formations.

Autrement dit : l’intégration est une décision produit et organisationnelle, pas seulement technique.

Le “code red” d’OpenAI : une méthode de pilotage utile au secteur public

Réponse directe : le recentrage d’OpenAI (pause de projets, focus sur l’essentiel) est une leçon de gouvernance : l’IA exige des priorités claires, sinon on disperse le budget et l’énergie.

OpenAI aurait gelé certaines initiatives (pub, agents spécialisés, assistant personnel type “Pulse”) pour concentrer ses ressources sur ChatGPT : personnalisation, rapidité, stabilité.

Dans l’administration, on voit souvent l’inverse : plusieurs pilotes IA parallèles, chacun avec ses outils, ses données, ses prestataires, et peu de mutualisation. Résultat : coûts qui montent et valeur qui se dilue.

Une feuille de route IA “administration” en 90 jours

Voici ce qui marche, même avec des moyens limités :

- Choisir 1 cas d’usage prioritaire (ex. : assistant de démarches pour un service à fort trafic).

- Définir la “source de vérité” (documents officiels, procédures validées, versioning).

- Mesurer 5 indicateurs dès le départ :

- taux de résolution sans agent humain

- temps moyen de traitement

- taux d’erreur détectée

- satisfaction usager

- coût par interaction

- Former un binôme métier + data/IT (pas un projet 100% technique).

- Déployer progressivement (un wilaya, une direction, un type de demande), puis élargir.

Cette discipline ressemble à un “code red” adapté : moins de dispersion, plus d’impact mesurable.

“Garlic”, modèles de raisonnement et formation : ce qui change en 2026

Réponse directe : la prochaine bataille se joue sur le raisonnement (enchaîner des étapes logiques, vérifier, comparer) — exactement ce qu’on attend d’un assistant administratif et d’un tuteur pédagogique.

L’article évoque un futur modèle interne chez OpenAI, au nom de code “Garlic”, et l’arrivée de modèles spécialisés dans le raisonnement. Pourquoi c’est important pour l’Algérie ? Parce que les besoins publics et éducatifs sont souvent des besoins “multi-étapes” :

- vérifier l’éligibilité

- demander des pièces

- détecter une pièce manquante

- orienter vers le bon guichet

- expliquer un refus et proposer une alternative

Exemples d’usages en éducation et formation professionnelle

- Coach de raisonnement en mathématiques/physique : expliquer une méthode, repérer une erreur, proposer un exercice similaire.

- Assistant de rédaction : structurer un rapport de stage, corriger sans humilier, proposer une grille d’évaluation.

- Simulateur de situations professionnelles : dialogue client, procédures sécurité, diagnostic de panne (avec scénarios).

Le gain n’est pas “faire joli”. C’est réduire l’écart entre le cours et la pratique, et mieux préparer l’insertion.

La réalité économique : l’IA coûte cher, donc il faut l’industrialiser intelligemment

Réponse directe : si même OpenAI vise des revenus immenses pour absorber les coûts d’infrastructure, une administration doit, elle, piloter l’IA comme un investissement public : mutualisation, sobriété, et cas d’usage à ROI clair.

Le chiffre évoqué dans l’article (objectif de revenus très élevé à horizon 2030) rappelle une vérité : entraîner et servir des modèles coûte cher. Pour l’État, cela implique de choisir une stratégie réaliste :

- Mutualiser les briques (authentification, base documentaire, logs, sécurité).

- Limiter les usages “texte libre” quand une réponse structurée suffit.

- Optimiser le coût (modèles plus petits pour des tâches simples, modèles plus puissants seulement quand nécessaire).

- Mettre des politiques de données : anonymisation, minimisation, durée de conservation.

C’est aussi une opportunité pour développer des compétences locales : data engineering, MLOps, cybersécurité, gouvernance de la donnée. Et là, notre série “éducation & formation” devient centrale : former les agents, mais aussi former les formateurs.

Questions fréquentes (et réponses nettes)

L’IA générative peut-elle remplacer les agents administratifs ?

Non. Elle absorbe la répétition (explications, tri, pré-contrôle de pièces) et libère du temps pour les cas complexes, humains, sensibles.

Est-ce risqué juridiquement ?

Oui, si on improvise. Le risque baisse fortement quand l’IA s’appuie sur une base officielle, cite ses sources internes, et escalade vers un humain en cas d’incertitude.

Faut-il attendre “le modèle parfait” ?

Non. L’avantage va à ceux qui apprennent vite, mettent des garde-fous, mesurent et améliorent. La concurrence OpenAI–Google montre que le rythme ne ralentira pas.

Ce que l’Algérie peut décider dès maintenant

La pression concurrentielle qui pousse OpenAI au “code red” et Google à intégrer Gemini partout envoie un message clair : l’IA devient une couche d’interface standard entre des systèmes complexes et les utilisateurs. L’administration algérienne a tout intérêt à traiter ce sujet comme un chantier de modernisation au même niveau que la simplification des procédures.

Pour notre série sur l’éducation et la formation professionnelle, le parallèle est direct : si l’État veut des compétences adaptées au marché, il doit aussi industrialiser des outils d’apprentissage (tuteurs IA, contenus adaptatifs, assistants de rédaction, simulateurs métiers) et former les enseignants/encadrants à les piloter.

Prochaine étape concrète : sélectionner une démarche prioritaire et construire un prototype en 90 jours, avec une base documentaire officielle, des métriques publiques, et un plan de montée en charge.

La question qui reste, et elle est politique autant que technique : quelle démarche administrative, en Algérie, mérite d’être la première à devenir “IA-native” en 2026 ?