Waymo在奥斯汀反复经过校车引发监管追问,核心不只是识别,而是行为与合规。本文拆解软件更新如何构建安全闭环,并对比Waymo、Tesla与中国车企的迭代路径。

Waymo校车事件:自动驾驶AI更新如何补上安全与体验缺口

自动驾驶公司最容易被误解的一点是:出问题时,大家以为是“传感器不够贵”或“算力不够大”。但在 2025-12-31 这个节点回头看,真正决定安全上限的,往往是软件更新机制——尤其是当车辆在真实道路里遇到“低频但高风险”的场景。

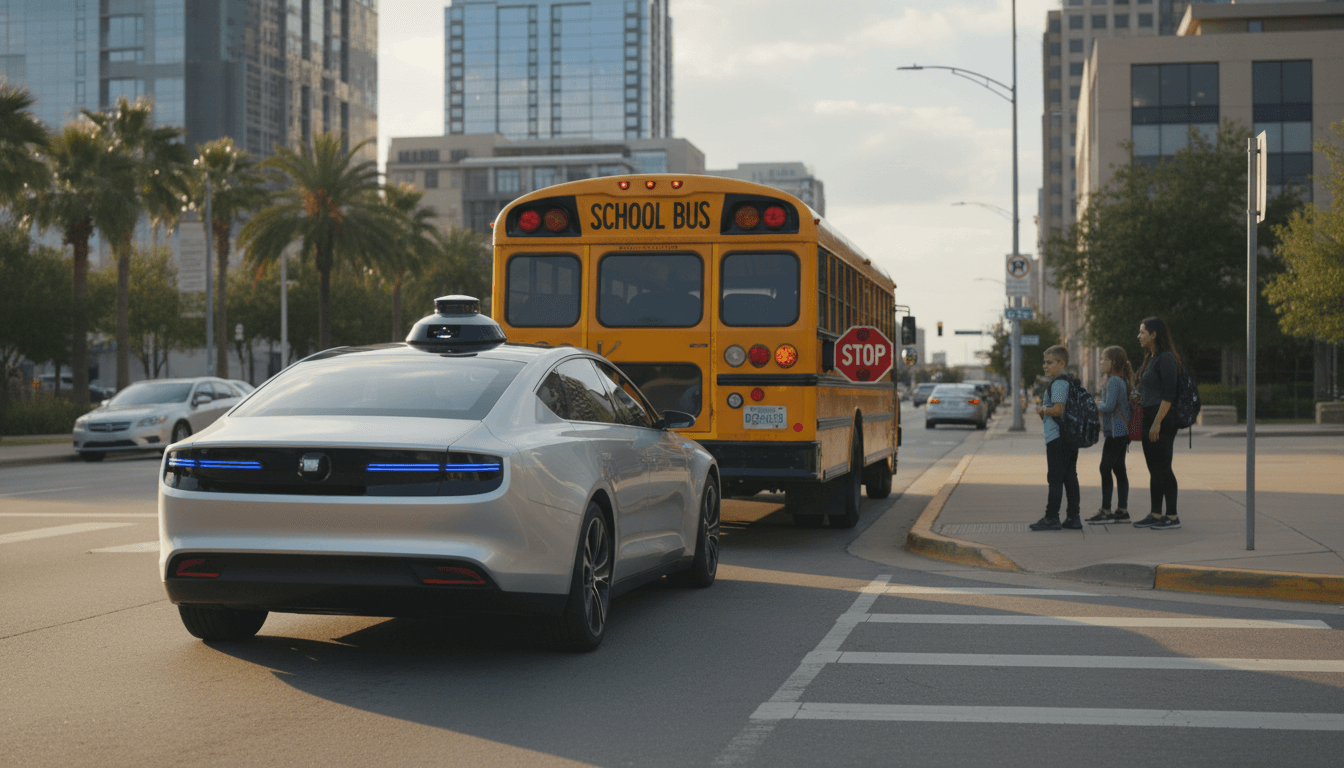

最近的一则消息很典型:美国监管机构持续向 Waymo 询问其机器人出租车在奥斯汀反复经过(甚至可能未按预期处理)校车的情况。监管部门在 10 月已就 Waymo 在校车场景下的表现立案调查;Waymo 表示已向车队推送软件更新以改进。

这件事之所以值得写一篇长文,不是因为它“猎奇”,而是因为它把自动驾驶的核心矛盾摆到了台面上:**系统需要像人一样理解“校车=高优先级保护对象”,又必须用工程化的方法把这种理解固化成可验证、可持续迭代的软件能力。**这也正好契合我们系列主题《自动驾驶 AI:Tesla 与中国车企的发展路径对比》:同样是 AI,为什么不同公司在安全、扩展性和用户体验上的取舍差异巨大?

监管追问Waymo校车:问题不在“识别”,而在“行为”

先把结论放在前面:多数校车相关事故风险,关键不是“看没看到校车”,而是“看到了之后怎么做”。

校车场景很特殊:

- 它不是普通停车/慢行车辆,而是带有强制规则的“移动安全区”。

- 规则会随州法律变化(例如是否必须双向停车、距离阈值、道路分隔的判断)。

- 最危险的对象不是校车本身,而是突然横穿的儿童与家长。

所以,自动驾驶系统需要完成一个链条:

- 检测与分类:校车车身、灯光、伸出的“STOP”标志、闪烁灯状态。

- 语义理解:这是“正在上下客的校车”还是“普通行驶中的校车”。

- 法规映射:结合所在地交通法规、道路形态(是否中央隔离、车道数)。

- 行为规划:提前降速、停车位置、保持距离、对周边行人做更保守预测。

- 可解释与可验证:能对监管部门说明“为什么当时这样做”。

Waymo被持续追问,意味着监管机构关心的不只是“有没有更新”,而是更新是否系统性地降低了风险:能否在相似场景稳定复现正确行为、能否被第三方验证、能否覆盖奥斯汀的道路与校车运行习惯。

“软件更新”不是补丁:它是自动驾驶安全闭环的发动机

我一直认为,自动驾驶行业的分水岭不是“有没有 L4 运营”,而是有没有把更新做成闭环能力。闭环能力包含三件事:采集、学习、发布。

1)从车队回传到“可学习的数据”

校车问题往往是长尾场景:发生频率低,但一旦处理失当,社会容忍度为零。要解决它,车队数据必须具备可用性:

- 事件触发:遇到校车灯光/停靠动作/STOP牌时自动标记。

- 场景切片:前后 30-60 秒多模态数据(摄像头、雷达/激光雷达、定位、车辆控制量)。

- 风险评分:以“距离-速度-可见性-儿童潜在出现区域”综合打分,优先进入训练与仿真。

做不到这些,更新只能靠“工程师猜测”。而工程师一猜,长尾就会反复出现。

2)从“会开”升级为“会守规矩”

校车场景对 AI 的要求很现实:合规优先级高于通行效率。

这会直接影响规划策略:

- 更早的减速触发阈值(例如看到闪烁灯就进入保守模式,而不是等 STOP 牌完全伸出)。

- 更大的不确定性边界(把可能冲出的儿童当作“高概率出现”的动态障碍物)。

- 更严格的停止条件(宁可多停 1-2 秒,也不要“擦边通过”)。

对用户体验来说,这种“更保守”可能意味着更慢、更频繁停车。但在校车面前,体验的核心不是快,而是让乘客与路人都觉得你值得信任。

3)从更新到验证:能否给监管一个“可测的答案”

监管部门不吃“我们改好了”的口头承诺,他们需要可验证的证据。一个成熟的更新流程,至少要回答:

- 更新覆盖了哪些触发条件(灯光、STOP牌、停靠状态、道路形态)?

- 离线回放(log replay)通过率是多少?

- 仿真测试覆盖了多少组合(白天/夜间、雨雾、遮挡、双向/单向、中央隔离)?

- 影子模式(shadow mode)上线观察了多久?有没有指标门槛?

一句话:软件更新不是“补丁”,而是安全工程的一部分。

Waymo vs Tesla:同样是AI,两种安全迭代的逻辑

把话题放回我们的系列主线:Tesla、Waymo 以及很多中国车企,其实代表了三种典型路径。

Waymo:高冗余传感器 + 运营域约束 + 稳健迭代

Waymo更像“把自动驾驶当成公共交通系统”来做:

- 依赖高质量传感器冗余(通常包含激光雷达等)提升感知确定性。

- 在限定ODD(运营设计域)内运营,例如特定城市、特定区域。

- 更新节奏更谨慎,但每次更新强调“可验证”。

校车事件对 Waymo 的影响尤其大,因为它的商业模式建立在“监管许可 + 城市信任”上。任何校园相关风险,都会放大成政策压力。

Tesla:端到端倾向更强,规模化数据驱动迭代

Tesla的优势在于:

- 车队规模大,数据量巨大,长尾覆盖更快。

- 端到端或更强学习型策略,使系统在复杂场景可能更“像人”。

但挑战也很明显:

- 合规与可解释性更难:模型为什么这么做?如何证明它在各州校车法规下都可靠?

- 一旦策略偏差被放大,影响面可能更广。

对“校车”这种强规则对象,我的观点很明确:端到端可以参与,但必须有规则层的护栏,否则就会陷入“偶尔表现像老司机、偶尔像新手”的不稳定体验。

中国车企:多传感器、多供应商协同,优势在“工程落地”

不少中国车企在智能驾驶上更偏系统集成:

- 多传感器融合(摄像头 + 毫米波雷达 + 激光雷达/高精地图等因车型而异)。

- 供应商与自研并存,功能快速上车。

- 对本土道路与法规适配速度快(例如校门口临停、非标道路标线、混行电动车)。

但风险也存在:

- 多供应商带来的版本协同复杂,更新链条长。

- “功能可用”到“可证明安全”之间,仍需要更标准化的安全闭环与测试体系。

校车事件给中国市场一个提醒:不要只盯着高速NOA和城市领航的炫技,儿童与校园场景的策略优先级应该更靠前。

把“校车场景”做成产品能力:安全与用户体验可以一起提升

结论先说:最好的安全策略,往往也能提升用户体验——前提是你把体验定义为“可预期、可解释、让人安心”。

下面是我建议车企/自动驾驶团队把校车相关能力产品化的做法。

1)把“校车”设为独立安全功能,不要当普通障碍物

校车不该只是感知结果里的一个 class_id。它应该触发一套独立策略包:

- 校车灯光/STOP牌状态机

- 地理位置与时段特征(上学/放学高发)

- 与行人预测强耦合的风险模型

一句话总结:“识别到校车”只是开始,“进入校车安全模式”才是关键。

2)给用户一个“可理解的反馈”,减少恐慌与投诉

用户体验在这里很现实:车突然慢下来、停在路口,乘客会不耐烦,后车会鸣笛。

HMI 可以做两件小事,效果很大:

- 仪表/中控提示“校车上下客,车辆正在按法规停车等待”

- 用简短语音解释一次(不需要每次都说,避免打扰)

当用户知道原因,保守策略就不再像“系统犯傻”,而像“系统靠谱”。

3)测试要“按法规维度”组织,而不是按道路类型

校车场景测试建议按法规变量拆解:

- 是否中央隔离(影响对向是否需要停车)

- 校车是否开闪灯、STOP牌是否伸出

- 车距与速度组合(刹停距离、跟车策略)

- 遮挡条件(大车遮挡、路边停靠遮挡)

- 儿童突然出现的行人模型(最关键)

这套拆解能直接映射到仿真覆盖率与回归测试指标,让“我们更新了”变成“我们通过了多少条规则”。

常见追问:软件更新就能解决所有安全问题吗?

不能。软件更新能提高系统对已知问题的处理能力,但前提是你能捕捉问题、复现问题、验证修复。

校车这类风险还牵涉到:

- 传感器在逆光/雨雾下的可靠性(看得清是底线)

- 地方交通法规的及时维护(规则错了,行为再聪明也会错)

- 运营侧策略(例如在上学放学时段,对学校周边设定更保守速度上限)

真正成熟的做法是“软件更新 + 运营策略 + 合规体系”三者一起推进。

下一步:把安全更新做成可衡量的能力

Waymo 在奥斯汀的校车事件,本质上是一堂公开课:**自动驾驶的安全不是一次性验收,而是持续迭代的产品能力。**谁能把“发现问题—训练/规则修正—仿真与回放—灰度上线—指标闭环”跑顺,谁就更接近规模化落地。

如果你正在评估自动驾驶方案(无论是端到端路线、还是多传感器融合路线),我建议你少问一句“你能不能开”,多问三句:

- 你们对校车、施工、紧急车辆这类强规则对象,有没有独立策略与指标?

- 一次软件更新从发现问题到发布,需要多久?中间的验证门槛是什么?

- 更新后如何向监管与用户解释“为什么这样开更安全”?

自动驾驶 AI 的竞争,最后拼的不是某次演示有多顺,而是每一次软件更新能不能把系统变得更可靠、更可预测。下一次当监管再追问时,你希望交出的,是一段公关话术,还是一套可被复测的安全证据?