Waymo校车事件提醒行业:自动驾驶安全靠持续软件迭代与可验证闭环。本文拆解校车场景难点,并对比Tesla与中国车企路径。

自动驾驶为何总在校车前“出错”?从Waymo事件看AI软件迭代

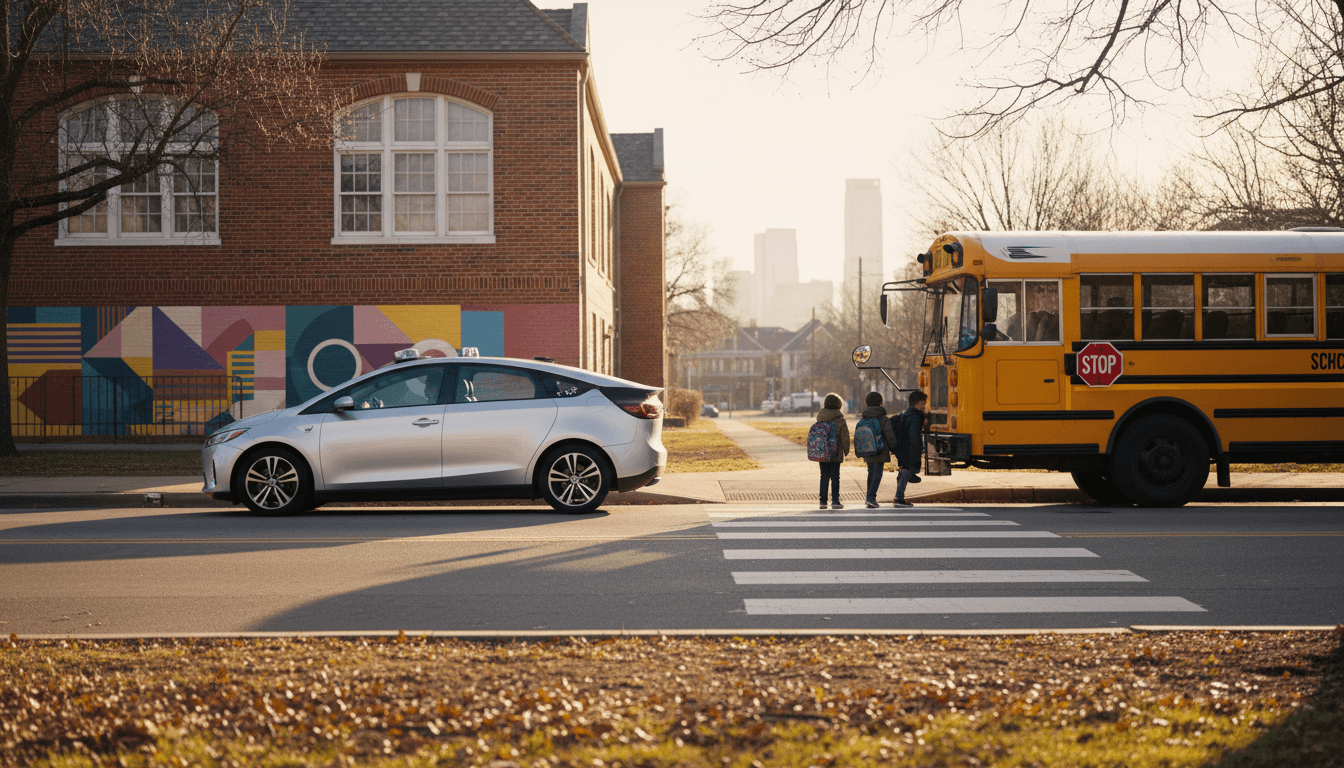

在自动驾驶的所有“路测难题”里,校车可能是最不允许出错的一类:它不仅有明确的交通规则约束(停车、警示灯、伸出的停车指示牌),还牵扯到最敏感的公共安全对象——儿童。也正因为如此,任何“看起来只是一次误判”的行为,一旦发生在校车场景里,社会容忍度几乎为零。

最近美国监管机构再次向 Waymo 询问:其在奥斯汀运营的机器人出租车,是否存在反复从停止的校车旁驶过的情况。更早在 2025 年 10 月,相关机构已经就 Waymo 在校车周边的表现开启调查。Waymo 的回应很典型:已经向车队推送软件更新,以改进对校车场景的处理。

这条新闻本身信息量不大,但它把一个现实问题摆在台面上:**自动驾驶安全并不是“发布一次模型就结束”,而是一场持续的软件战役。**而在我们的系列主题“自动驾驶 AI:Tesla 与中国车企的发展路径对比”里,这恰好是两条路线差异最容易被忽视、却最影响商业化的地方:谁能把“持续迭代”做得更稳、更可验证、更让用户安心,谁就更接近规模落地。

监管机构为什么紧盯“校车通过”这种细节?

**答案很直接:校车场景属于高后果(high-consequence)规则场景,一旦出错,代价远高于普通变道或跟车误差。**监管机构会盯住它,不是因为它最常见,而是因为它最能检验自动驾驶系统的“底线能力”。

从工程角度看,校车事件至少同时触发三类能力考核:

- 规则识别与遵从:系统不仅要识别“这是一辆校车”,还要识别“校车正在执行停车上下客流程”。

- 长尾状态机处理:校车的灯光、指示牌、停靠姿态、路边环境、对向车道规则,组合起来就是典型长尾。

- 保守策略与可解释性:系统的行为需要对外可解释,尤其在事故调查或投诉场景中,不能只说“模型这么预测的”。

很多公司在常规道路表现很好,但在校车、施工改道、临时交警指挥等场景容易“翻车”。原因不是“AI不聪明”,而是现实交通的规则与语义,常常是“写在法规里、藏在细节里、变在现场里”。

一句更直白的话:校车场景考的是“你到底把交通当作数学题,还是当作社会契约”。

Waymo的“软件更新”意味着什么:自动驾驶的安全是可运营出来的

**软件更新不是公关动作,而是自动驾驶商业化的核心运营能力。**在机器人出租车(Robotaxi)模式下,车辆每天都在跑真实订单,系统会不断遇到新组合:不同州的校车外观、不同的灯光状态、不同的道路标线、不同的司机行为。

1)从“单次发布”转向“持续闭环”

一个成熟的自动驾驶团队,面对“校车重复通过”的投诉,通常会走一条闭环链路:

- 事件采集:定位具体时间、地点、传感器片段、车端决策日志。

- 场景归因:是感知没识别?识别了但规则引擎没触发?还是触发了但规划仍选择通过?

- 回放与复现:在仿真系统中复现相同光照、遮挡、道路结构。

- 改动策略:可能是模型训练数据补齐、阈值调整、规则优先级提升,甚至引入更保守的“校车安全带”。

- 灰度发布:先小范围推送,观察误报/漏报变化。

- 验证与审计:形成可交付给监管的证据链(这一步越来越重要)。

这也是为什么我一直认为:**自动驾驶不是“买一套算法”,而是“运营一套软件系统”。**没有闭环能力,就没有规模化的安全。

2)更新内容可能是什么?别只盯“识别准确率”

外界容易把问题简化为“识别校车不准”。但在真实系统里,更常见的难点在“识别之后怎么做”。

可能的改动方向包括:

- 更强的状态识别:识别校车“正在停车上下客”的状态,而不仅是“校车类别”。

- 策略更保守:即使存在不确定,也选择减速、停车、等待更长确认时间。

- 规则优先级上调:在规划层把校车规则置于更高优先级,覆盖部分通行效率目标。

- 地理围栏与提示:在学校周边高频区域,通过地图/运营规则强化“慢行与超保守”。

对用户体验(UX)来说,这些变化会带来一个副作用:**车可能更慢、更谨慎、更像“新手司机”。**但在校车场景里,慢不是缺点,是信任成本的一部分。

AI在汽车软件与用户体验中的真实分水岭:安全感不是界面做出来的

答案先说在前:在自动驾驶里,最关键的用户体验不是屏幕交互,而是“我敢不敢把命交给它”。

校车事件之所以值得写进“用户体验”讨论,是因为它体现了一个被很多产品团队低估的事实:

- 当系统在高风险场景做出“违反常识”的动作,用户会瞬间把它归类为“不可靠”。

- 这种不信任一旦形成,靠更好看的 UI、更多的娱乐功能几乎补不回来。

我见过不少车企把“智能座舱”当成体验主战场,把“智能驾驶”当成宣传主战场。但真实体验里,顺序往往相反:驾驶安全感是地基,座舱体验是装修。地基一晃,装修再豪华也没用。

因此,围绕校车这类场景,真正有效的 UX 动作反而偏“朴素”:

- 车端在采取保守动作时,给出简洁明确的原因提示(例如“检测到校车上下客,正在等待”)。

- 对可能误触发的情况,提供更可控的“请求接管”提示,而不是突然急刹或突然走神。

- 在运营端建立可追溯的反馈通道:用户一键上报,后台可回传“已修复/已更新”的闭环信息。

放到系列主线里看:Tesla路线与中国车企路线,谁更擅长“可验证的迭代”?

一句话概括:Tesla更像“统一模型快速进化”,中国车企更像“多方案拼装后强调工程冗余”;校车这种规则场景,最终拼的是“迭代可验证”。

1)端到端模型的挑战:规则场景的“可解释性债务”

Tesla式端到端(或趋近端到端)的优势在于:

- 数据规模大、迭代快

- 行为更“像人”,对复杂交通流可能更顺

但校车场景常常要求:**你必须证明“为什么停、停多久、在什么条件下才能走”。**这会让端到端系统背上“可解释性债务”。债务不一定致命,但当监管问到细节时,你得能把证据链拿出来。

2)多传感器、多供应商路线:工程更稳,但一致性更难

很多中国车企(以及供应链协同模式)更强调:

- 传感器冗余(激光雷达、毫米波、摄像头)

- 模块化栈(感知/定位/规划各自供应商或多团队)

它的好处是:对校车这种“明确规则+明确风险”的场景,更容易通过规则引擎把底线钉死。但难点在于:

- 供应商协作导致迭代节奏不一致

- 不同城市规则差异、地图策略差异,容易带来“同一辆车不同地方表现不同”

3)真正的胜负手:安全迭代的三张“交付物”

我更看重车企能不能稳定交付这三样东西:

- 场景库:把校车、校区、上下客、对向车道规则等拆成可复用的场景单元。

- 验证报告:每次更新能量化说明“漏检率/误停率/平均等待时长”如何变化。

- 发布策略:灰度、回滚、地域差异策略,以及对监管与公众的沟通话术。

这三张交付物,决定了自动驾驶从“能跑”到“敢卖、敢坐、敢监管”的距离。

车企与出行平台可以立刻做的5件事:把校车场景当作“安全产品”来做

**结论先给:校车不是一个功能点,它是一套可运营的安全产品。**如果你负责自动驾驶/ADAS 量产或 Robotaxi 运营,这五件事能显著降低风险:

- 建立“校车优先级”策略模板:宁愿误停,也别误行;并设定可量化的等待上限与退出条件。

- 用数据定义“合规”而非“像人”:比如在校车灯亮起后的 0.5 秒内进入减速决策、2 秒内完成停车动作(示例指标,用于说明思路)。

- 把规则差异写进系统配置:不同地区对校车停车规则不同,别指望模型自动学会全部细则。

- 把用户解释做成最小闭环:车为什么停、预计等多久、是否需要接管,用一句话讲清楚。

- 把更新当作“安全公告”:更新内容、验证范围、已知限制,内部要能审计,外部要能沟通。

我对“自动驾驶体验”的评价标准很简单:它愿不愿意在关键时刻,主动选择让自己更慢。

下一步:自动驾驶的竞争,会越来越像“安全运营能力”的竞争

Waymo被反复追问校车事件,表面看是一次监管对企业的施压;往深里看,它在提醒整个行业:**自动驾驶的迭代速度必须服从安全证据的生成速度。**没有证据链的快,只会变成风险。

放回到“Tesla 与中国车企的发展路径对比”这条主线,我的判断是:未来两三年,市场不只看你有没有更强的模型、更多的传感器、或更大的算力,而是看你能否持续输出“可验证的安全改进”,并把它转化为用户可感知的安心。

如果你正在评估自动驾驶方案、规划量产节奏或运营 Robotaxi,不妨自问一句:当监管问到“你们如何保证校车场景永远不出错(或持续变好)”时,你能拿出哪三份材料?