Waymo 因校车场景发起软件召回,提醒自动驾驶要把“安全+体验”一起做进迭代闭环。拆解校车难点,并对比 Tesla 与中国车企路线。

自动驾驶软件召回启示:校车场景如何倒逼AI与体验升级

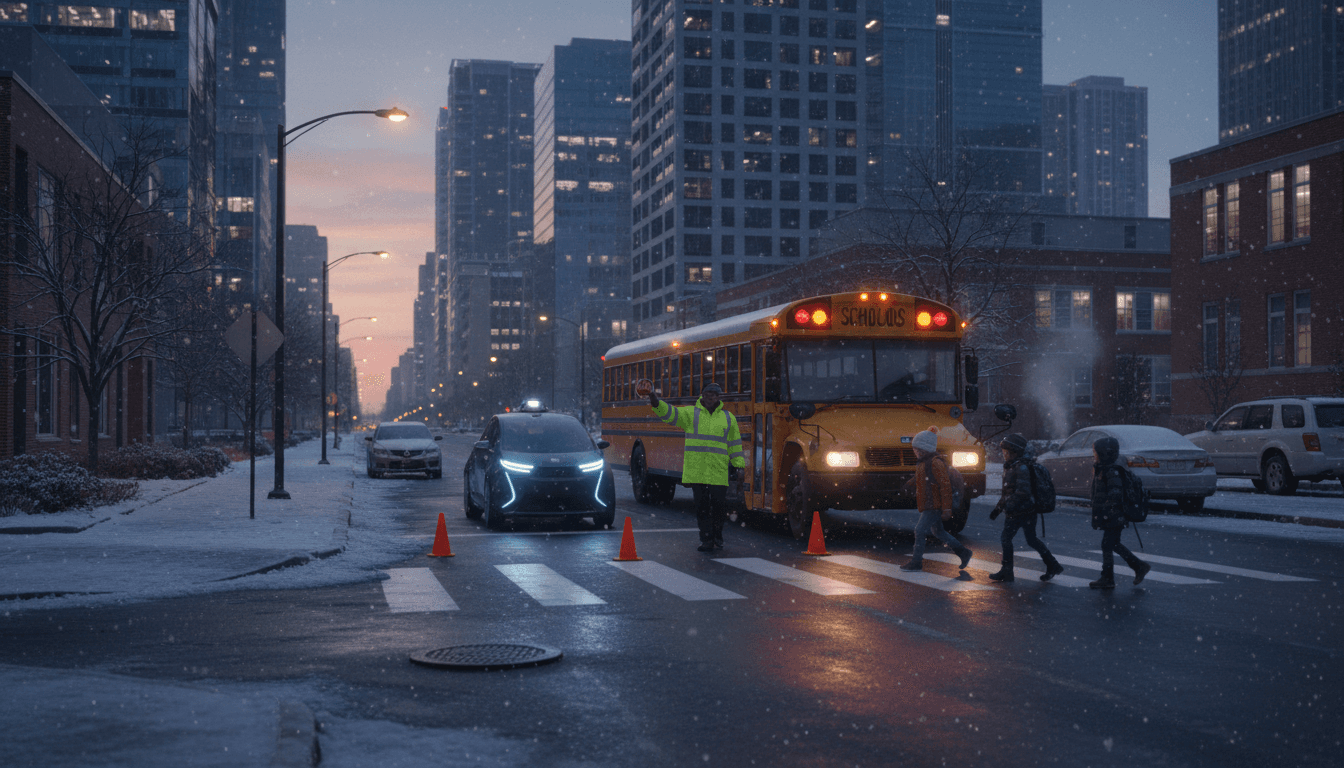

2025 年临近元旦,北美不少城市正处在学期末与假期交错的出行高峰:接送车流更密、临停更频繁、儿童过街更不可预测。偏偏这种“看起来只是慢一点”的路况,对自动驾驶系统却是最容易出事的地方。

近期,Waymo 因“机器人出租车在校车周边的行为表现”发起自愿软件召回,并且这件事发生在联邦监管机构与地方学区的关注持续升温之际。很多人听到“召回”两个字会本能联想到硬件缺陷,但这次更像是一个行业提醒:自动驾驶的安全边界,越来越取决于软件对极端细节的处理,尤其在学校区域、校车停靠、儿童穿行等高敏感场景。

我把它当作我们系列《自动驾驶 AI:Tesla 与中国车企的发展路径对比》里一个很典型的案例:同样是“AI 驾驶”,端到端模型与多传感器多供应商方案,最终都要在同一类场景里接受检验——而且检验标准不只是“不撞”,还有让人类觉得可靠、可预期、好相处。

Waymo 校车场景软件召回:问题不在“看见”,在“怎么做”

先说结论:围绕校车的自动驾驶难点,往往不是识别不到校车,而是识别到了之后的策略与动作是否符合当地法规、学校工作人员预期,以及家长对安全缓冲的心理阈值。

从公开信息的“摘要级线索”看,Waymo 的召回与其机器人出租车在校车周边的行为表现有关;而监管层与学区的审视加码,意味着这类问题已经从“公司内部改进”上升到“公共安全与制度协同”。这背后至少有三层含义:

1)校车不是普通车辆:它是一套“移动交通规则”

在很多地区,校车本身带有强约束信号:

- 特定灯光/停靠标识触发“必须停车/禁止超车”等义务

- 不同道路类型(单向/双向、是否有中央隔离)规则不同

- 学区还可能有临时指挥(校车司机手势、护学岗人员哨音、临时路锥)

对 AI 来说,这不是“识别一个黄色大车”就结束了,而是一整套条件触发的有限状态机 + 风险冗余策略。

2)“合法”不等于“让人安心”:用户体验直接影响公众接受度

自动驾驶在学校区域常见的负面体验包括:

- 过于谨慎导致后车频繁鸣笛、形成二次风险

- 过于自信导致贴近校车或儿童活动区域,吓到行人

- 反复犹豫(停—走—停)让其他交通参与者无法预测

这一类问题,即使没有发生事故,也会迅速被放大。因为学校区域的“容错率”接近于零,家长、学区与媒体不会用普通道路的标准来衡量。

3)召回是“软件治理”问题:你需要可解释、可验证、可回滚

软件召回本质上是:既然车辆行为是由软件定义的,那么安全治理也必须软件化。

真正难的是建立一套闭环:发现问题 → 复现 → 定义行为边界 → 更新策略/模型 → 仿真与实车验证 → 灰度发布 → 监控回归风险。能做到这套流程的公司,才有资格把车开进学校周边。

校车与学校区域:AI 最难的不是感知,而是“意图理解 + 责任分配”

先给一个直接判断:学校区域的自动驾驶,是“社会协作型驾驶”。它不是单车智能就能搞定,必须在不确定性里做保守但不僵硬的决策。

1)校车场景的“长尾”特别密集

学校区域的长尾不是偶发,而是高频:

- 儿童突然折返、跑动、从车缝钻出

- 家长车辆临停、双排、开门、倒车

- 校车停靠点不固定(临时施工、天气、活动)

- 交警/护学岗临时指挥与手势优先级

端到端模型容易在长尾上“像人但不稳定”;规则系统容易“稳定但不通融”。因此行业越来越倾向:关键场景以可验证策略兜底,非关键场景由学习系统提供效率与舒适性。

2)意图理解比目标检测更关键

“看见校车”只是起点,真正要理解的是:

- 校车是否正在上下客?是否即将停靠?

- 周围儿童/家长的运动趋势(而不是当前速度)

- 其他车辆是否会抢行、并线、越线

这需要模型不仅输出“是什么”,还要输出“可能要做什么”。在工程上通常表现为:

- 多模态融合(视觉 + 雷达/激光雷达 + 高精地图/语义地图)

- 轨迹预测(多假设、多样本)

- 风险评估(最坏情况约束)

3)责任分配决定策略:谁先动、谁让谁

在学校区域,人类司机默认会“让”:让行人、让校车、让护学岗。自动驾驶如果只按交通规则的字面最小要求执行,很容易显得“冷血”。

我更认可的一句工程原则是:

在学校区域,自动驾驶的第一目标不是通行效率,而是把不确定性压到最低。

这句话很“反商业”,但它能显著降低公关与监管成本。对 robotaxi 来说,这类成本比绕行多 30 秒贵得多。

从 Waymo 召回看“持续迭代”:它和 Tesla 的路子有什么相似与不同

一个常被误解的点是:Waymo 与 Tesla 虽然路线不同,但都在做同一件事——用软件迭代把真实世界的复杂性吃进去。

1)相似点:都必须用 OTA 把安全闭环做成日常

无论是端到端,还是多模块架构,校车场景暴露问题后,最现实的修复方式就是软件更新:

- 修改策略阈值(例如停车距离、通过条件、让行逻辑)

- 增加场景识别与状态切换(校车灯光/停靠状态)

- 调整轨迹预测的保守度(提升最坏情况约束权重)

这和我们在系列里常讨论的“软件定义汽车”一致:安全能力不是出厂一次性写死的,而是运营中被不断校正的。

2)不同点:端到端追求“泛化”,多传感器追求“可控”

- Tesla 式端到端更像把“怎么开”学出来,优势在规模化数据驱动与泛化潜力;但在监管关注的高风险场景,外界更想要“你为什么这么做”的解释。

- **Waymo 式(更偏多传感器、强约束运营)**通常在限定区域内做得更稳,优势是可控、可验证;代价是扩张速度与场景覆盖需要更多工程投入。

校车场景就是端到端的“解释性压力测试”、也是多模块系统的“规则覆盖压力测试”。两边都不好过。

对中国车企与本土生态的提醒:学校区域是“系统工程”,不是单点功能

把视角拉回国内。中国车企普遍采用多供应商协同:感知、定位、地图、域控、座舱、云平台可能来自不同伙伴。要把校车与学校区域做好,最大的坑往往不是算法,而是跨系统一致性。

1)法规与地方差异:必须做成“可配置的规则层”

国内学校周边管理差异很大:有的靠护学岗,有的靠电子警察,有的临时封路。车企如果把这些写成硬编码,很快就会在不同城市“水土不服”。

更可行的做法是把它抽象成:

- 可配置规则(时间窗、限速、禁行/让行)

- 可配置场景策略(校门口、斑马线、临停区)

- 可配置提示交互(对驾驶员/乘客/外部交通参与者)

2)用户体验要进安全指标:不只是“通过率”,还有“可预期”

我建议把学校区域的体验指标写进验证清单,至少包括:

- 行人近距离通过时的最大加速度/减速度(舒适性与惊吓度)

- 停车等待的稳定性(避免反复抖动式前探)

- 对外部车辆的“可读性”(灯语、位置、速度变化是否清晰)

这就是“AI 在汽车软件与用户体验中的不同应用方式”:同一套 AI,既要做决策,也要做交互;既要对监管负责,也要对路人情绪负责。

3)落地建议:三件事最值回票价

如果你在做智能驾驶/robotaxi 产品规划,学校区域可以按“三层防线”推进:

- 强约束行为库:校车/校门口/斑马线做成明确状态机与安全冗余

- 高频回归测试集:把“最烦人的 200 个长尾”做成常态化回归

- 运营监控与灰度:场景相关策略必须支持按城市/街区灰度与快速回滚

做不到第三条,软件召回就会变成组织噩梦。

People Also Ask:关于校车场景与软件召回,大家最常追问什么

自动驾驶为什么会因为“校车行为”被监管盯上?

因为校车与儿童安全属于社会高度敏感议题。只要出现不符合预期的行为,即使未造成事故,也会触发学区与监管对系统性风险的评估。

软件召回是不是意味着自动驾驶不安全?

不等于“不安全”,但说明系统在特定场景的行为边界需要重画。更关键的是企业是否具备可验证的修复流程与透明的安全治理能力。

校车场景更适合端到端还是多模块?

我的观点是:关键安全场景必须有可验证的策略兜底。端到端可以提升泛化与效率,但校车这类场景需要更强的规则与冗余来满足公众与监管的确定性要求。

写在最后:学校区域会成为自动驾驶“体验与治理”的分水岭

Waymo 的这次自愿软件召回,把一个行业现实摆在台面上:自动驾驶不是“能跑”就行,还要在最敏感的场景里表现得像一个值得托付的司机。而这种“值得托付”,既是安全工程,也是用户体验工程。

如果你正在评估智能驾驶方案、规划 robotaxi 运营、或为中国车企做软件平台建设,我会把学校区域当成优先级更高的试金石:它能同时检验你的感知能力、决策策略、软件迭代机制、以及面对监管与公众的沟通能力。

下一篇我想继续沿着这个线索写:当端到端模型遇到“强规则场景”(校车、施工、交警手势),企业该如何设计“可解释的 AI 驾驶”——你更关心技术路线,还是更关心落地组织能力?