SIGGRAPH Asia 2025 展示手机单目生成高保真3D数字人,并可移动端实时渲染。本文拆解其关键机制,并给出电商虚拟导购与游戏写实NPC的落地路径。

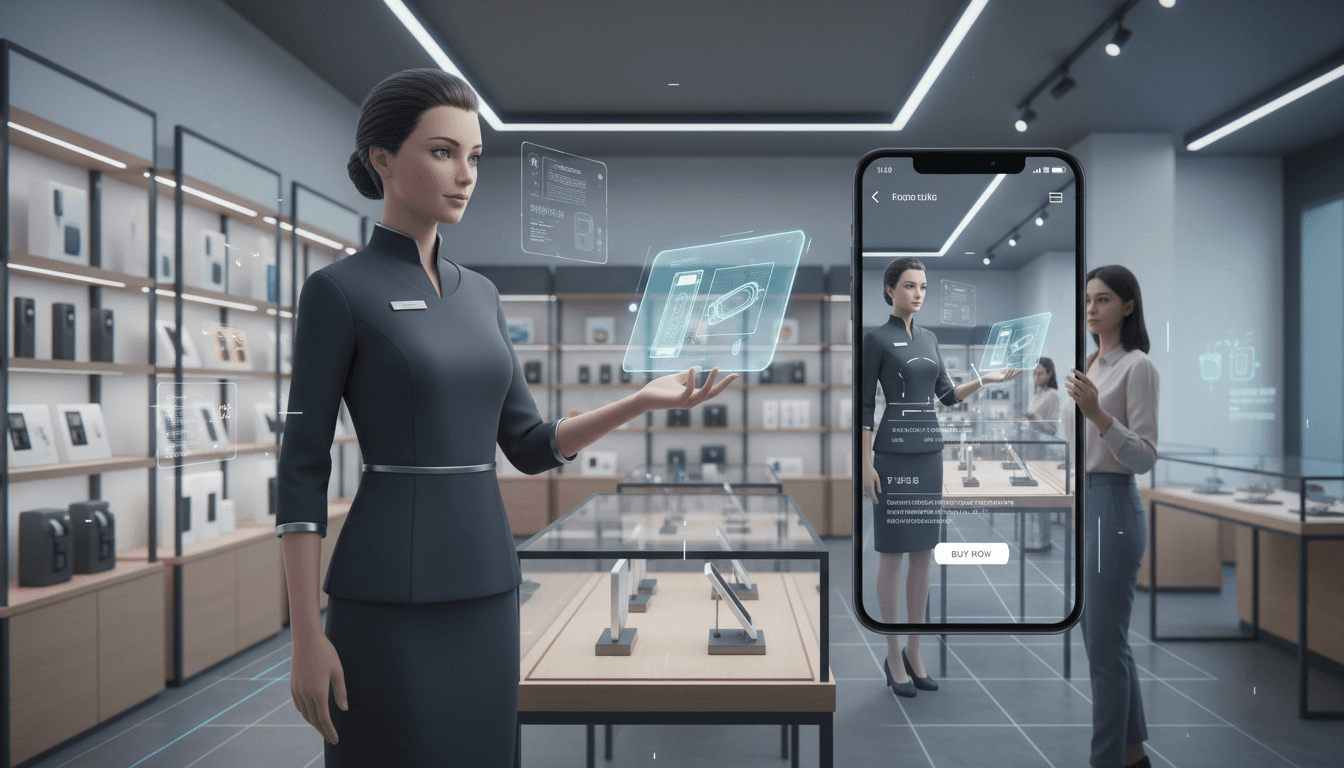

手机生成高保真3D数字人:虚拟导购与沉浸式新零售落地路径

2025-12-18 的 SIGGRAPH Asia 上,有一条信息值得电商和游戏行业一起紧张起来:只用一部普通手机拍一段单目视频,就能重建并在移动端实时渲染“能动、像真、人设稳定”的 3D 数字人。这不只是学术圈的“好看 Demo”,而是把虚拟人从摄影棚、动捕棚,推进到门店、直播间、甚至消费者口袋里的关键一步。

我见过太多团队做虚拟导购和数字店员时卡在同一堵墙上:要么效果很“假”,要么效果很“贵”,要么能跑但跑不动。SIGGRAPH Asia 2025 这篇移动端系统(HRM²Avatar)给出的答案很明确:用“显式网格 + 高斯细节”的混合表示,把稳定结构和真实细节同时抓住,再把渲染链路按移动端硬件重写一遍。

更有意思的是,这套能力对“人工智能在游戏与数字娱乐”同样直接:同一套移动端实时数字人,既能当电商虚拟导购,也能当游戏里的写实 NPC、MR 互动角色、甚至线下娱乐空间的导览员。技术边界被打薄后,商业边界也会跟着变。

3D数字人进入电商与新零售:门槛到底卡在哪

结论先说:3D 数字人要在电商里变成“可规模化的经营工具”,而不是一次性活动道具,门槛主要卡在三件事:采集成本、跨动作一致性、移动端实时性。

1)采集成本:从“棚拍”到“随手拍”

传统高质量数字人常依赖多相机阵列、深度传感器或专业灯光环境。效果当然好,但问题也很现实:

- 搭建复杂、调试周期长

- 难以复制到每个城市、每家门店

- 更难让“商家自己上手”

对于新零售来说,这直接意味着两点:规模起不来,以及内容更新跟不上运营节奏(上新、促销、节日主题换装)。

2)跨动作一致性:导购“动起来”就露馅

电商虚拟导购通常要做:指商品、转身拿货、抬手展示细节、近景讲解。很多方案在静态还行,一动就出现:

- 纹理漂移(衣服印花像贴纸滑动)

- 褶皱塌陷或拉伸

- 光照不跟随动作变化,导致“纸片感”

消费者对“人像不真实”的容忍度很低,尤其在大促季(双12刚过、年货节将至)这种流量贵、转化压力大的节点,虚拟人一旦显假,反而会降低信任与停留。

3)移动端实时性:能上线才叫能力

新零售的关键场景在移动端:App、门店屏、头显、直播推流。桌面 GPU 上 60FPS 不难,难的是:

- 手机算力和带宽受限

- 多人同屏(比如一个会场多个数字人导览)

- 2K/高帧率需求(更顺滑更像真)

HRM²Avatar 在 iPhone 15 Pro Max 上做到 2K@120FPS(约 53 万高斯点),多人同屏仍能保持实时,这是“能不能上线”的分水岭。

HRM²Avatar 的核心价值:把“结构稳定”和“细节真实”分开管

一句话概括它的方法论:用显式服装网格负责“骨架与可控性”,用高斯表示负责“褶皱、材质、光照这种高频细节”,再针对姿态变化建立动态响应。

混合表示:网格是骨,高斯是皮

很多单目重建的痛点是“既要能动画驱动,又要细节够真”。网格天然适合绑定骨骼、保证拓扑稳定;高斯(3DGS/2DGS)擅长表达细节和连续外观。

HRM²Avatar 把两者组合:

- 显式衣物网格:保证衣服边界、拓扑、动画一致性(不容易穿帮)

- 高斯细节层:表达褶皱、材质反射、头发软过渡、阴影变化

这其实是非常“工程化”的路线:不追求一个表示把所有问题吃掉,而是让每个表示干自己擅长的活。

两阶段手机采集:静态打底,动态补细节

它的采集策略很务实:

- 静态扫描:用户相对固定姿态,手机绕拍,拿到稳定结构与纹理

- 动态扫描:用户做自然动作,捕捉衣物随动作的变化、遮挡和光照响应

这解决了一个常被忽视的问题:单目视频里“外观变化”和“动作变化”容易纠缠。先把静态“底座”打牢,再用动态序列学习“动作驱动的变化”,训练更稳定,结果更可信。

动态光照建模:让“人”看起来在同一个世界里

很多虚拟人一眼假,根源不是几何,而是光照:动作变了,阴影不变;转身了,高光不走。

HRM²Avatar 用轻量的姿态相关光照项去拟合这种变化。你可以把它理解成:

- 不是做复杂的全局光照重建

- 而是抓住“随姿态变化最显眼的那部分光照差异”

对电商导购尤其重要:近景讲解时,脸部阴影、衣物高光都决定了“质感”。

移动端渲染优化:把每一分带宽都花在刀刃上

移动端实时不是一句“轻量化”能解决的。它做了多层裁剪、按需解码、深度量化排序、硬件栅格化等策略,核心目标只有一个:

- 尽量少让不可见、贡献小的高斯参与计算

- 尽量减少显存带宽与排序开销

这类“渲染链路重写”的工作,往往才是从论文到业务落地的临门一脚。

电商与新零售怎么用:从“导购形象”到“经营系统”

结论先给:手机级 3D 数字人,会让虚拟导购从“形象工程”变成“可运营资产”。

1)虚拟导购:从统一模板到千店千面

过去虚拟导购常用统一形象,因为建模成本太高。门槛降低后,新的打法会出现:

- 门店店员/主播快速生成数字分身,保持人设与专业度

- 不同城市、不同品类用不同导购形象(更贴近客群)

- 节日节点(年货节、春节)快速换装与场景化布置

虚拟导购真正的价值不是“好看”,而是:提升停留、降低咨询成本、提高转化效率。当制作成本下降,A/B 测试和快速迭代才做得起来。

2)沉浸式购物:从“3D 展示”到“3D 互动”

很多 3D 商品展示停留在“旋转看看”。数字人加入后,用户体验会更像线下:

- 数字人主动演示穿搭、材质、尺码效果

- 结合 MR/AR:在门店或家中“同屏对比”不同搭配

- 多人同屏导览:商场级导购、主题展陈讲解

3)个性化推荐:数字人变成“可解释的推荐界面”

推荐系统一直缺一个“更像人”的表达层。数字人可以承担解释与引导:

- 不是弹窗告诉你“你可能喜欢”

- 而是导购用自然动作指向差异点(领口、面料、版型)

我更看好这条路线:推荐从算法结果,变成可交互、可解释、可被用户纠正的对话过程。

放到游戏与数字娱乐:写实NPC与UGC角色会更快普及

这篇内容虽然来自电商技术团队,但它对“人工智能在游戏与数字娱乐”非常对口。原因很简单:游戏需要海量角色与稳定实时渲染。

1)写实 NPC:低成本生产 + 高一致性动画

写实 NPC 的瓶颈从来不是“有没有建模师”,而是“规模化生产”和“统一质量”。手机扫描 + 可驱动数字人意味着:

- 工作室可以快速采集演员/玩家形象

- 生成稳定可驱动角色,减少手工修模时间

- 在移动端或 MR 设备上更容易跑得动

2)UGC 角色:从捏脸走向“拍脸/拍全身”

玩家愿意为身份表达付费。与其让玩家在捏脸界面调一小时,不如让他用手机拍一段视频,直接生成“像自己”的写实形象,再在游戏里换装、换发型、加皮肤。

这里的商业想象空间很大:订阅式衣橱、联名服饰、虚拟演出门票、MR 社交空间等。

落地时别忽略的三件事:数据、合规与体验指标

技术能跑起来只是开始。要在电商/新零售或游戏里规模化,我建议优先把下面三件事写进项目章程。

1)数据策略:采集协议要产品化

“两阶段扫描”听起来简单,但要做到用户不掉队,需要:

- 拍摄引导(姿态、距离、转圈速度)

- 失败提示(光太暗、背景太乱、抖动过大)

- 质量分级(可用/良好/优秀)与自动补救建议

把它当作一个“交付流程”,而不是“用户会自己拍好”。

2)隐私与授权:数字人是更敏感的生物信息

数字人涉及人脸、体型、穿着信息。商业化必须做到:

- 明确授权范围(用于导购/用于营销/用于训练)

- 可撤回机制与可删除机制

- 存储与传输的安全策略

这不是拖慢项目,而是避免上线后被迫回滚。

3)体验指标:别只盯渲染帧率

电商虚拟导购是否有效,建议用“经营指标”而不是“技术指标”验收:

- 停留时长提升(秒级)

- 咨询转化率提升(相对提升%)

- 自助解决率(减少人工客服占比)

- 复访率与关注率(导购人设是否成立)

帧率是底线,增长才是目的。

下一步怎么做:一条更现实的推进路线

如果你在负责电商虚拟人或游戏写实角色,我推荐的落地顺序是:

- 先做“可控的单场景”:比如商品讲解位、固定灯光、固定镜头语言

- 再做“可运营的多版本”:同一导购的不同服装、不同节日皮肤

- 最后做“跨场景实时互动”:门店 MR、直播间多机位、多人同屏

这条路线的好处是:每一步都有业务收益,不会把团队拖进“无限优化真实感”的泥潭。

一句很直白的判断:当高保真 3D 数字人能用手机生成、能在手机上实时跑起来,它就不再是技术展示,而是内容生产体系的一部分。

年末到年初是新零售最忙的档期,也是验证虚拟导购价值的最佳窗口。你更想把数字人当作“营销素材”,还是当作“可持续增长的交互入口”?这会决定你 2026 年的投入方向。