Sharge融资近1亿元押注AI眼镜,多模态记忆引擎把音视频变成可检索记忆。本文拆解其对车载软件与智能座舱UX的启发与落地清单。

AI眼镜融资背后:多模态记忆引擎如何重塑车载软件体验

2025-12-29,消费电子公司 Sharge 宣布完成近 1亿元人民币(约 1429 万美元)A+ 轮融资,并把火力集中在一件事上:把新一代 AI 眼镜做成规模化产品,目标是 一年出货 10 万台以上。很多人把它当作“又一款可穿戴新品”,但我更愿意把它看成一个更大的信号:AI 的竞争正在从“能不能回答”转向“能不能记住、能不能持续陪伴、能不能在不同设备之间无缝协同”。

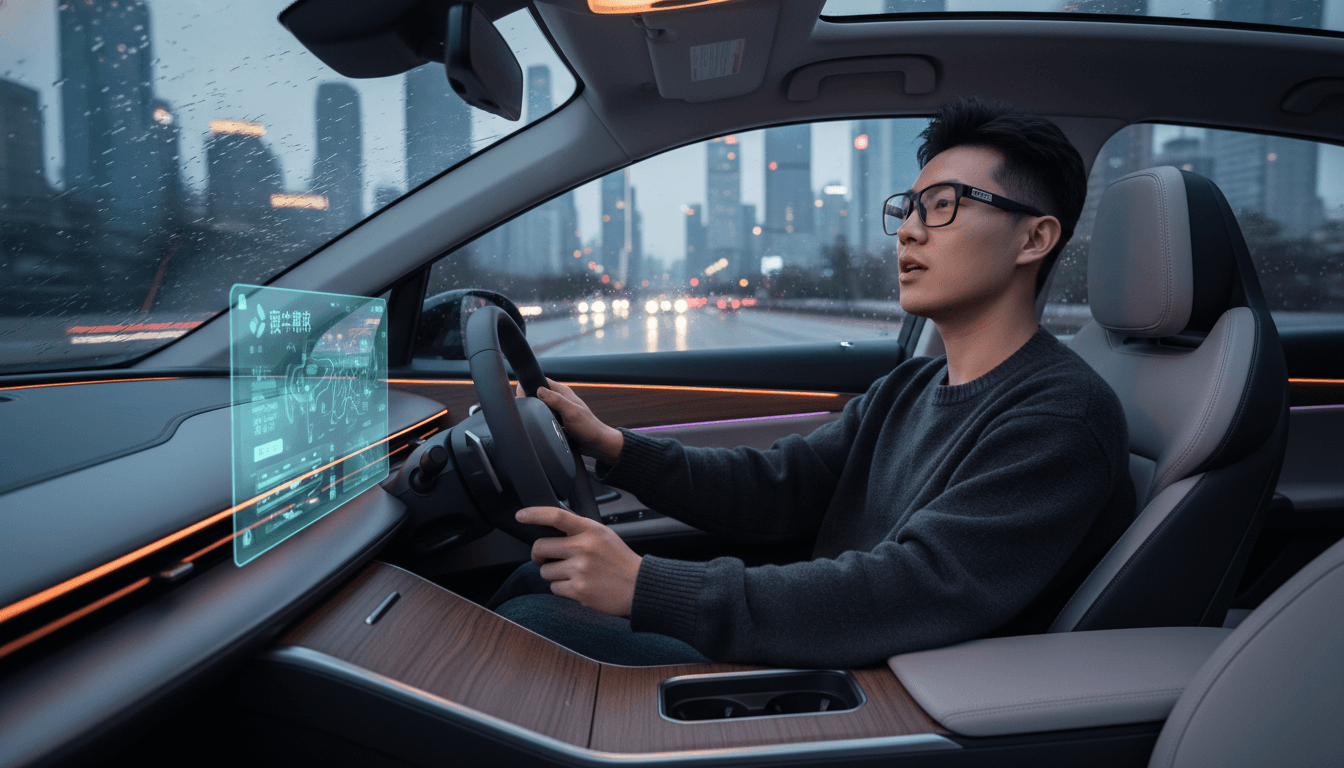

这对汽车行业、尤其是车载软件与用户体验(UX)来说非常关键。智能座舱正在变成“移动机器人”的交互中枢:它要听得懂、看得懂、记得住,还要在合规边界内把体验做得足够贴心。Sharge 这次押注的“多模态记忆引擎”,本质上和智能车在做的“长期用户模型、持续学习与 OTA 迭代”是一条线上的事。

这一篇属于「人工智能在机器人产业」系列:当服务机器人、人机协作系统走向日常化,可穿戴设备与智能车会一起成为“人类的外部感知与记忆器官”。

资金、产线与出货目标:AI硬件正在走“汽车路线”

**结论先说:AI 眼镜的胜负不只在模型,而在“产线、功耗与迭代速度”。**Sharge 的融资用途很明确:搭建更灵活的个性化产线、建设“算存一体”的服务器集群(用于主动式 AI 记忆),并推进全球市场扩张。

这套打法听起来像不像你熟悉的智能车?

- 柔性产线:不同脸型、不同镜片方案、不同显示模组与电池配置,最终都指向一个词——规模化定制。汽车行业早就验证过:平台化+模块化能显著压缩成本并加快迭代。

- 基础设施先行:Sharge 提到的“计算-记忆融合服务器集群”,对应到车端就是“云端训练与车端部署”的 MLOps 体系。体验不是一次性交付,而是持续升级。

- 出货目标的意义:一年 10 万台对眼镜品类不算“天文数字”,但它意味着产品必须跨过“实验室可用”到“日常可戴”的门槛:重量、发热、续航、稳定性、售后都要过线。

同时,IDC 数据显示:2025 年上半年全球智能眼镜出货同比增长 64.2%,其中中国占比 26.6%;中国 2025 年全年出货预计约 291 万台。这说明市场热度足够,但也意味着竞争会快速进入“拼体验、拼生态”的阶段。

多模态AI记忆引擎:把“当下”变成“可检索的过去”

**结论先说:多模态记忆引擎的价值在于“把音视频流变成结构化、可搜索、可复用的个人知识库”。**Sharge 与 memories.ai 合作,将实时音视频转成可检索的结构化记忆,并支持自动生成日记、周报等功能。

这类能力看似是“效率工具”,但它真正改变的是交互方式:从“你问我答”变成“我知道你经历过什么,所以我能主动帮你整理”。

记忆引擎如何工作(用人话讲)

把它拆开看,其实是三段式流水线:

- 采集:麦克风/相机获得连续信号(语音、画面、环境声音)。

- 理解与索引:ASR 转写、视觉识别、事件抽取、时间线归档,生成

人物-地点-事件-意图等标签。 - 检索与生成:用户一句话触发检索,再由生成式模型组织成摘要、待办、报告。

关键点不在“生成得多漂亮”,而在索引质量与可控性:错记、漏记、记混人名地点,体验会瞬间崩盘。

为什么这对智能座舱是“同一道题”

智能车的座舱正在遇到同样的需求:

- 车机不应只“导航+音乐+语音助手”,而应能形成驾驶与生活的连续上下文。

- 用户真正想要的是:我昨天说的那家餐厅、上周讨论的出差安排、孩子的接送地点变化,车机能在合适的时刻提醒,并且不越界。

一句话很适合做引用:“未来的交互不靠按钮数量,靠系统对你生活脉络的理解深度。”

舒适度与功耗:决定“日常佩戴”的不是模型,而是工程

**结论先说:可穿戴设备的 UX 底线是“戴得住”,上限才是“聪明”。**Sharge 在硬件侧强调两点:显示方案降低功耗(与光峰合作的“Dragonfly Light Engine”),以及材料与结构减重,目标是全天候舒适佩戴。

这和汽车软件体验有一个共同规律:交互再聪明,也不能破坏基本体验。

- 对眼镜来说,底线是重量、鼻托压力、镜腿夹持、发热、续航。

- 对汽车来说,底线是语音唤醒稳定性、车机流畅度、关键功能可达性、对驾驶的干扰控制。

我见过不少“功能很炫”的产品败在细节:续航撑不到通勤往返、镜框压得头疼、语音老是误唤醒。用户不会给第二次机会。

给汽车团队的直接启发:用“功耗预算”管AI体验

很多车载 AI 功能做不好,不是算法不行,而是缺少像硬件团队那样的“预算思维”。建议把体验拆成可量化的指标:

- 唤醒与响应时延预算:如 300ms 内反馈、1.5s 内给出可执行方案。

- 稳定性预算:高频场景(导航、通话、空调)容错优先级高于“花哨技能”。

- 注意力预算:驾驶时减少长对话,更多用一句话确认与 HUD/声学反馈。

可穿戴的“全天候舒适”对应到座舱,就是“全天候不打扰”。

从AI眼镜到智能车:个性化体验的下一站是“跨设备记忆”

**结论先说:真正的个性化不在单设备,而在“跨设备一致的用户记忆与权限体系”。**AI 眼镜记录的是生活现场,智能车记录的是移动轨迹与驾驶偏好,手机记录的是通信与日程,家里的服务机器人记录的是家庭任务。把这些拼起来,才是完整的用户体验。

但这件事最难的不是技术,而是三道门槛:

1)隐私与合规:默认不开采集,默认可删除

多模态记忆天然涉及敏感信息。一个可用的产品必须做到:

- 默认最小化采集:可控开关、场景提示、敏感区域屏蔽。

- 端侧优先:能在本地完成的处理尽量本地完成,降低数据外流。

- 可解释与可删除:用户能看到“你为什么推荐”,也能一键删除某段记忆。

这同样是车载 AI 的红线:座舱要聪明,但不能让用户觉得“被监视”。

2)记忆质量:少记错,比多记更重要

AI 记忆的体验很脆:一次“把同事当成客户”、一次“把地点记错”,就会让用户关闭功能。工程上需要:

- 人物/地点的歧义消解(同名、近似发音)

- 时间线冲突处理

- 置信度提示与二次确认机制

3)生态协同:把“周报”变成“下一步动作”

自动日记、周报只是起点。更有价值的是把结构化记忆接入任务系统:

- 自动生成待办并同步到日程

- 会议纪要一键转成工单

- 通勤途中由车机播报“今天最重要的三件事”

当服务机器人进入家庭,眼镜与车机还可以把任务交给机器人执行:比如到家后提醒扫地机器人清扫某区域、或让陪护机器人在老人服药时间主动提醒。

采购与产品负责人最该问的5个问题(实操版)

**结论先说:评估“带记忆的AI设备/车载系统”,别只看演示,要用问题把真实能力逼出来。**我建议从这 5 个问题入手:

- **记忆数据默认存哪里?**端侧/云端/混合?用户能否导出与删除?

- **多模态检索的准确率怎么测?**有没有按真实场景(嘈杂、弱光、多人对话)测试集?

- **误采集与误唤醒怎么处理?**是否有快速“静音/隐私模式”?

- **和车载系统/机器人系统怎么集成?**是否提供权限分级、账号体系与审计日志?

- **OTA 迭代的节奏与回滚机制?**升级失败怎么保障核心功能?

这些问题看似“挑刺”,但它们直接决定用户会不会长期用。

结尾:AI记忆正在成为新入口,车载UX要提前占位

Sharge 这次融资与产品路线传递了一个清晰信号:**AI 的价值正在从“回答问题”转向“管理你的时间、经历与任务”。**多模态记忆引擎把现实世界转成结构化资产,这会让 AI 眼镜不仅是硬件,更像一个随身的“感知型机器人”。

对智能车来说,这不是隔壁行业的热闹,而是同一条赛道的预演:谁能把“记忆、个性化与合规”三者同时做好,谁就能把座舱从功能集合变成用户的长期伙伴。你更看好哪一种路径:由手机做统一记忆中枢,还是由车端与可穿戴共同承担?