R-HORIZON揭示推理模型在多步任务中的断崖式退化,并给出可扩展评测与训练方法。本文结合电商场景,讲清如何用长链推理改进补货、仓储与定价。

长链推理评测R-HORIZON:让电商AI把“多步决策”做对

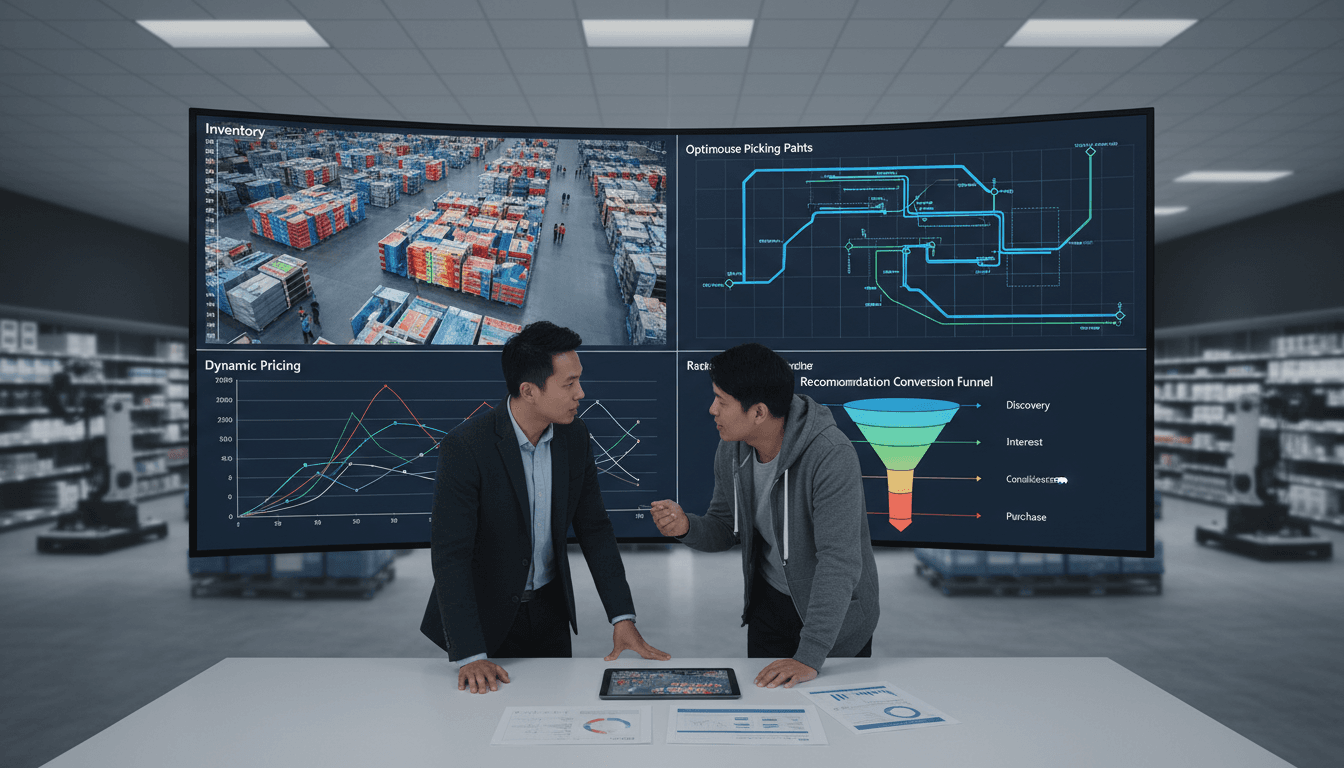

电商和新零售里,真正难的从来不是“答对一道题”,而是把一串互相牵连的决策做对:先预测需求,再定补货量;再安排仓内拣选与波次;再结合履约时效动态定价;最后把推荐位和促销资源一起排布。任何一步出错,后面全盘跟着偏。

我见过不少团队把“推理模型”直接搬进运营后台,结果上线一周就开始抱怨:模型单点能力很强,但一旦让它连续处理 5~8 个相关步骤,就会出现明显退化——前面想得很细,后面草草收尾;或者中途自我纠错只盯着当前一步,完全没意识到前两步的前提已经变了。

这正是复旦 NLP 与美团 LongCat 在 2025-11-28 提出的 R-HORIZON 想解决的核心:大型推理模型(LRMs)在“长链推理”场景到底能走多远,瓶颈在哪里,怎么用可扩展的训练方式补上短板。这篇文章把论文里的关键结论翻译成电商人能用的语言,并补上落地方法与评测清单,帮助你把“会推理的 AI”真正接进业务链路。

为什么电商AI最缺的不是“聪明”,而是“耐心和一致性”

结论先说:电商与新零售的核心难题,是跨步骤的一致性与资源分配,而不是单步最优。

主流基准(例如数学、竞赛题、单轮编码任务)偏向“一问一答”。这类评测能证明模型聪明,但证明不了它能否在多轮、多任务、强依赖的链路里保持稳定。而电商恰恰是强依赖系统:

- 需求预测 → 库存/补货 → 仓内作业 → 履约时效 → 动态定价/促销

- 人群分层 → 推荐曝光 → 转化反馈 → 再训练/策略更新

- 商品知识理解 → 生成卖点与问答 → 处理售后争议 → 风险与合规

R-HORIZON 指出一个常被忽视的事实:当问题从“单题”变成“组合链”时,模型会出现性能断崖。

文中给了非常直观的数据:DeepSeek-R1 在 AIME25 单问题准确率 87.3%,但在 5 个组合问题场景下跌到 24.6%。这类跌幅放到电商就意味着:你以为它能稳定跑通“预测-补货-排仓-定价”,实际上可能跑到第三步就开始胡。

R-HORIZON做了什么:把“独立问题”拼成可控的推理链

结论先说:R-HORIZON 的核心价值,是用一种低成本方式,把现成数据集改造成“长链依赖任务”,从而系统评估与训练长链推理能力。

它提出的范式叫 Query Composition(问题组合),思路很工程化:

- 信息提取:从单题里抽取关键变量(数值、实体、条件等)

- 依赖构建:把前序答案嵌入后续题干,形成强依赖

- 链式推理:模型必须按顺序解完,才能拿到最终结果

对电商读者来说,可以把它理解为:把“单点任务”拼成“业务流程”。例如把原本互不相关的任务,改造成:

- 第 1 步:根据近 30 天销量与节日效应估算下周需求

- 第 2 步:把第 1 步的需求作为约束,计算安全库存与补货量

- 第 3 步:把补货量与仓容/人力作为约束,生成入库与拣选波次

- 第 4 步:把预计缺货风险与履约成本作为条件,输出动态定价区间

- 第 5 步:把价格与人群敏感度作为条件,生成推荐与促销分配策略

关键不在于“链很长”,而在于链上每一步都有明确依赖,这样才能测出模型是否真的具备长程推理与跨步一致性。

R-HORIZON评测揭示的三大瓶颈:电商落地会踩的坑

结论先说:长链推理退化不是玄学,主要栽在“有效推理长度、反思跨步能力、思考预算分配”这三件事上。

1)有效推理长度受限:不是上下文越长越能算

R-HORIZON 的机制分析发现:模型错误会集中出现在某些上下文范围内。

- 7B 模型的主要错误范围在 4–6K tokens

- 32B 模型扩展到 8–10K tokens

放到电商,就是你让模型读完整个活动方案、再读库存表、再读仓网约束、再读促销规则,并不等于它真的“有效理解并稳定推理”。它可能“看到了”,但推理链后半段开始漂移。

落地建议:把复杂链路拆成“短链 + 可验证节点”,并把关键中间变量结构化落库(例如:预测值、置信区间、约束条件、成本项)。

2)反思机制高度局部化:只会纠错当前一步

论文发现:复杂任务里,超过半数完全缺乏长程反思。模型会“反思”,但往往只针对当前子问题,不会回头检查前序假设。

电商典型翻车场景:

- 动态定价时发现毛利不达标,但它只调整价格,不回头检查“需求预测是否过高导致补货过量”。

- 生成客服处理方案时发现用户不满,但它只换措辞,不回头核对“订单履约节点是否已经超时、是否触发赔付规则”。

落地建议:在链路中加入“跨步核对”提示与工具化校验,例如:

- 每 2~3 步强制输出一次全局状态摘要(关键变量 + 约束 + 风险)

- 设置“反思触发器”(例如成本超阈值、缺货概率超阈值)后要求回溯前置步骤

3)思考预算分配失衡:前面想太多,后面不够用

最有启发的一点是:主流 LRMs 往往把 token 预算过度花在早期步骤,导致后面关键步骤敷衍。

这在运营场景特别常见:模型在“解释市场趋势”写了半页,但到“输出可执行的补货清单/仓配计划/价格表”时只给一个模糊建议。

落地建议:用“预算分段”方式管控输出:

- 规定每一步必须包含固定字段(输入、决策、理由、数值、风险、下一步需要的变量)

- 对后半段关键步骤设置更高的 token 上限或更高的奖励权重

把R-HORIZON放进电商:三类高价值场景怎么评测与训练

结论先说:长链推理在电商里最该优先落在“库存与履约、动态定价、个性化推荐”三条链路。评测先行,能少走半年弯路。

场景一:需求预测 × 库存管理 × 智能仓储调度

这条链路的共同特征是:约束多、步骤多、容错率低。

建议你按 R-HORIZON 的思路做内部基准:

- n=2:预测 → 补货(验证基本一致性)

- n=4:预测 → 补货 → 仓容校验 → 波次/人力排程(验证约束传递)

- n=8:加入异常(断供、天气、爆品突增、仓内拥堵)与回溯修正(验证长程反思)

评测指标别只看“最终利润/成本”,要加上可定位的过程指标:

- 中间变量正确率(补货量是否满足安全库存约束)

- 约束违背率(仓容、人力、时效 SLA)

- 回溯修正成功率(触发器出现后是否能修正前置假设)

场景二:动态定价与促销编排(多目标权衡)

动态定价不是“给个价格”,而是在毛利、转化、库存、竞品、平台规则之间做多步权衡。

用组合任务去测更贴近现实:

- 读取成本与库存压力

- 估算价格弹性(或按人群分层给弹性区间)

- 结合竞品价与平台价保规则给可行区间

- 选择促销工具(券、满减、会员价)并计算叠加后到手价

- 评估对 GMV、毛利、缺货风险的影响,必要时回滚第 2~4 步

如果模型在第 4~5 步开始“糊弄”,多半就是预算分配问题,需要像 R-HORIZON 提示的那样,把奖励与输出预算向后半段倾斜。

场景三:个性化推荐的“长链因果”:从人群到货架再到内容

推荐系统常被误解成“算相似度”。新零售真正要的是:

- 先判断用户阶段(尝鲜、复购、价格敏感、囤货型)

- 再判断场景(到家、到店、即时零售)

- 再匹配库存与履约能力(能不能及时送达)

- 最后生成货架排序与内容表达(标题、卖点、问答)

这是一条典型长链:人群判断错了,后面排序、内容、促销全错。

建议的内部“R-HORIZON式评测”做法:把单条样本拆成多步依赖任务,并强制模型输出结构化中间结论(人群标签、场景标签、履约约束、候选集缩小理由)。这样你能定位它到底是“理解错”还是“推理漂移”。

训练与迭代:用“组合数据+强化学习”把能力补上

结论先说:R-HORIZON 证明了一个很实用的路径——用组合任务数据做强化学习训练,不仅长链更稳,单题能力也会提升。

他们用组合数据(n=2、n=4)配合 RLVR(例如 GRPO)训练后,出现“双重提升”:

- 多步推理得分明显提高(例如 AIME24 n=2 提升 17.4 分)

- 单问题也提升(AIME24 单题提升 7.5 分)

对企业团队来说,不一定要从零搞 RL。更现实的路线是“三段式迭代”:

- 先评测:用 Query Composition 思路快速拼出你们的业务长链基准(从 n=2 开始)

- 再对齐:用监督微调把输出格式、约束表达、工具调用流程稳定下来

- 后强化:把“后半段步骤质量”“约束满足率”“回溯修正成功率”做成奖励信号,逐步提高链路鲁棒性

我更支持“评测先行”。没有长链基准,模型表现好坏只能靠线上指标猜,定位成本很高。

下一步:把“长链推理”变成可运营的生产能力

长链推理对电商与新零售的意义很直接:**它让 AI 不只是给建议,而是能把跨团队、跨系统的决策链条跑通,并且在后半程仍然可靠。**R-HORIZON 的价值在于把这件事从“感觉”变成“可测、可训、可迭代”。

如果你正在做智能补货、智能仓储调度、动态定价或个性化推荐,我建议从一个小而硬的项目开始:选一条链路,设计 n=2 与 n=4 的组合任务,先把“中间变量与约束”结构化,再去谈更长的 n=8。等你能稳定通过内部基准,上线的波动会小很多。

电商 AI 的竞争,越来越像马拉松:短跑快不难,难的是每一公里都不掉速。你更希望自己的模型在哪条业务链路里先跑出“长链稳定性”?