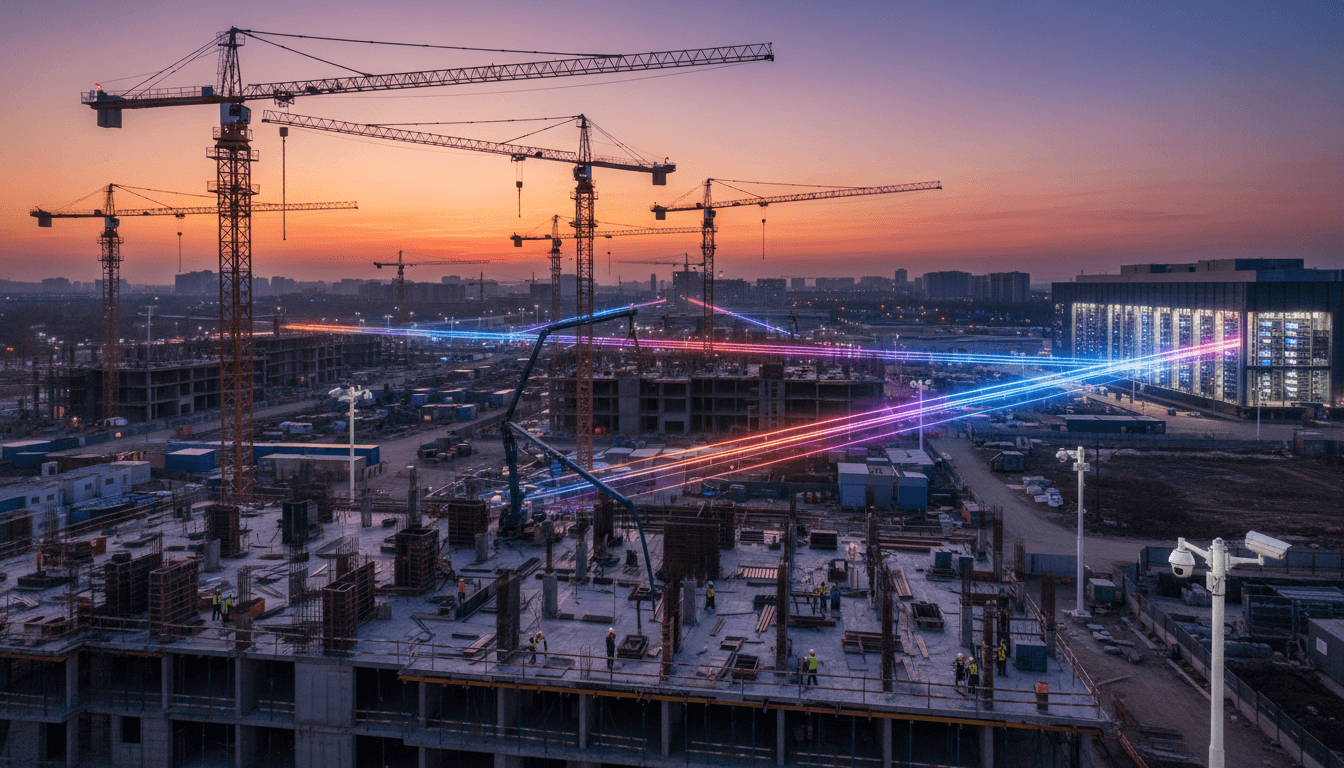

显卡没跑满,先被“网线”拖后腿。数据中心的带宽与功耗危机,正在提前预告智慧工地的AI基础设施瓶颈。建筑企业该怎么布局?

AI 安全帽摄像头一开,一整天的视频流、人员轨迹、机械运行数据就开始“狂飙”。不少施工单位在做智慧工地试点时都会发现一个尴尬现实:算法没问题,模型也够用,真正卡住的,是网。

这跟近期业界讨论很火的一个话题高度一致——显卡还没跑满,数据中心先被“网线”卡住了。AI 算力中心在被带宽、延迟和功耗掣肘,中国建筑企业要做的智慧工地,其实在走同一条路:只要大规模上 AI,迟早都会撞上“网络天花板”。

本文想聊的就是:从数据中心的网线危机,到 MicroLED 光互联这类新技术,能给智慧工地和建筑业数字化带来什么启发?如果你正在规划 AI 监控、BIM 协同或算力中心落地,这些技术趋势跟你息息相关。

一、算力中心都被“网线卡脖子”,建筑业更跑不掉

核心结论先放在前面:AI 项目真正的瓶颈,越来越不在显卡,而在网络和数据传输。

在大模型和多 GPU 集群的数据中心里,已经出现了一个典型现象:

- GPU 理论算力还没跑满

- 服务器之间、GPU 之间的数据传不动

- 结果就是“显卡在等网线”,算法在等 IO

为什么会这样?

1. 家用网和算力中心,完全不是一个世界

我们日常用的网线:

- 家宽主流:

1–2.5 Gbps - 少数“万兆宽带”:

10 Gbps左右

而 AI 算力中心:

- 数据中心交换机:

100 Gbps只是起步 - 面向大模型训练的交换机:

400 Gbps已成趋势 - 单个 AI 机柜甚至要做到

800 Gbps – 3.2 Tbps的链路

这意味着什么?相当于你用一条家用小水管,去喂一个城市的自来水系统,肯定要炸。

建筑行业如果认真做智慧工地,压力其实类似:

- 多工地同时在线采集视频、位置信息、机械工况、环境监测

- 大量 BIM 模型、点云数据、扫描成果需要在设计院、项目部、总包、分包之间协同

- 越来越多的现场 AI 推理(如安全帽识别、危险区域闯入预警)要与云端大模型打配合

没有大模型训练那种夸张的带宽,但如果你做的是集团级、跨区域、全生命周期的“建筑工业互联网”,网络也绝对不再是个“随便拉条万兆光纤”的简单问题。

2. 铜缆、光纤,各有硬伤

在数据中心,传统的两种连接方式都已经开始吃力:

-

高速铜缆:

- 速率高,但距离短

- 为满足 400 Gbps 这类速率,线缆长度往往只有 1–2 m

- 适合机柜内部 GPU 之间的短距离互联

-

光纤:

- 跑得远、带宽大

- 但需要复杂的“光电转换”电路

- 功耗高、对温度敏感,在高温机房里故障率不低

微软在一篇关于 MOSAIC(MicroLED 光互联)的论文里给了一个很扎心的数据:

如果英伟达 GB200 NVL72 机柜全部用传统光纤互联,整机功耗会增加约 17%,超大规模 GPU 集群每 6–12 小时就会发生一次链路故障。

这在施工现场如果对应过来,就是:你刚把所有塔机、升降机、门禁、视频全部上云,结果不是算法问题,而是网络每天反复掉线、延迟巨大,还疯狂发热烧钱。

二、从 MOSAIC 到智慧工地:网络瓶颈的“共同病根”

微软搞的 MOSAIC,本质是一种 MicroLED 光通信方案,但更值得建筑企业关注的,是它背后那套思路:别再靠“单通道死命提速”,而是用“宽而慢”的组合拳。

1. MOSAIC 的思路:不拼 1 条线有多快,而是拼有多少条线

传统光模块的玩法是:

- 一条光纤通道做到 50 Gbps、100 Gbps

- 调制电路极其复杂、功耗高、造价也不低

MOSAIC 则反着来:

- 用 MicroLED 像素做光源

- 每个像素就是一条独立的光通道

- 单个像素只跑

2 Gbps这种“低速” - 但一块阵列里可以干脆做 400 个像素

结果:

- 400 × 2 Gbps = 800 Gbps 总带宽

- 单通道“摸鱼”,整体却很快

从系统设计角度看,这个逻辑很厉害:

- 把单点性能压力,变成了规模扩展

- 像极了建筑行业从“单机功率”转向“成套装备协同”的思路

2. 体积更小、功耗更低,意味着什么?

MicroLED 的发光芯片很小:

- 单个像素几微米量级

- 400 像素阵列,核心芯片体积不到

1 mm³ - 对比传统 800 Gbps 光模块,核心光源 / 调制器通常是

十几 mm²甚至几十 mm³

更重要的是功耗:

在相同带宽下,MOSAIC 的功耗最多可比传统光纤互联降低约 68%,链路故障率可以降到原来的 1/100 量级。

对算力中心,这意味着:

- 同样机房面积里,可以塞下更高密度的 GPU 集群

- 电力、制冷压力显著降低

对智慧工地和建筑企业私有云,这意味着:

- 你在园区机房、区域数据中心里能更轻松地支撑多项目、多工地接入

- 不用为每上一个 AI 应用,就再加一倍的机房空调和供电

3. “宽而慢”的理念,完全可以迁移到工地网络设计

很多施工企业在搞智慧工地时,常见误区是:

- 一门心思想把“主干网带宽”拉到越大越好

- 但接入层、边缘算力、协议和架构并没有重新设计

结果就是:

- 主干网络利用率很低

- 前端摄像头、网关、塔机黑匣子互相抢带宽

- 一旦有大文件(如 BIM 模型、点云)传输,现场监控就开始卡顿

从 MOSAIC 的思路借鉴过来,其实可以考虑:

- 不必要求每条链路都极致高速

- 但要设计足够多的“并行通道”和边缘节点

- 把 AI 任务拆分成多路、分层次传输

这对搞“多工地统一管控平台”的央企、地方城投、上市房企尤其关键。

三、智慧工地的高带宽场景,远比想象中多

当你把施工现场真正数字化之后,会发现 “需要带宽”的不是一个点,而是一整条链路。

1. 实时视频与 AI 监控

典型的智慧工地 AI 场景:

- 安全帽 / 反光衣佩戴识别

- 高空抛物监测

- 危险区域闯入告警

- 洞口临边防护检测

如果全部在云端做 AI 推理,就意味着:

- 每路视频要稳定上传

- 分辨率最好在 1080p 甚至 4K

- 延迟还不能太高,否则告警就成了“事后录像”

对一个中大型工地,几十到上百路视频非常常见,如果是集团平台统一调度,成百上千路视频同时在线也不夸张。

这跟数据中心的大带宽需求,本质是一回事:都是多源数据的高并发传输问题。

2. BIM 协同、三维扫描与质量追溯

建筑行业数字化的另一块大头,是 BIM 和三维数据:

- 模型文件动辄几个 GB

- 扫描点云、倾斜摄影成果更是“海量”

如果你希望:

- 设计、总包、监理、甲方同时在线协同

- 质量问题可以精确追溯到模型构件、施工批次

- AI 能对模型和实景进行自动比对、偏差分析

那背后就需要:

- 高带宽 + 低时延 + 跨地域的稳定网络

- 以及有能力吃下这些数据的算力平台

简单说:想要“智慧工地真正落地”,就离不开和算力中心一样严肃的网络工程思维,而不是“先上点摄像头感受一下氛围”。

四、从数据中心新技术,倒推建筑企业该怎么规划网络

MicroLED 光互联目前还在技术验证阶段,短期内不会直接出现在施工现场。但它给了我们三个明确信号:

- 带宽一定会继续涨,算力一定会继续集中。

- 功耗、可靠性会成为比“跑多快”更优先的指标。

- 未来网络会更像“多车道高速公路”,而不是一条极限超车道。

基于这些趋势,建筑企业在规划智慧工地和 AI 基础设施时,可以提早做几件务实的事。

1. 优先建设“云 + 边缘”的算力架构

不要指望所有 AI 推理都丢到远端云端:

- 在工地侧部署边缘算力节点(边缘服务器、AI 网关)

- 就近处理视频分析、安全告警等实时性高的任务

- 只把结构化结果、关键片段、模型更新等上传云端

这样做有几个好处:

- 大幅降低对上行带宽的极端依赖

- 网络抖动、延迟对业务影响更小

- 未来如果接入像 MOSAIC 这种高带宽互联,也可以自然叠加

2. 把“多通道”理念写进网络规划

很多工地现在还是“一条光纤走天下”:

- 视频、办公、BIM、物联网全挤在一张逻辑网里

建议在新项目 / 新园区规划时,至少做到:

- 逻辑上划分多条业务通道(如视频专网、生产数据网、办公网)

- 对关键 AI 场景预留独立带宽或 QOS 策略

- 在骨干网络上预留多芯光纤资源,为未来新技术(包括多芯成像光纤等)留扩展空间

这和 MOSAIC 用很多“慢通道”组合成“快总带宽”的思路,本质是一套打法。

3. 把“功耗”和“运维难度”当成一等指标

数据中心的经验已经证明:

- 只看带宽,不看功耗和可靠性,很快会被电费和故障压垮

建筑行业往往有个误区:

- 把机房、电力、制冷当成“项目成本”去压价

- 忽略了未来 3–5 年的持续运维和扩容需求

更健康的做法是:

- 在方案评审阶段就要求给出 单位带宽功耗、故障率估算

- 评估整体 TCO,而不是只看一次性采购价

- 学习 MOSAIC 这类技术“以低功耗换高带宽”的方向,优先选择更节能、更易维护的网络设备与架构

五、AI 竞赛的下半场:谁先把“网”搞明白,谁就跑得久

现在的 AI 热潮里,大家讨论最多的是:

- 有没有大模型?

- 显卡够不够?

- 自研芯片进度怎样?

但从数据中心到智慧工地,真正决定“能不能规模落地”的,往往是那些“不那么显眼”的基础设施:

- 网络架构是不是为 AI 重新设计过

- 数据传输链路能不能扛得住多源并发

- 机房、电力、制冷能不能支撑长期的高负载

从华为 384 超节点,到英伟达 GB200,再到微软 MOSAIC,这些案例都在指向同一个未来:

通信效率的进步,正在一点点“弥补”单颗芯片算力的差距。

这对中国建筑行业其实是个利好:

- 也许你拿不到最新最贵的 GPU

- 但如果能先把企业级网络、算力架构、数据管道打通

- 完整的智慧工地体系一样能跑出不错的效果

所以,如果你负责的是集团数字化、智慧工地平台、建筑工业互联网建设,我会建议:

- 现在就把“网络和数据中心规划”从配角,提到 AI 战略的一线

- 用数据中心的这些前沿实践,反向审视自己的工地网络与园区机房

- 思考:当 AI 从一个试点项目,变成企业的日常基础设施时,我现在的“网”,撑得住吗?

谁先把这个问题想清楚,并在 2026 年前后完成一轮基础设施升级,谁就更有机会在 AI 在建筑行业的下半场,真正吃到红利。