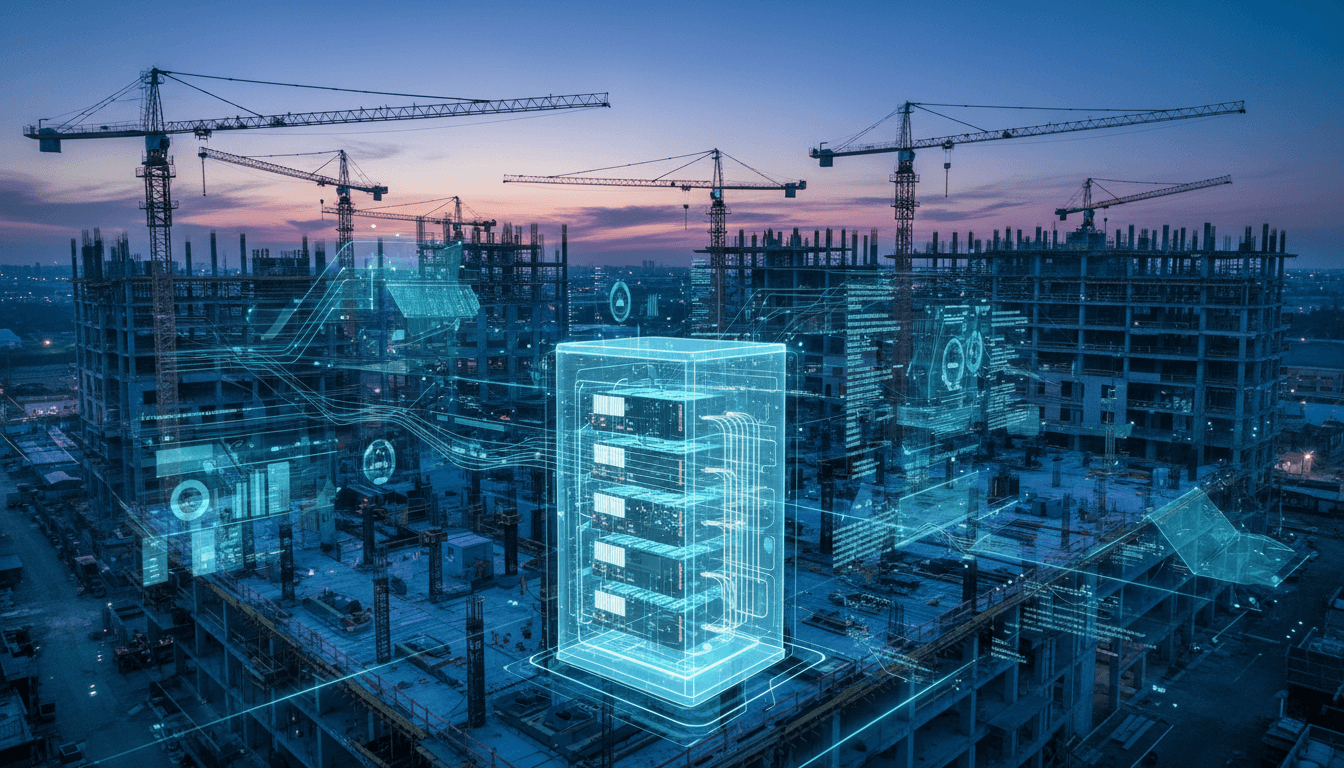

AI 推高全球存储价格的同时,也给智慧工地提了一个醒:没有“存力升级”,算力再强也跑不出好效果。本文从 SK 海力士 AI 存储战略出发,拆解智慧工地该如何重构自己的 AI 存储架构。

当前一台中高端智能手机因为内存、闪存涨价,普遍贵了100~300元;部分NAND产品合同价,11月单月就拉涨了60%以上。表面看是“缺货+涨价”,背后其实是同一股力量:AI基础设施在疯狂吃掉存储资源。

对建筑企业来说,这不是遥远的半导体故事,而是正在逼近工地的一场“基础设施重构”。未来3~5年,智慧工地要不要上更多AI视频分析、数字孪生、BIM协同,关键不在“算力够不够”,而在“存力跟不跟得上”。

SK 海力士最新抛出的“全线AI存储创造者”战略,给了建筑行业一个很好的参照:当存储厂商都开始为AI重做产品架构,智慧工地在规划AI系统时,也必须把“存储”从配角提到台前。

这篇文章会用相对好懂的语言,拆解 SK 海力士在 HBM、DRAM、NAND 上的 AI 布局,然后对照智慧工地场景,看一看:

- 为什么未来工地上跑AI,存储会先卡脖子?

- 定制化 HBM、高带宽闪存这些听上去很“硬核”的技术,对工地有什么现实启发?

- 建筑企业在规划下一代智慧工地平台时,应该怎么预留“存力升级”的空间?

一、AI 正在重塑存储:从“配角”变成基础设施

核心判断很简单:AI 不是在消耗一点点存储,而是在重写存储行业的路线图。

根据公开数据,AI 基础设施推高了 NAND 闪存需求,全球前五大 NAND 厂商单季度营收环比增长 16.5%,接近 171 亿美元;2025 年 DRAM 资本开支预计 537 亿美元,2026 年会涨到 613 亿美元。几乎所有增量,都和 AI 直接或间接相关。

对智慧工地,这个趋势有两层含义:

-

AI 应用越多,持续成本越高

- 大量高清视频+AI分析,产生的是“数据洪水”而不是“几条事件记录”;

- 工人定位、机械状态监测、BIM 模型更新,这些都是吃带宽、吃容量的活。

-

单靠“算力升级”解决不了问题

很多建筑企业的惯性思路是:AI 算不动了就上更强的 GPU 或云资源。但 SK 海力士、三星、美光这些巨头现在的选择是:先把内存、存储做成更懂 AI 的形态,再去谈算力。

换句话说,AI 时代的基础设施有三块:算力(CPU/GPU/ASIC)、存力(HBM/DRAM/NAND) 和网络。过去工地做信息化多盯第一块,现在必须开始系统规划后两块。

二、定制化 HBM:给智慧工地“云边一体”做样板

2.1 HBM 在 AI 里的真实角色:算力“喂不饱”就浪费

HBM(高带宽内存)本质上是给 GPU / XPU 做的“近身粮仓”。AI 大模型推理、训练越来越依赖 HBM 带宽和容量,算力芯片如果周边内存跟不上,就会频繁空转。

谷歌第七代 TPU 量产时,HBM 由 SK 海力士和三星供应,SK 海力士预计拿到约 56%~60% 的份额。更关键的是,SK 海力士已经不满足于提供“标准颗粒”,而是要做 定制化 HBM(Custom HBM):

- 把原本在 GPU/ASIC 里的协议、控制器,搬到 HBM 基座上;

- 甚至探索把 GPU 核心直接嵌进 HBM 基底芯片;

- 目标是:让算力芯片更专注于计算,让 HBM 主动分担一部分逻辑,降低接口能耗。

这件事的意义,可以用一句话概括:

HBM 不再是“被动存储”,而是变成了具备逻辑算力的主动部件。

2.2 对智慧工地的启发:靠近数据放“存力+算力”节点

智慧工地现在有一个常见痛点:

- 现场布满摄像头、传感器;

- 所有视频和数据回传到中心机房或云上分析;

- 网络一抖、带宽一紧,延时飙升,体验立刻崩。

定制化 HBM 其实给了建筑行业一个非常直观的思路:把一部分算力和“高带宽存储”捆在一起,搬到更靠近数据产生的地方。

对应到工地,就是:

- 在现场部署边缘节点:集成算力模块 + 高带宽内存/本地闪存;

- 现场完成 70%~80% 的视频结构化、违规识别、机械状态初筛;

- 只把结果和必要的特征数据回传云端;

- 云端负责大规模训练、历史数据挖掘、跨项目对比分析。

这种“云边一体”的架构,本质上就是把数据搬得更短,把算力和存力捆得更紧,和定制化 HBM 的理念是一致的:

不是一味堆“更大的云”,而是在靠近数据的地方,做更聪明的存储+计算组合。

2.3 规划建议:别只写“GPU配置”,要加上“存储形态”

当你下次和集成商、云厂商讨论智慧工地平台升级时,建议技术需求文档里加上几条:

- 要求边缘网关/服务器支持 高带宽内存或等效架构;

- 对比方案时,不只看算力 TFLOPS,还看 内存带宽、延时和能耗;

- 关键 AI 场景(安全帽识别、人员轨迹、塔吊防碰撞)要设计为 就近缓存+快速推理,不依赖长链路传输。

这其实是在用“HBM 思维”重新设计工地AI系统的地基。

三、AI DRAM:缓解“存储墙”,让 BIM、视频和传感器共存

3.1 DRAM 的三条 AI 路线:优化、突破、扩展

SK 海力士把 AI DRAM 划成三类:

-

AI-D O(Optimization)优化型

代表技术:MRDIMM、SOCAMM2、LPDDR5R 等,核心是用更高带宽、更低功耗的形式,把总拥有成本(TCO)降下来。 -

AI-D B(Breakthrough)突破型

通过 CXL 内存模块(CMM)、存内计算 PIM 等手段,缓解“存储墙”——CPU/GPU 算得很快,但内存跟不上。 -

AI-D E(Expansion)扩展型

把高阶 DRAM 能力,从数据中心扩展到机器人、移动终端、工业自动化等更广泛场景。

对建筑业最有价值的是前两类:如何在有限机房空间、有限预算下,让 BIM、大规模视频分析、物联网采集能在同一个平台上跑得更顺。

3.2 MRDIMM:给“综合指挥中心”减压

MRDIMM 的技术细节可以很复杂,但对决策者只要记住两点:

- 在相同内存容量下,运算效率是传统 RDIMM 的 1.2 倍左右;

- 把内存容量翻倍时,效率可以提高到 1.7 倍,内存与存储间的数据迁移次数减少约 10 倍(英特尔+美光测试数据)。

如果把这个效果映射到一个市级智慧工地指挥中心:

- 同一套服务器,能同时跑更多工地的视频分析流;

- BIM 模型在多人协同、版本合并时,不再频繁“卡死”;

- AI 进度预测、成本模拟可以用更大样本、更长时间窗的数据,而不是只取“一小段历史”。

3.3 对工地 IT 负责人:采购清单要“问到 DRAM 细节”

很多建筑企业现在买服务器,只关注:CPU 型号、内存总容量、硬盘大小,很少追问“DRAM 类型”。

在 AI 工地时代,这种粗粒度采购会直接拖累后端能力:

- 建议在项目中台、区域数据中心级别的服务器上,明确要求供应商给出 MRDIMM / 高速 DDR5 / CXL 内存路线图;

- 对核心 AI 节点,优先采用 更高带宽、可扩展的 DRAM 方案,哪怕前期多花 10%~15% 成本;

- 在总包和专业分包的系统集成招标文件中,加入“支持未来 AI 内存扩展能力”的技术条款。

一句话,别再把内存当作“能开机就行”的基础耗材。

四、AI NAND 与 HBF:智慧工地的“数据湖”该如何搭

4.1 AI NAND 的三大方向:性能、带宽、密度

在 NAND 闪存上,SK 海力士也给出三条 AI 路线:

-

AI-N P(Performance)性能型

针对大规模 AI 推理场景,重新设计 NAND 与控制器架构,2026 年底计划推出样品,目标是减少 AI 计算和存储之间的瓶颈。 -

AI-N B(Bandwidth)高带宽型

通过垂直堆叠芯粒,提高频宽,弥补 HBM 容量受限的问题,典型技术就是 HBF(高带宽闪存)。 -

AI-N D(Density)高密度型

迈向 PB 级容量,希望在保持 SSD 速度的同时,接近 HDD 的成本。

4.2 HBF:为工地打造“读得快、存得久”的数据底座

HBF 可以理解为:

把 HBM 的“高带宽特性”和 NAND 的“高密度低成本”做了一次结合。

闪迪和 SK 海力士已经签署谅解备忘录,准备在 2026 年后推出样品,目标是服务 AI 推理设备和数据中心。三星也在做类似方向的技术预研。

对智慧工地的数据平台,这种趋势非常关键——因为建筑数据本身就具有:

- 规模大:一个大型项目视频+模型+文档,轻松上百 TB;

- 生命周期长:从可研、设计、施工到运维,往往要保留十年以上;

- 冷热分层明显:最近一个月的视频热,半年以前的基本不看,但合规上又不能删。

传统做法要么:

- 全放在高性能存储上,贵;

- 全丢进廉价盘阵或对象存储上,未来训练/复盘时读得很慢。

HBF 这种形态,其实就是给“智慧工地数据湖”提供了更现实的想象:

- 热数据依然在高性能本地/云 SSD 上;

- 大量冷数据在 高带宽闪存池 中沉淀,需要再训练模型、做事故复盘时,可以在可接受时间内快速扫描几十 TB、上百 TB 历史数据。

4.3 设施规划建议:从一开始就按“PB 级”去思考

很多建筑企业现在规划数据中心,容量目标还停留在“几十 TB”。如果把 AI 的中长期需求算进去,其实是严重低估。

我会更建议以 PB 级目标容量 来做顶层设计,然后分阶段实施:

- 第一阶段(1~2 年):优先建设 AI 关键场景的“热数据池”,采用企业级 SSD + 合理冗余;

- 第二阶段(3~5 年):开始引入高带宽闪存或等效方案,把多项目、多年度数据纳入统一数据湖;

- 第三阶段(5 年后):结合城市级、集团级平台建设,把智慧工地数据变成集团资产,参与更高级别的 AI 训练和业务优化。

这里面最重要的心态转变是:工地数据不只是“留个痕迹”,而是未来 AI 的“燃料”。

五、建筑企业现在就能做的三件事

SK 海力士的 AI 存储路线图拉得很长,从 HBM4/4E、HBM5,到 400 层以上的 3D NAND、UFS 6.0。但对建筑企业来说,不需要去记每一个技术名词,更关键是把方向吃透,然后在当前决策中留下“接口”。

结合前面的分析,我觉得现在就可以落地的有三件事:

5.1 在智慧工地总体规划中单独设一章:AI 存储架构

不少企业的“智慧工地建设方案”厚厚一摞,但“存储”通常只是一张设备清单。建议从集团层面要求:

- 在信息化/数字化规划中,单独设置 《AI 计算与存储架构》 章节;

- 明确区分:边缘节点、项目数据中心、区域/集团数据中心,各自的 算力、存力、带宽 指标;

- 引导各区域公司在招标时,把 内存类型、存储拓扑、未来扩展能力 作为技术评分点,而不是事后“按标配配机”。

5.2 和集成商谈方案时,多问三句话

以后再听方案汇报,可以刻意问这三句:

- “这个边缘节点单机的内存带宽有多大?能支持多少路 AI 视频并发?”

- “核心服务器如果未来要扩展到 2 倍 AI 任务量,内存和存储怎么扩展?有没有用到 MRDIMM、CXL 之类的新技术路线?”

- “历史视频、BIM 模型、传感器数据将来要做 AI 训练时,有没有规划高带宽的数据湖,而不是简单堆便宜硬盘?”

你会发现,只是这三句话,就足以把很多“只会堆算力、不懂存力”的方案筛掉一大半。

5.3 把“能效”作为 AI 工地评估的硬指标

SK 海力士做定制 HBM、本质是为了在同等 AI 能力下,压低能耗和成本。智慧工地也一样:

- 不是谁的视频流多、模型多就算“更智能”;

- 而是要看每处理一小时视频、一个模型推理,系统的 能耗、带宽占用和延时 是否在可控区间。

具体可以落成几个简单指标:

- 单个工地 AI 系统的年度能耗目标;

- 每路视频 AI 处理的平均功耗上限;

- 边缘节点与云端之间的月度数据传输量控制目标。

这些指标会倒逼技术团队去思考:是不是可以在本地加一点“像 HBM 那样懂算力的存储”,而不是一味把压力推给云。

结语:智慧工地的下半场,是“算力+存力”的总分

这波由 AI 引发的存储涨价,本质是一次对基础设施认知的集体校正:原来大家都低估了“存力”的价值。

对于中国建筑企业来说,智慧工地的上半场更多是在装摄像头、上平台、做可视化;真正决定竞争力的下半场,则是:

- 谁能把 AI 做得更稳、更快、更省;

- 谁能把多项目、多年度的数据沉淀下来,为企业的组织能力和管理能力持续提供“算力燃料”。

SK 海力士给出的 HBM、AI DRAM、AI NAND 路线图不要求你成为半导体专家,但它至少说明了一件事:未来所有和 AI 有关的行业,都会按“算力+存力”一体化的标准重构基础设施。

智慧工地,正好站在这条路的入口。现在开始,把“存力升级”写进你的数字化蓝图,比两年后被动加钱买存储,要划算得多。