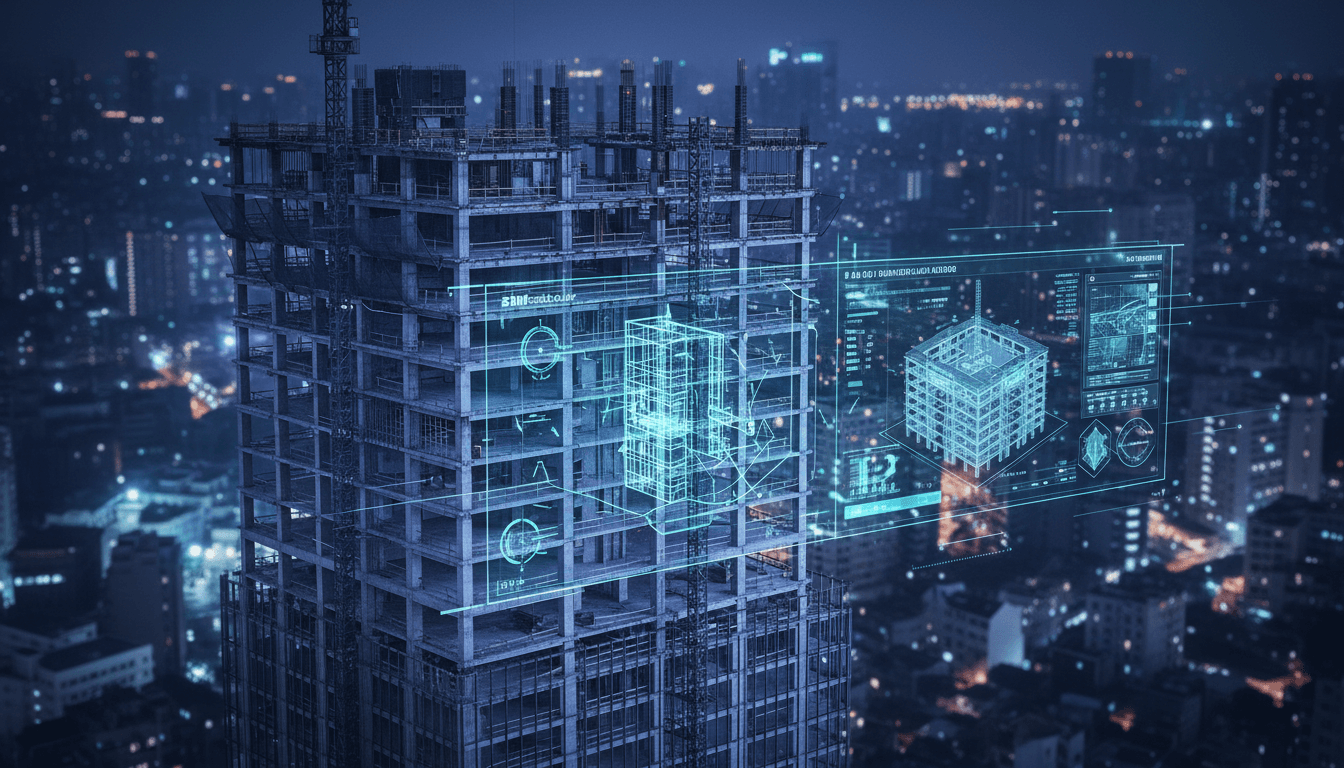

AI 已经能从一张图片生成“会动”的三维模型。建筑企业如果把这套思路引入 BIM、施工模拟和智慧工地,可以真正做出懂结构、懂工艺、懂运维的数字建筑。

从一张图到“会动”的三维模型,对建筑业意味着什么?

在很多施工现场,设计图纸改了三版,BIM 模型却还停留在第一版,施工模拟只能靠现场负责人一边比划一边讲。结果就是:设计、施工、运维各说各话,真正落地到工地上的“数字建筑”往往名不副实。

与此同时,AI 三维生成正在悄悄走到另一条极端:南洋理工大学 S-Lab 最新研究,已经可以从一张普通图片自动生成带结构、关节和纹理的可动 3D 模型——抽屉能拉开、门板能旋转,内部材质还保持真实一致。

这件事,对做游戏和虚拟内容很兴奋;但对建筑企业来说,更关键的问题是:这种“结构 + 运动 + 纹理一次到位”的能力,能不能搬到 BIM、施工模拟和智慧工地上?

下面我会先用通俗的方式讲清楚这项技术做到了什么,然后对照建筑行业的痛点,拆开讲它在智能建模、施工仿真、数字孪生和机器人施工里的潜在价值,最后给出几条实打实的落地建议。

S-Lab 做对了什么:结构、关节、纹理统一建模

先把核心结论说清楚:S-Lab 搭了一套“统一可动 3D 生成框架”,让 AI 不只会画外形,还真正理解“东西是怎么动的”。

1. 结构潜空间:AI 先学会“看懂构件和铰接”

这套方法的第一步,是给每个训练对象建立一个带关节信息的 3D 体素表示。简单理解,就是把物体切成很多小格子,每个格子不只知道“这里有没有实体”,还知道:

- 这个格子属于哪个部件(门板、抽屉、柜体…)

- 这个部件的包围盒范围

- 有没有关节、是什么类型(旋转/平移)

- 关节的轴线、转动中心

- 运动范围(转多少度、滑多少距离)

这些信息会被送入一个 3D 变分自编码器,压缩成一个紧凑、连续的“结构潜编码”。这个潜空间本身就很接近我们在 BIM 里希望拥有的“带构件语义 + 连接/约束关系”的结构模型。

换句话说,AI 不是直接在三角面片上胡乱生长,而是先学会:哪个部件连在一起、怎么转、怎么滑。

2. 扩散模型:在潜空间里“造”会动的结构

有了结构潜空间,第二步是用扩散模型在这个空间里生成新的可动结构:

- 条件可以来自一张图片,也可以只是类别标签

- 模型内部用 Transformer 去建模潜编码之间的空间依赖

- 训练完成后,它既能无条件生成多样化可动结构,也能根据单张图像生成结构、关节都匹配的 3D 对象

这一步类似“结构级别的 AI 设计师”:给它看一张柜子的照片,它不只画出外形,还会推断出哪块是门、门从哪儿转、抽屉从哪儿拉。

3. 关节感知纹理:运动后暴露的区域也要好看

第三步解决的是建筑行业也非常熟悉的难题:可见性变化。

原始的 3D 高斯解码器只在静态物体上训练,

- 门关上时看不到背面

- 抽屉没拉开时看不到内部

如果直接让它去“猜”这些区域的纹理,经常会模糊、发灰,甚至花屏。S-Lab 的做法是:

- 在每个训练物体的关节运动范围内,均匀采样多个运动状态

- 对每个状态渲染多视角图像,提取特征,与对应体素对齐

- 在微调时,让 3D 高斯点根据当前关节参数真实移动,再渲染和真实图像对比

通过这种多状态监督,模型逐渐学会:

- 哪些面在运动时会暴露

- 这些新表面的纹理应该长什么样

- 不同关节位置下,整体外观如何保持前后一致

对于建筑场景,这个机制可以直接类比到:

- 幕墙开启后看到的窗框内侧

- 活动遮阳板翻转后暴露出的背面饰面

- 可调设备(风阀、百叶、检修门)在不同开度下的可视效果

4. 实验结果关键点

论文用 Chamfer Distance、FID 等指标证明:

- 几何误差在静止和运动状态下都最低

- 部件运动过程中没有明显穿插、错位

- 运动后暴露区域纹理自然,没有突兀色块

- 在新数据集上泛化良好,说明不是“背题记答案”

更重要的是,整个推理流程从图片到可动 3D,大约二十几秒完成,这个量级已经接近工程辅助工具的可接受门槛。

对建筑业的启发:从家具到建筑构件,并不遥远

把这项研究放回到“AI 在中国建筑行业的应用:智慧工地”这条主线,它其实戳中了一个核心问题:AI 能不能真正理解“建筑构件怎么动、怎么协同”?

1. 自动生成“会动的”BIM 构件族

今天很多 BIM 构件族(族库)还是靠人工建模:

- 参数难维护

- 厂家型号更新慢

- 构造节点和真实产品有差距

如果把 S-Lab 的技术迁移到建筑:

- 输入:产品样本图片或厂家 Catalog 图片

- 输出:带参数、带开启/滑动行为的 BIM 构件

可以想象的场景包括:

- 门窗类:开启方向、合页位置、开启角度范围

- 幕墙单元:开启扇、插接件、横梁竖梃的装配关系

- 装配式构件:连接件位置、吊点布置、拼装顺序

**价值在于:**BIM 模型从“静态几何库”升级为“可动构件库”,为后续施工模拟、运维仿真打下基础。

2. 施工模拟:不仅是“走一遍流程”,而是“理解约束”

现在很多施工模拟更多是“动画”:塔吊转一圈、吊装件飘上去,看着很热闹,但对安全和工艺的真实帮助有限。

如果借鉴 S-Lab 的结构潜空间 + 关节生成思路,施工模拟可以升级为:

- 构件间的连接约束真实存在(比如:构件必须沿某条滑道移动,而不是穿墙)

- 临时支撑、脚手架、吊点这些“中间状态”也能被 AI 识别和建模

- 对异常运动(穿插、扭曲、碰撞)自动预警

在智慧工地场景下,这意味着:

- 起重机吊装路径可视化时,自动规避可动构件的运动路径

- 预制构件安装时,模拟“旋转 + 平移”的真实就位过程

- 大型设备进出场路线,考虑现场临时构筑物和可动障碍物

3. 数字孪生:运维视角下的“可交互建筑”

真正有价值的建筑数字孪生,必须支持交互:

- 机电检修门能打开,看到后面的设备

- 风阀、百叶可以调整开度,仿真实际风量

- 可变空间(折叠隔断、升降舞台)可以模拟不同使用状态

S-Lab 的“关节感知纹理 + 多状态训练”正好填了一个坑:

不同状态下暴露的区域,AI 也能给出可信的外观和结构表达。

对于智慧工地来说,这类能力可以往前延伸到施工阶段:

- 在施工数字孪生中,对尚未安装完成的构件进行状态切换(吊装中、临时固定、最终定位)

- 结合传感器数据,对可动构件状态进行实时还原和预警(如防火门长期处于敞开状态)

技术对应建筑场景:三个可落地的方向

如果你在设计院、施工总包或者建筑科技公司里做数字化,这一节可以看作是“需求转技术”的速记版。

方向一:AI 驱动的“构件结构识别 + 关节推断”

**目标:**从现场照片、供应商资料自动生成带运动逻辑的构件模型。

可行的技术路线:

- 以现有 BIM 模型为“教师”,构造带构件语义和约束的 3D 训练数据

- 采用类似 S-Lab 的体素 + 结构标签方式,对关键构件(门窗、幕墙、设备)构建“结构潜空间”

- 训练图像到结构潜编码的条件扩散模型,实现:

- 按照片快速还原构件几何和连接方式

- 对未知产品给出合理的运动假设

直接收益:

- 构件族自动扩充,减少手工建模

- 供应商产品更新时,数字模型自动同步

- 现场实景反建 BIM 时,不再只有“静态网格”

方向二:基于可动 3D 的施工安全与工艺仿真

**目标:**让施工模拟真正变成“带约束的工程推演”,而不是纯动画。

关键思路:

- 把施工过程中的临时构件、装备、支撑体系也纳入“可动结构建模”

- 对吊装、顶升、滑移、转体等工艺,定义清晰的运动关节和范围

- 利用 AI 自动检查:

- 构件之间是否存在穿插

- 设备运转时是否可能碰撞脚手、临设

- 现场人员活动空间是否被动态遮挡

配合智慧工地的实时数据(视频、物联网传感器),可以做到:

- 对比“计划运动状态”与“现场实际状态”的偏差

- 提前识别危险动作和违规操作

- 为安全员和工长提供更直观的决策支持

方向三:机器人施工与智能装备的“环境理解”

S-Lab 研究里有一块很值得建筑圈借鉴:面向机器人操作的可动 3D 生成。

在机器人施工、自动巡检、仓储物流等场景中,机器需要知道:

- 哪些东西能动、该往哪儿推、往哪儿拉

- 门是推开还是拉开,手柄在哪个高度

- 阀门是旋转操作还是按压

对应到建筑智慧工地:

- 机器人巡检:自动判断阀门、开关的位置和操作方式

- 物料配送 AGV:理解可开启门、可临时拆除围挡的运动方式

- 装配式机器人安装:识别构件的对接面与拼装顺序

S-Lab 的统一框架提供了一个模板:

用结构潜空间把“几何 + 语义 + 关节”绑定在一起,再用扩散模型在这个空间里学习各种可动物体的分布。

这一套方法,不依赖某个固定品类,完全可以扩展到门、窗、阀门、检修口等建筑构件,提升机器人对建筑环境的“可操作理解”。

落地建议:建筑企业可以从哪里开始试水?

如果你所在的团队希望把这类技术真正用在智慧工地和 BIM 协同里,我建议可以分三步走。

第一步:选好“高价值 + 运动明确”的切入构件

不要从整个建筑开始,从一个构件族切入更现实:

- 多方案比选里反复出现的门窗、幕墙系统

- 施工工艺复杂、安全要求高的构件(如大跨度幕墙开启扇)

- 运维阶段需要频繁操作或监控状态的构件(防火门、风阀)

为这类构件建立:

- 高精度 BIM 模型

- 实物照片、施工现场照片

- 清晰的关节与运动参数

这就是你自己的“小型 S-Lab 数据集”。

第二步:和现有 BIM 流程对接,而不是推翻重建

技术选型上,可以遵循两个原则:

-

结构潜空间与 BIM 属性对齐

- 把体素里的语义标签,映射到 BIM 的构件类别和参数

- 把关节、约束信息,映射到 Revit / IFC 里的连接关系

-

AI 只负责“生成候选”,最终入库仍由工程师审核

- 生成的可动 3D 构件,先进入“候选库”

- 由结构、机电、幕墙等专业工程师做一次技术审核后,再进入正式族库

这样可以在不打乱原有 BIM 体系的前提下,逐步引入 AI 生成能力。

第三步:从“看得见”过渡到“用得上”

很多单位做数字化时容易陷入一个误区:做了很炫的 3D 效果,但施工现场没人用。针对可动 3D 能力,建议至少实现三个具体场景:

-

施工交底

- 利用可动 3D 模型演示吊装、翻转、拼装的真实动作

- 替代 PPT 平面讲解,让班组长和工人能脑子里有“动态画面”

-

安全教育和复盘

- 对典型危险工序(高空吊装、临边作业)做可动仿真

- 安全事故后,用数字孪生重建运动过程,分析问题节点

-

与智慧工地平台集成

- 把可动 BIM 模型挂接到现场视频、传感器数据上

- 在平台界面中直接切换构件的不同状态,对比计划与实况

只要这三点真正落地,AI 可动 3D 的价值就不再停留在“炫技”,而是实实在在地服务工程管理。

写在最后:智慧工地需要的,是“会动的数字世界”

S-Lab 的这项研究,证明了一件事:AI 已经可以在统一框架下,同时学会几何结构、运动逻辑和外观纹理。

对于游戏和影视,这是内容生产效率的提升; 对于建筑行业,它更像是一种“数字施工逻辑”的雏形——

不只是把建筑“画出来”,而是把“它怎么运转、怎么施工、怎么维护”一起学进去。

在“AI 在中国建筑行业的应用:智慧工地”这条路线上,可动 3D 的技术会越来越像当年的 BIM:一开始被认为是“多此一举的精细建模”,最后变成没人敢忽视的基础设施。

现在是一个不错的时间点:

- 算力成本比几年前低了不少

- 工程现场的数据采集手段越来越丰富

- 各大设计院和总包都在找 AI 在 BIM 协同、施工模拟中的突破口

如果你的团队正在考虑下一阶段的数字化投入,不妨把**“可动 3D + BIM + 智慧工地”**作为一个中长期方向来规划:

先从一个小构件做起,把它变成“AI 也看得懂、也能动起来”的数字对象,这就是迈向真正空间智能工地的第一步。