起亚Vision Meta Turismo概念车透露:汽车竞争正转向AI驱动的软件与体验。看起亚、特斯拉与中国品牌的三种座舱打法。

AI驱动的智能座舱体验:从起亚概念车看软件竞争

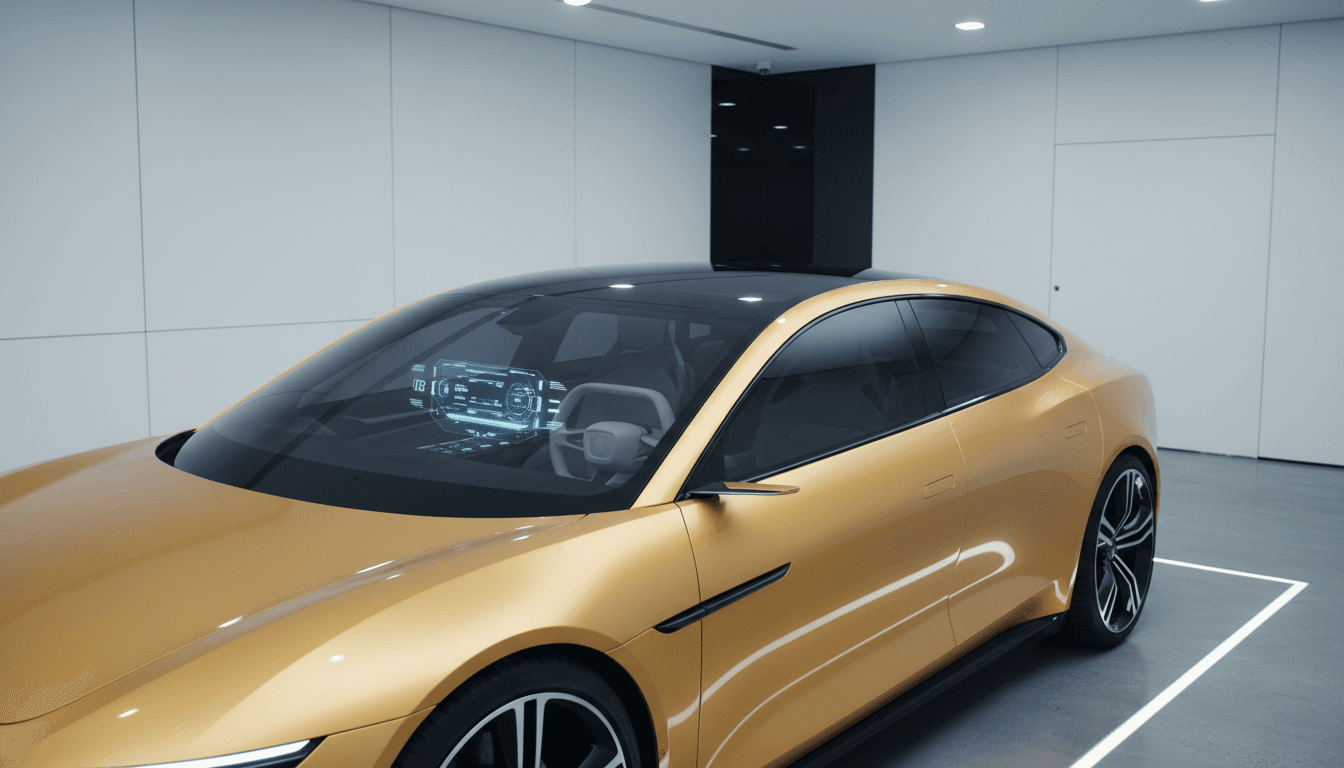

起亚在 2025-12-08 发布的 80 周年概念车 Vision Meta Turismo,最抓人的并不是“电动”这两个字,而是它像一张被软件重新定义的产品海报:没有门把手、用摄像头取代后视镜、超大玻璃顶、分体式细灯组,以及带有 yoke(半幅式)方向盘的座舱。很多人第一眼会以为这是 AI 渲染图——这恰恰说明一个现实:今天的汽车设计已经越来越像“为软件界面服务的硬件外壳”。

这篇文章放在《AI 在汽车软件与用户体验中的不同应用方式》系列里,我想用起亚这台“看起来很像概念版 EV8 GT”的车做一个切口:概念车不只是秀肌肉,它在公开试探下一代交互、下一代座舱操作系统,以及 AI 将如何介入驾驶与娱乐体验。更关键的是,起亚这种“从造型到交互一起重做”的路线,和特斯拉的“软件统一、持续迭代”路线,以及中国品牌常见的“强本地化、强生态整合”路线,正在把汽车行业带到同一个战场:体验的胜负由软件决定,AI 是加速器。

概念车最重要的价值:把“体验假设”公开化

概念车最直接的任务不是量产,而是把品牌对未来的押注讲清楚。Vision Meta Turismo 的外观极端、线条夸张、细节激进,但它真正释放的信号是:座舱与交互将被当作主产品,而不是附属配置。

从公开信息看,这台车有几个非常“软件化”的暗示:

- 摄像头替代传统后视镜:意味着显示、延迟、夜视增强、雨雾补偿、眩光抑制都将成为 UI/算法问题。

- 无门把手与极简开口:更依赖近场感知、数字钥匙、身份识别与异常状态兜底机制。

- AR HUD 抬头显示:把关键信息从“中控屏”迁移到“视线前方的空间界面”,这不是屏幕升级,而是交互范式变化。

- 三种数字驾驶模式(Speedster / Dreamer / Gamer):这类模式切换,本质是 HMI、底盘、声音、氛围灯、ADAS 策略的“场景编排”。

我更愿意把这种概念车理解为:车企把未来 3-5 年的体验路线图做成可视化样机,让用户、媒体、监管与供应链一起“预演”。预演得越真实,越能倒逼软件平台能力。

从“造型很夸张”到“交互可落地”:AI在座舱里的三类用法

把概念车的炫技拆开看,AI 在汽车软件与用户体验里通常分三层落地,层层都要“可解释、可兜底”。

1)界面层:从按钮/菜单到“意图驱动”

AR HUD、yoke 方向盘、数字模式,本质上都在减少传统菜单操作。AI 在这一层的价值不是“更聪明”,而是更少打断:

- 根据车速、道路类型、雨雪夜间等状态,动态调整 HUD 信息密度

- 通过语音与多模态(语音+视线+触控)判断驾驶意图

- 在“Dreamer/舒缓”模式下更少弹窗、更弱提示;在“Speedster/性能”模式下更强的车辆姿态与能耗反馈

一句话:AI 负责“猜你要什么”,但系统必须提供“一键返回确定性”。

2)体验层:场景编排比单点功能更重要

“Gamer 模式”这种命名很有代表性:它不是一个功能,而是一整套体验脚本。车企要做的是把音效、座椅、氛围灯、屏幕布局、甚至能量回收标定组合成一个“可感知的性格”。

我见过不少车型的问题是:功能堆得很满,但缺少场景主线,用户记不住、用不起来。概念车给了一个反方向:先定义体验人格,再倒推功能组合。

3)安全层:越“未来感”,越需要保守的安全设计

摄像头后视镜、超大玻璃、极细灯组这类设计,都会把可靠性、法规与极端场景暴露出来。评论区里也有人直言“在某些市场可能不被接受”。这不是泼冷水,而是现实:

- 摄像头链路要考虑延迟、眩光、污渍遮挡、结冰、断电降级

- AR HUD 要避免误导性叠加(比如把提示画在错误的车道/车距上)

- yoke 方向盘对低速掉头、紧急回正的适配,需要更严格的人因验证

**AI 能提升感知与决策,但汽车软件必须先证明“最坏情况也能安全”。**在 2025 年这个节点,监管对“可预期行为”的要求只会越来越强。

起亚、特斯拉、中国品牌:同一战场的三种打法

如果把“AI + 汽车软件”当成一个长期竞赛,我更倾向于这样划分三种典型策略:

起亚这类:用概念车拉动体验想象,再收敛到平台化

Vision Meta Turismo 这种“像未来设定集”的产品,优势是能快速建立心理锚点:用户会开始期待“这品牌的下一代座舱应该更沉浸、更数字化”。当它最终收敛到量产(例如外界推测的 EV8/旗舰 GT),很多大胆元素会被砍掉,但交互主线会保留:更强 HUD、更强模式编排、更强视觉一致性。

特斯拉:统一软件栈 + 持续迭代,把体验做成“版本号”

特斯拉的强项从来不是概念车,而是把车当作“可持续更新的产品”。它依靠统一的软硬件架构,让驾驶辅助、能耗策略、UI 动效在大规模车辆上快速迭代。用户体验因此更一致,学习成本更低。

代价也明显:统一就意味着取舍。当你需要深度本地化(地图、语音、生态、内容合规)时,统一策略会遇到更复杂的适配成本。

中国品牌:本地化与生态整合更快,但要警惕“体验碎片化”

中国市场的智能座舱竞争更像手机行业:语音助手、车家互联、内容平台、支付与会员体系、地图与停车服务,全部要打通。优势是落地快、贴合本地使用场景;挑战是多供应商、多 App、多入口容易造成割裂。

我给很多团队的建议很直白:**别让“集成能力”掩盖了“体验一致性”的欠账。**AI 能做智能推荐,但不能替代产品层面的信息架构和交互秩序。

2026年前后的现实问题:用户要的不是“更多屏”,而是“更少麻烦”

年底是汽车营销最密集的节点,大家都在讲“智能化”“大屏”“沉浸”。但用户在意的往往更朴素:别卡、别吵、别误报、别找不到。

把 Vision Meta Turismo 的概念落到可交付的软件体验,我认为 2026 年最值得押注的三个方向是:

- AI 驾驶辅助的“沟通能力”:不仅要做得对,还要让用户知道它为什么这么做,什么时候会退出。

- 座舱场景的“少打断设计”:通知、弹窗、语音打断要有优先级与驾驶负荷判断。

- 跨设备一致性:车机、手机、手表、家庭设备的账号与状态同步,决定了“智能”是否真的省事。

一句更尖锐的话:未来的豪华感,会从真皮和镀铬转移到“系统的克制”。

把概念车变成可复制的体验:产品团队可以怎么做

如果你正在做智能座舱、车载 OS、语音助手或 AR HUD,概念车给的启发不是“做得更炫”,而是“把体验变成可验证的指标”。我常用的一套落地清单是:

- 定义 3 个核心场景:通勤、长途、夜间/雨雪;每个场景只保留 5 个最高频任务

- 为每个任务设定 KPI:完成时间、误触率、回退次数、语音识别纠错次数

- 把 AI 放在“减少步骤”而不是“增加功能”上:能自动完成的就别让用户点三次

- 设计明确降级策略:网络断开、摄像头污损、传感器异常时,UI 怎么提示、功能怎么退回

当这些东西能在一辆“概念很强”的车上跑通,量产车才有机会把体验复制到更大的用户规模。

概念车展示的是想象力;量产车考验的是软件工程与体验纪律。

年末看起亚 80 周年这台 Vision Meta Turismo,我反而更期待的是它“炫技背后的收敛”:哪些交互会留下,哪些会变成下一代座舱的默认配置。

如果你也在关注 AI 在汽车软件与用户体验中的不同应用方式,不妨把问题换个问法:**当硬件越来越像模板,品牌还剩下什么?**我的答案是:剩下的就是软件平台能力,以及把 AI 用在“让用户少操心”的那部分能力。