Seguridad de IA para minería y energía en Chile: qué enseña la compra de Chatterbox Labs por Red Hat y cómo aplicarlo con métricas y guardrails.

Seguridad de IA en minería y energía: lecciones de Red Hat

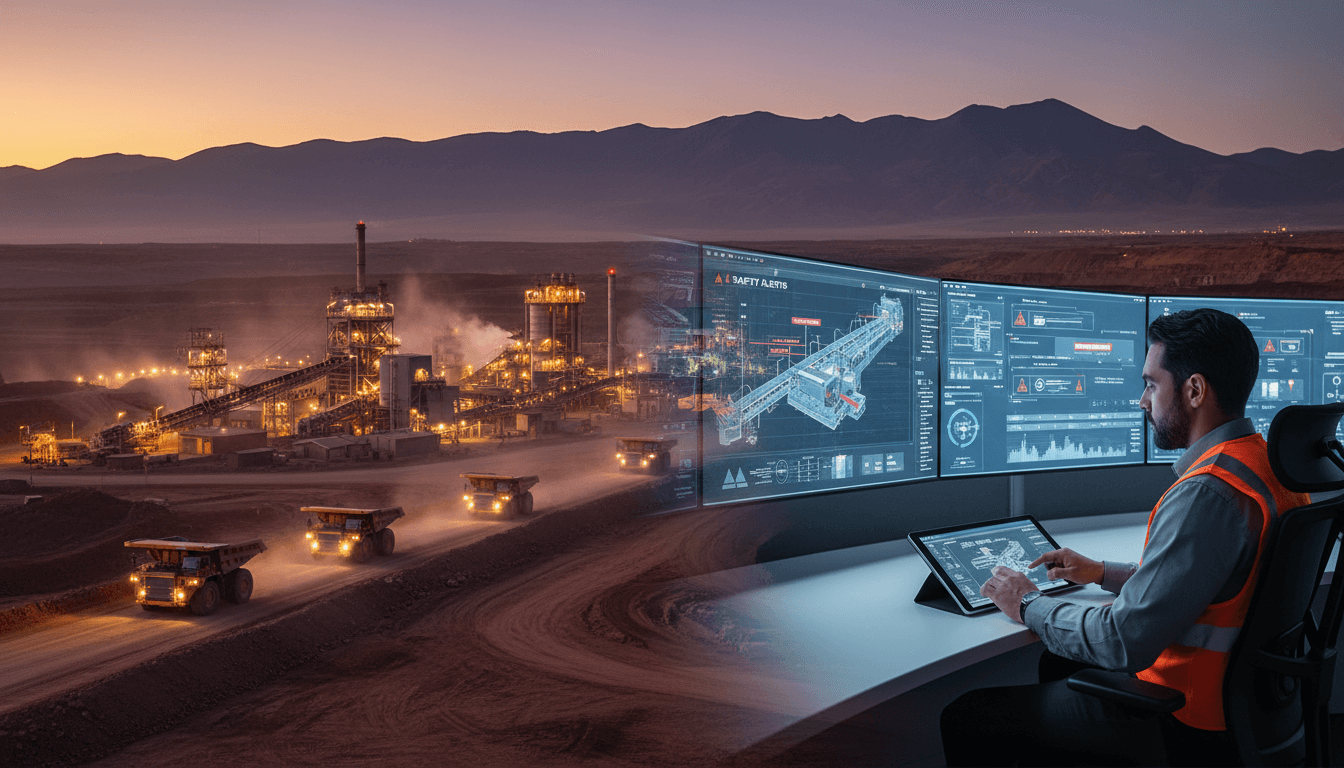

En operaciones mineras y energéticas en Chile, la conversación sobre inteligencia artificial ya no es “si la usamos” sino cómo la ponemos en producción sin abrir una puerta nueva al riesgo. Cuando un modelo empieza a tomar decisiones o a recomendar acciones en terreno —desde mantenimiento predictivo hasta despacho de energía—, la seguridad deja de ser un asunto “del equipo TI” y se vuelve continuidad operacional.

Por eso vale la pena mirar lo que ocurrió el 18/12/2025: Red Hat adquirió Chatterbox Labs para incorporar pruebas de seguridad y guardrails (medidas de protección) directamente en su oferta de Red Hat AI. No es una noticia “de proveedores”; es una señal del mercado: la IA está pasando del piloto a producción, y la seguridad es el freno de mano que evita accidentes.

En esta entrega de la serie “Cómo la IA Está Transformando el Sector Minero y Energético en Chile”, aterrizo qué significa “seguridad para IA”, por qué importa más en sectores críticos, y cómo traducirlo a un plan práctico para faenas y activos energéticos.

Por qué la “seguridad para IA” ya es un tema de gerencia

La seguridad para IA es la disciplina que asegura que los modelos sean verificables, confiables y controlables antes y después del despliegue. Incluye pruebas, métricas de riesgo y barreras técnicas para reducir conductas no deseadas del modelo.

En minería y energía el impacto de un error es más caro que en otros rubros. No se trata solo de “una mala respuesta” en un chatbot:

- En minería, una recomendación equivocada puede traducirse en paradas no planificadas, daños a equipos de alto costo o decisiones de operación inseguras.

- En energía, una predicción sesgada o frágil puede afectar balance, despacho, compras en mercado spot o gestión de activos críticos.

He visto que muchas organizaciones en Chile avanzan rápido con IA (especialmente analítica avanzada y gen AI para soporte y documentación), pero subestiman lo que ocurre cuando el modelo se integra a procesos reales: se conecta a datos, se automatizan tickets, se sugieren acciones, se aprueban órdenes, se ajustan parámetros. Ahí el riesgo cambia de naturaleza.

La adquisición de Chatterbox Labs es un síntoma claro: los grandes proveedores están metiendo seguridad “en la plataforma”, no como parche. Eso es exactamente lo que necesitan los sectores críticos.

Qué aporta el enfoque Red Hat + Chatterbox Labs (y por qué es relevante)

La idea central es simple: si la IA va a producción, debe pasar por pruebas medibles y tener protecciones activas. Según lo comunicado, Chatterbox Labs aporta capacidades agnósticas al modelo (es decir, no dependen de un solo LLM) y orientadas a MLOps.

Métricas de riesgo: pasar del “me tinca” al “lo puedo justificar”

En directorios y comités de riesgo, la IA suele trabarse por una razón: no hay un lenguaje común para aprobarla. Se habla de precisión o de “buenas respuestas”, pero falta cuantificar riesgos: toxicidad, sesgo, robustez, fuga de información, comportamiento ante prompts adversarios.

Chatterbox Labs empuja justo esa línea con su enfoque AIMI:

- AIMI para gen AI: métricas cuantitativas independientes para LLMs.

- AIMI para IA predictiva: validación en pilares como robustez, imparcialidad y explicabilidad.

Para minería y energía esto se traduce en algo muy concreto: un modelo no se aprueba por entusiasmo, se aprueba porque cumple umbrales de riesgo definidos, igual que cualquier cambio operacional.

Guardrails: la barrera que separa “asistente útil” de “incidente”

Los guardrails son controles que detectan y corrigen indicaciones inseguras, tóxicas o sesgadas antes de poner el modelo en producción, y también pueden aplicarse durante la operación.

En sectores críticos, los guardrails no son un “extra”. Son una condición mínima, por ejemplo:

- Bloquear solicitudes que intenten obtener información sensible (planos, credenciales, rutas de transporte, inventarios críticos).

- Evitar que un asistente entregue instrucciones operativas fuera de procedimiento.

- Controlar que el modelo cite la fuente interna correcta (manuales, estándares, instructivos vigentes) en lugar de “inventar”.

IA agéntica y MCP: cuando la IA no solo responde, actúa

La nota también menciona el avance hacia IA agéntica y el Protocolo de Contexto de Modelo (MCP). La diferencia es clave:

- Un chatbot responde.

- Un agente puede encadenar tareas, consultar sistemas, generar tickets, ejecutar flujos y gatillar acciones.

En minería y energía, esto es tentador (y útil) para automatizar backoffice y soporte a operaciones, pero también aumenta el riesgo: un agente mal controlado puede ejecutar acciones no autorizadas.

Por eso es relevante que Chatterbox Labs investigue monitoreo de respuestas de agentes y detección de activadores de acción en servidor. Traducido a lenguaje de faena: no basta con “que hable bien”; debe “portarse bien” bajo presión y con controles.

Casos de uso en Chile: dónde se nota más la seguridad de IA

La seguridad se vuelve crítica en tres familias de casos de uso: operación, mantenimiento y gestión del conocimiento. Aquí van ejemplos típicos y qué controles conviene exigir.

1) Mantenimiento predictivo y confiabilidad de activos

En minería (chancado, molienda, correas, bombas) y energía (turbinas, subestaciones, inversores), la IA predictiva promete reducir fallas. El riesgo aparece cuando:

- cambian condiciones de operación (derivas),

- los datos tienen calidad irregular,

- o el modelo es una “caja negra” sin explicación operativa.

Controles prácticos que funcionan:

- Pruebas de robustez: ¿cómo se comporta el modelo con ruido, datos faltantes o sensores descalibrados?

- Explicabilidad operativa: no para “cumplir”, sino para que mantenimiento confíe y actúe.

- Monitoreo continuo: umbrales de alerta por deriva del modelo y degradación de performance.

2) Gen AI para procedimientos, seguridad y capacitación

Muchas empresas están usando IA generativa para resumir incidentes, redactar reportes, apoyar a cuadrillas con documentación o acelerar onboarding. El riesgo más común: alucinaciones (respuestas inventadas) y filtración de información.

Controles recomendados:

- Guardrails de contenido + políticas de datos (qué puede ver y qué no).

- Respuestas con citas internas: “esto viene del procedimiento X, versión Y”.

- Registro y auditoría: quién preguntó, qué respondió, qué fuente usó.

3) Agentes para mesa de ayuda, abastecimiento y operaciones

Los agentes pueden automatizar solicitudes repetitivas: crear tickets, buscar repuestos, levantar compras, coordinar agendas. Pero en sectores críticos el principio es uno:

Si un agente puede ejecutar, entonces debe autenticarse, autorizarse y auditarse como cualquier usuario privilegiado.

Controles mínimos:

- Permisos por rol (RBAC) y aprobación humana para acciones de alto impacto.

- Separación de ambientes (desarrollo/pruebas/producción) y cambios trazables.

- Simulaciones de ataque con prompts adversarios antes del go-live.

Checklist práctico: cómo poner IA “lista para producción” en sectores críticos

Si tuviera que resumir la lección del movimiento de Red Hat en un plan aplicable en Chile, sería este: seguridad y MLOps deben nacer juntos. No se agregan al final.

1) Definan un “caso de uso aprobable” (y maten el resto)

Antes del modelo, definan:

- propósito exacto,

- usuarios,

- sistemas a los que se conecta,

- y qué decisión influye.

Un buen filtro: si no puedes explicar el impacto operacional en dos minutos, todavía no está listo.

2) Midan riesgo con métricas, no con opiniones

Adopten métricas repetibles:

- robustez,

- sesgo/imparcialidad,

- explicabilidad,

- seguridad ante prompts maliciosos,

- fuga de datos.

Esto acerca el proyecto al lenguaje de auditoría, compliance y continuidad.

3) Instalen guardrails desde el primer piloto

No esperen a “la versión 2”. En el piloto se entrenan hábitos y se validan límites. Guardrails útiles desde el día uno:

- filtros de PII y secretos,

- listas de temas prohibidos,

- validación de fuentes internas,

- tono y formato obligatorio para respuestas críticas.

4) Operen el modelo como un sistema vivo

Producción no es “lo publicamos y listo”. Es:

- monitoreo,

- reentrenamiento o recalibración,

- gestión de incidentes,

- y rollback.

En minería y energía, esta disciplina se parece más a operar una planta que a “subir una app”.

5) Gobierno: quién responde cuando la IA se equivoca

Definan responsable y proceso:

- dueño del modelo,

- dueño del dato,

- responsable operacional,

- comité de cambios,

- criterios de detención.

Cuando hay incidente, la peor respuesta es “nadie sabe de quién era”.

Preguntas que suelen salir (y respuestas directas)

¿La seguridad de IA aplica solo a IA generativa?

No. Aplica a gen AI, IA predictiva y agentes. En predictiva, el riesgo suele ser robustez y deriva; en gen AI, alucinación y filtración; en agentes, ejecución no autorizada.

¿Qué es más importante: precisión del modelo o seguridad?

En sectores críticos, la seguridad manda. Un modelo 2% más preciso pero sin controles puede aumentar el riesgo total del sistema. La meta es precisión suficiente + comportamiento controlado.

¿Se puede hacer IA segura en nube híbrida?

Sí, y de hecho es el escenario típico en minería y energía: datos on-premise, aplicaciones en nube, y requerimientos regulatorios internos. El punto es diseñar con políticas de acceso, auditoría y segmentación desde el inicio.

Lo que esta noticia anticipa para 2026 en Chile

La compra de Chatterbox Labs por Red Hat es una apuesta a que la seguridad será un diferenciador real en plataformas de IA empresariales. Para minería y energía en Chile, la señal es clara: el valor de la IA no está solo en automatizar, sino en hacerlo con controles que aguanten auditoría, incidentes y operación 24/7.

Si tu organización está en modo piloto, mi recomendación es tajante: usen 2026 para profesionalizar MLOps y seguridad de IA antes de escalar. El costo de hacerlo “después” suele ser doble: reputacional y operacional.

¿El próximo paso? Identificar un caso de uso con impacto (mantenimiento, seguridad operacional, gestión documental), definir métricas de riesgo y diseñar guardrails desde el inicio. Si esa base queda bien hecha, la IA realmente se convierte en un activo que crece, no en un experimento que asusta.