L’IA est un outil de productivité, pas un remplaçant. Voici comment elle transforme les métiers tech et renforce la cybersécurité, avec un plan d’action 2026.

IA, métiers et cybersécurité : l’outil, pas le remplaçant

En 2025, une peur revient en boucle dans les équipes tech : « l’IA va remplacer les développeurs ». Ce qui inquiète vraiment, ce n’est pas seulement l’automatisation, c’est la sensation de voir le marché bouger plus vite que nos plans de carrière. Et quand on lit que l’emploi en programmation a chuté à un niveau historiquement bas (avec des comparaisons aux années 1980 dans plusieurs analyses sectorielles), le doute s’installe.

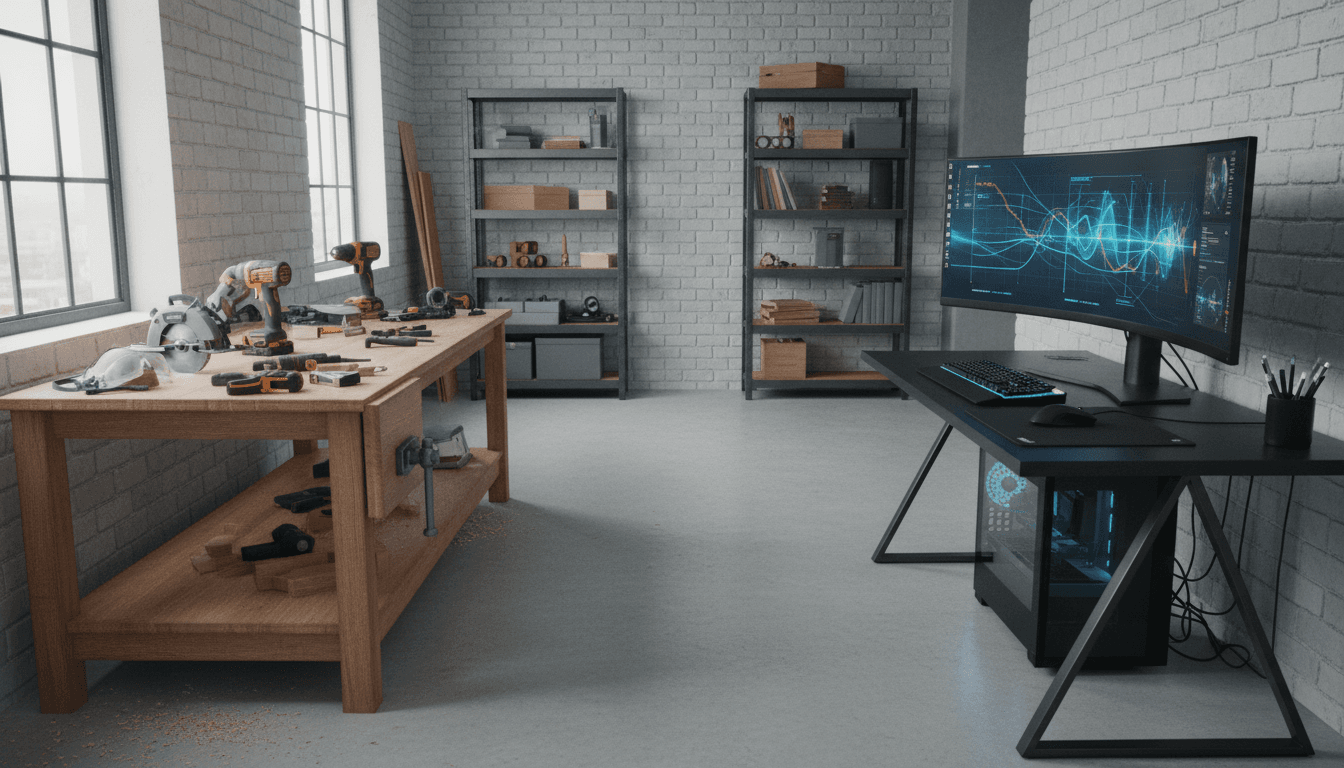

Je prends une position claire : l’IA ne supprime pas le travail, elle déplace la valeur. Comme l’arrivée des machines à coudre et des outils électroportatifs, les outils de code assisté (agents, copilotes, « vibe coding ») font gagner du temps… mais exigent davantage de méthode, de contrôle et de responsabilité. Et ce raisonnement s’applique encore plus fort à la cybersécurité, où la qualité du travail se mesure en incidents évités, pas en lignes de code produites.

Ce billet s’inscrit dans notre série « Jobs, Remote Work & the Labour Market » : on parle moins de fantasmes et plus de compétences qui paient, de rôles qui émergent, et de ce que vous pouvez faire dès maintenant pour rester employable (voire devenir plus rare) dans un marché sous tension.

L’IA, c’est l’outil électroportatif du travail numérique

Réponse directe : l’IA augmente la productivité sur les tâches répétables, mais rend le pilotage humain plus important.

L’analogie « outils électroportatifs » est utile parce qu’elle casse deux mythes :

- Mythe 1 : « Dès qu’un outil arrive, le métier disparaît. » Dans l’artisanat comme dans l’industrie, les métiers changent, se spécialisent et se hiérarchisent.

- Mythe 2 : « L’outil fait le travail tout seul. » Un outil puissant sans contrôle produit surtout… des dégâts plus vite.

En développement logiciel, les agents IA savent produire beaucoup de code en peu de temps. Mais la vitesse n’est pas la qualité. Plus vous générez, plus vous devez :

- définir le besoin (spécifications, contraintes, risques),

- vérifier (tests, revues, validation métier),

- sécuriser (dépendances, secrets, permissions),

- maintenir (lisibilité, cohérence, documentation).

Phrase à retenir : l’IA accélère l’exécution ; l’humain reste responsable de l’intention et des conséquences.

Pourquoi ça ressemble plus à une scie circulaire qu’à un « no-code »

Les outils « no-code/low-code » ressemblent souvent à des kits : rapides pour certains usages, limités dès qu’on sort du cadre. Les agents IA, eux, sont plus proches d’une scie circulaire : plus polyvalents, mais plus risqués si on ne sait pas s’en servir.

Et cette distinction est centrale en cybersécurité : un outil qui automatise sans garde-fous augmente la surface d’erreur (mauvaise règle de pare-feu, exception trop large, faux négatifs, dépendance vulnérable, etc.).

Le marché de l’emploi change : moins de « codeurs », plus de métiers hybrides

Réponse directe : les postes se déplacent vers le contrôle qualité, la sécurité, l’intégration et l’orchestration des outils IA.

Quand la production de code devient moins chère, la valeur se déplace vers ce qui évite les retours en arrière : tests, architecture, observabilité, conformité, sécurité, gestion du risque.

Dans les entreprises, on voit déjà (et on verra davantage en 2026) une séparation plus nette entre :

- Production (générer, assembler, intégrer vite)

- Assurance (tester, auditer, sécuriser, prouver)

Les rôles qui montent (et pourquoi)

Voici les rôles qui gagnent mécaniquement en importance quand l’IA produit plus de code et plus vite :

- Test/QA augmenté par l’IA : conception de tests, stratégie de couverture, tests de non-régression, tests de sécurité.

- Référent sécurité applicative (AppSec) : revue des dépendances, durcissement, modélisation des menaces, exigences de sécurité.

- « AI wrangler » / pilote d’agents : rédaction de prompts opérables, découpage en tâches, vérification des sorties, gestion des échecs.

- Ingénieur intégration/plateforme (DevOps/Platform) : pipelines, politiques, contrôles automatiques, traçabilité.

- Analyste SOC augmenté : triage plus rapide, corrélation d’alertes, investigation assistée.

Le point commun : ces métiers existent pour réduire le risque créé par la vitesse.

Remote work : l’effet secondaire à ne pas rater

Le travail à distance amplifie cette transformation. Les organisations veulent :

- des livraisons rapides, mesurables, traçables,

- des standards partagés (tests, sécurité, documentation),

- des outils qui réduisent la friction entre équipes distribuées.

Résultat : les profils capables de mettre de l’ordre (qualité, sécurité, process) prennent de la valeur dans un marché où la production brute se commoditise.

En cybersécurité, l’IA rend les défenseurs plus forts… et les attaquants aussi

Réponse directe : l’IA est un multiplicateur de force, donc la compétence clé devient la maîtrise du risque.

Le parallèle avec le développement est immédiat : si l’IA est un outil électroportatif, elle augmente la capacité de production des deux côtés.

Ce que l’IA fait très bien côté défense

Dans une stratégie cyber réaliste, l’IA aide surtout sur :

- Détection : corréler des signaux faibles (authentifications, EDR, proxies, DNS) et prioriser.

- Triage : résumer une alerte, proposer une hypothèse, rassembler des preuves.

- Réponse : générer des playbooks, proposer des mesures de confinement, accélérer les tâches répétitives.

- Fraude : repérer des schémas anormaux, scorer des transactions, enrichir des alertes.

Mais attention : une IA qui « hallucine » dans un SOC peut faire perdre des heures. Une IA qui propose une mauvaise règle de filtrage peut créer une fenêtre d’attaque.

Ce que l’IA change dans les compétences attendues

La question n’est plus « sais-tu écrire un script ? », mais :

- sais-tu valider un script généré ?

- sais-tu écrire des tests et des contrôles ?

- sais-tu modéliser une menace et vérifier que la mitigation est réelle ?

- sais-tu documenter et rendre la décision auditables ?

One-liner : en cybersécurité, la productivité sans preuve, c’est du bruit.

Mode d’emploi : utiliser l’IA sans dégrader la qualité (ni la sécurité)

Réponse directe : imposez un cadre de vérification systématique, comme on met un carter et des lunettes sur une machine.

J’ai constaté que les équipes qui réussissent avec l’IA ne sont pas celles qui « génèrent tout », mais celles qui mettent des rails. Voici un cadre simple, applicable en dev comme en cyber.

1) Définir un « contrat » de sortie

Avant de demander du code ou une analyse :

- format attendu (fichiers, fonctions, pseudo-code, rapport),

- contraintes (versions, dépendances autorisées, performance),

- exigences de sécurité (auth, logs, erreurs, permissions),

- critères d’acceptation.

C’est le substitut moderne du cahier des charges — indispensable quand la production est instantanée.

2) Tester plus que vous ne le faisiez avant

Avec du code généré, la dette se déplace vers le test. Une checklist efficace :

- tests unitaires sur les cas « normaux »

- tests sur les cas limites

- tests de non-régression

- tests de sécurité (entrées malformées, injections, droits)

Si vous ne savez pas quoi tester, demandez à l’IA… mais gardez la main sur la sélection.

3) Sécuriser la chaîne, pas seulement le code

En entreprise (et encore plus en télétravail), ce qui protège, c’est la chaîne complète :

- analyse de dépendances et politique d’approbation

- scan de secrets et gestion des variables sensibles

- revues obligatoires sur les modules critiques

- journalisation et alerting (observabilité)

Le but : rendre l’erreur difficile, pas seulement la corriger après coup.

4) Créer un rôle explicite de « responsable de sortie IA »

Appelez-le comme vous voulez, mais nommez-le. Quelqu’un doit :

- valider les décisions,

- documenter les hypothèses,

- trancher quand l’IA est incertaine,

- refuser une sortie « pas prouvée ».

C’est exactement ce qui se passe avec un atelier : l’outil est partagé, la responsabilité est claire.

Questions fréquentes (format utile pour vos décisions carrière)

Est-ce que je dois encore apprendre à coder en 2026 ?

Oui, mais différemment. Vous n’avez pas besoin de mémoriser tout, vous avez besoin de : lire du code, le critiquer, le tester, et comprendre ses impacts sécurité.

Quel est le meilleur pari pour rester employable ?

Choisissez une compétence qui « tient » quand la production s’accélère : tests, AppSec, architecture, réponse à incident, gouvernance des données, plateforme.

Est-ce que l’IA va remplacer les analystes cyber ?

Non. Elle va réduire le temps passé sur le triage basique et augmenter l’exigence sur l’investigation, la stratégie et la preuve.

Ce que je recommande pour 2026 : une stratégie de carrière en 3 blocs

Réponse directe : spécialisez-vous sur la preuve, l’impact, et l’automatisation contrôlée.

- Bloc “preuve” : tests, validation, audit, traçabilité (ce qui résiste aux effets de mode).

- Bloc “impact” : savoir relier une action technique à un risque business (fraude, indisponibilité, conformité).

- Bloc “automatisation” : utiliser l’IA comme outil, avec des garde-fous (pipelines, politiques, revues).

Si vous cherchez une trajectoire claire : viser un profil AppSec + automatisation ou SOC + investigation + IA est aujourd’hui un choix très rationnel.

La suite logique : faire de l’IA un outil de cybersécurité, pas un pari aveugle

Le débat « l’IA remplace-t-elle les métiers ? » rate souvent l’essentiel : elle remplace surtout les tâches mal cadrées. Les professionnels qui s’en sortent sont ceux qui construisent des systèmes où la production rapide est compensée par des contrôles rapides.

Si vous recrutez, si vous requalifiez des équipes, ou si vous cherchez votre prochain poste (y compris en remote), posez une question simple : où est la responsabilité humaine, et comment est-elle outillée ?

Vous voulez passer d’une adoption “à l’instinct” à une adoption qui génère de la confiance (et des résultats) ? Qu’est-ce qui vous bloque aujourd’hui : le manque de compétences, l’absence de process, ou la difficulté à mesurer le gain réel en sécurité ?