Un four connecté briqué par mise à jour : banal ? Pas en agro. Leçons concrètes pour fiabiliser l’IA agricole, éviter les incidents et recruter les bons profils.

Quand une mise à jour bloque un four : alerte IA agro

Le 28/07/2025, environ 145 fours connectés se sont transformés en presse-papiers high-tech après une mise à jour de firmware : écran noir, interface figée, appareil muet. La “solution” proposée aux utilisateurs ressemblait à une blague… sauf que non : papier aluminium + ruban adhésif pour simuler un doigt sur l’écran et empêcher l’appareil de se mettre en veille pendant une mise à jour nocturne de 1h à 4h.

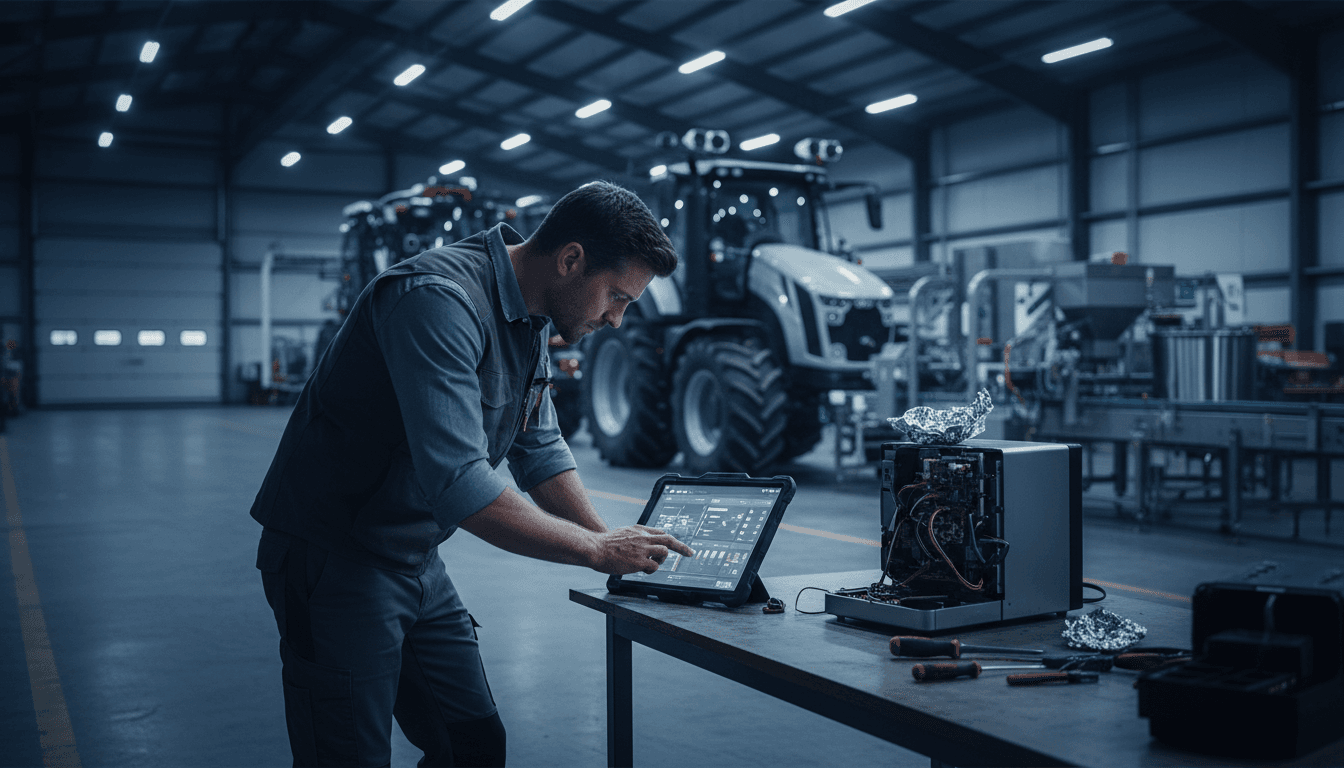

Dans une cuisine, c’est rageant. Dans une exploitation agricole ou une usine agroalimentaire, ce genre d’échec logiciel peut devenir un incident opérationnel majeur : arrêt de chaîne, perte de lots, dérive qualité, gaspillage, et parfois risque sécurité. Et comme on parle beaucoup d’intelligence artificielle dans l’agriculture et l’agroalimentaire, cette histoire est un rappel utile : la performance d’un modèle IA ne sert à rien si le système qui le met en production n’est pas fiable.

Cette publication s’inscrit dans notre série « Jobs, Remote Work & the Labour Market » : parce que derrière un “four briqué”, il y a aussi un sujet d’emplois et de compétences (SRE/DevOps, QA, cybersécurité, data/ML ops), et une réalité très concrète du travail moderne : des équipes support qui gèrent une crise en multi-fuseaux… souvent en partie à distance.

Ce que l’incident du four connecté révèle (et pourquoi l’agro doit écouter)

Un objet connecté qui se bloque après une mise à jour, ce n’est pas un fait divers : c’est un signal faible sur la maturité industrielle du logiciel embarqué.

Dans le cas du four, plusieurs éléments sont particulièrement parlants :

- Mise à jour automatique pendant la nuit, sans interaction.

- Fenêtre de mise à jour longue (environ 3 heures) alors que l’appareil s’endort au bout d’environ 20 minutes.

- Récupération dépendante d’un contournement physique (maintenir l’écran “actif”).

Transposé à l’agriculture : remplacez le four par un pulvérisateur guidé, un système d’irrigation piloté par IA, une station météo connectée, un robot de désherbage, ou un superviseur de ligne en agroalimentaire. Un blocage logiciel peut alors provoquer :

- des fenêtres agronomiques ratées (traitement trop tard, irrigation décalée),

- des pertes de production (arrêt, redémarrage, recalibrage),

- une dérive qualité (température, humidité, temps de process),

- du surcoût main-d’œuvre (interventions, astreintes),

- et une perte de confiance qui tue l’adoption.

Une phrase qui résume bien : en agriculture, la fiabilité logicielle est devenue une composante de la sécurité alimentaire.

Fiabilité IA en agriculture : le sujet n°1, avant la précision

La promesse de l’IA agricole est séduisante : meilleure précision, réduction des intrants, anticipation des maladies, optimisation énergétique. Mais sur le terrain, je vois souvent la même erreur : on surinvestit dans la “brique IA” (modèle, capteurs, dashboards) et on sous-estime l’ingénierie qui garantit que ça marche tous les jours.

IA ≠ produit fiable : la pile complète compte

Un système IA agro, ce n’est pas seulement un modèle. C’est une chaîne :

- Capteurs & données (qualité, dérive, intermittence réseau)

- Edge computing / passerelles (latence, mises à jour, compatibilité)

- Logiciel embarqué (firmware, drivers, UI, sécurité)

- Backend & API (orchestration, quotas, incidents)

- MLOps (déploiement, monitoring, rollback)

- Support & opérations (runbooks, astreinte, pièces)

Le four qui s’endort pendant sa mise à jour illustre un principe simple : si le système d’exploitation du produit n’est pas conçu pour des mises à jour robustes, le modèle IA ne compensera rien.

“Briquer” une machine agricole, c’est une autre échelle de risque

Un four bloqué, c’est quelques repas contrariés.

Un équipement agro bloqué peut coûter :

- des heures de fenêtre météo perdues,

- une immobilisation d’équipe,

- des tonnes de matière non conformes,

- un incident HSE si des sécurités dépendent de l’interface.

La barre de fiabilité attendue est donc plus proche de l’automobile, du médical ou de l’industriel que de l’électronique grand public.

Les garde-fous à exiger pour des systèmes IA “anti-crise”

La bonne nouvelle : les solutions sont connues. La mauvaise : elles demandent de la rigueur, du temps, et des compétences rares.

1) Une stratégie de mise à jour conçue pour l’échec

Le point clé est contre-intuitif : on ne conçoit pas une mise à jour pour qu’elle réussisse, on la conçoit pour qu’elle échoue sans casse.

Checklist à exiger (ou à implémenter) sur tout matériel connecté agricole/agro :

- Double partition (A/B) : si la nouvelle version échoue, retour automatique.

- Rollback en un clic côté fleet management.

- Téléchargement + installation découplés (ne pas dépendre d’une fenêtre unique).

- Mode “ne pas dormir” pendant update, géré nativement, pas par bricolage.

- Déploiement progressif : 1%, 5%, 20%, puis généralisation.

2) Observabilité : voir venir avant que ça casse

Un “écran noir” est la fin du film. L’observabilité, c’est le début : logs, métriques, traces.

En agro, on vise au minimum :

- taux d’échec de mise à jour par version,

- temps moyen de mise à jour (et dispersion),

- taux de réveil/veille anormal,

- qualité réseau (RSSI, pertes, latence),

- alertes de dérive de capteurs.

Quand ces signaux sont instrumentés, on peut stopper un déploiement avant de toucher 145 appareils… ou 145 robots.

3) Tests réalistes : l’ennemi, c’est le “terrain”

La compatibilité en conditions réelles est la principale cause d’incidents : variations réseau, coupures électriques, humidité, opérateurs pressés.

Bonnes pratiques :

- tests de coupure (power loss) au milieu d’une mise à jour,

- tests de réseau dégradé (2G/4G saturée, Wi‑Fi faible),

- tests sur parcs hétérogènes (versions hardware, lots, capteurs),

- tests en horaires réels (nuit, week-end) parce que c’est là que les automations tournent.

4) Procédures de récupération claires (et dignes)

Le papier aluminium marche peut-être, mais il détruit la confiance.

Pour l’agro, il faut des runbooks qui tiennent en une page, avec :

- étapes numérotées,

- critères de réussite/échec,

- estimation du temps,

- plan B (hotline, remplacement, intervention),

- et un mode “dégradé” permettant de continuer à produire.

Une règle simple : si la récupération exige une astuce physique, le produit n’est pas prêt pour une exploitation critique.

Marché du travail : les métiers qui deviennent indispensables

Cet incident illustre une tension forte sur le marché : on manque de profils capables de rendre des systèmes connectés fiables à grande échelle. Dans l’agritech et l’agroalimentaire, les recrutements bougent.

Les rôles les plus demandés (et pourquoi)

- SRE / DevOps : fiabilité, déploiements progressifs, gestion d’incidents, astreinte.

- Ingénieur QA / test embarqué : scénarios de test “sales”, automatisation, bancs hardware.

- Ingénieur firmware / systèmes embarqués : boot, partitions A/B, gestion d’énergie, drivers.

- Ingénieur MLOps : mise en production des modèles, monitoring, versioning, rollback.

- Cybersécurité IoT : mises à jour signées, chaîne de confiance, durcissement.

Remote work : oui, mais pas sans “terrain”

Dans ces métiers, le télétravail est souvent possible sur la partie logicielle. Mais la différence se fait sur la capacité à reproduire le réel : accès à un lab hardware, bancs de test, parc d’équipements, et retours structurés des sites.

Les organisations qui s’en sortent le mieux combinent :

- une équipe produit/engineering en mode hybride,

- des référents terrain (maintenance, méthodes, agronomes),

- et des processus d’escalade simples.

Questions fréquentes (celles que vos équipes vont poser)

Qui est responsable quand un système IA “plante” : l’IA ou le logiciel ?

Responsable opérationnellement, c’est le système complet. En termes d’action, on traite d’abord la fiabilité (mise à jour, monitoring, rollback), puis la performance IA.

Peut-on éviter les mises à jour automatiques en production agricole ?

On peut les éviter, mais on perd sécurité et améliorations. Le compromis viable est : mises à jour contrôlées, déploiement progressif, fenêtres validées avec les opérations, et possibilité de revenir en arrière.

Qu’exiger d’un fournisseur d’IA/IoT agricole avant de signer ?

Exigez noir sur blanc : stratégie de rollback, SLA support, procédure d’incident, preuves de tests de coupure, et gouvernance de déploiement (pilot → généralisation).

Transformer l’IA agro en avantage, pas en risque

Le message de cet épisode est clair : la fiabilité logicielle est une compétence agricole au même titre que la mécanique ou l’agronomie, parce que la production dépend de plus en plus de systèmes numériques.

Si vous déployez (ou envisagez de déployer) de l’IA en agriculture et agroalimentaire, ne vous contentez pas d’une démo. Demandez comment le système se met à jour, comment il revient en arrière, comment il se surveille, comment il se répare. C’est souvent là que se joue le ROI… et la tranquillité des équipes.

Si vous deviez prioriser une seule action en 2026 : mettre en place une gouvernance de déploiement (tests, pilotes, rollout progressif, runbooks) avant d’industrialiser l’IA. Le marché du travail récompense déjà ces compétences, et les organisations qui les internalisent prennent une longueur d’avance.

Le vrai sujet, maintenant : quand votre prochain incident arrivera un samedi à 02h30, votre organisation aura-t-elle un plan meilleur que “papier alu + scotch” — et les bons talents pour l’exécuter ?