Deepfakes et fraude : en 2025, voir et entendre ne suffisent plus. Voici comment combiner IA, processus et sensibilisation pour contrer l’ingénierie sociale.

Deepfakes : l’IA qui trompe… et l’IA qui protège

Une demande de virement arrive à 16h48 un vendredi. Le message est bref, pressant, signé du directeur financier. Puis un audio suit : la voix est exactement la sienne, même tics de langage, même respiration. Dans beaucoup d’entreprises, ça suffit à déclencher l’action. Et c’est précisément le problème : en 2025, “voir” (ou “entendre”) ne prouve plus rien.

Le Mois européen de la cybersécurité a remis ce sujet sur le devant de la scène : les deepfakes et, plus largement, les médias synthétiques deviennent l’outil préféré des fraudeurs. La nouveauté, ce n’est pas l’arnaque. C’est la qualité de l’illusion, à un coût dérisoire, et sa capacité à passer par nos réflexes humains : confiance, urgence, autorité.

Ce billet s’inscrit dans notre série « Intelligence artificielle dans la cybersécurité » : on va regarder le risque deepfake sans dramatisation inutile, puis surtout comment l’IA peut aider à détecter la tromperie en analysant les signaux de fraude et les comportements, et comment structurer un programme de sensibilisation qui tient la route.

“Quand voir n’est plus croire” : pourquoi les deepfakes explosent

Les deepfakes progressent parce qu’ils réduisent la friction de l’escroquerie. Avant, imiter une voix ou produire une vidéo crédible demandait du temps, des compétences et un budget. Aujourd’hui, quelques minutes d’audio public (webinaire, interview, message vocal), quelques photos, et une attaque devient plausible.

Trois facteurs expliquent l’accélération observée en 2025 :

- Démocratisation des outils : des solutions grand public permettent de générer voix, images et vidéos sans expertise.

- Surabondance de contenus : réseaux sociaux, visios, podcasts… la matière première pour entraîner une imitation est partout.

- Fatigue de vigilance : les équipes reçoivent trop de sollicitations, trop vite. Les fraudeurs misent sur l’automatisme.

Et le vrai danger, c’est la combinaison : un email crédible + un appel vocal synthétique + un faux “check” sur un réseau social. Pris séparément, chaque indice pourrait alerter. Ensemble, ils créent une cohérence trompeuse.

Les scénarios qui font le plus de dégâts (et pourquoi)

Les fraudeurs visent d’abord l’argent, puis la réputation. Les cas les plus rentables s’appuient sur la pression et l’autorité.

- Fraude au faux dirigeant (CEO/CFO fraud) : une voix synthétique ordonne un virement “urgent”.

- Faux investissements : deepfake d’une personnalité connue qui “recommande” une opportunité.

- Sextorsion via deepfake : création d’images intimes à partir de photos banales pour extorquer.

- Détournement de processus internes : faux message vidéo lors d’une visio pour valider une action sensible.

Phrase à retenir : un deepfake n’a pas besoin d’être parfait, seulement assez crédible pour gagner 90 secondes.

L’angle mort des organisations : on forme les gens, mais on laisse les processus vulnérables

La plupart des entreprises abordent la sensibilisation comme une “bonne pratique”, pas comme un contrôle de sécurité. Résultat : on apprend aux équipes à repérer des indices (faute d’orthographe, adresse bizarre), mais on oublie que les deepfakes contournent ces signaux classiques.

Ce qui marche mieux en 2025, c’est une approche en deux couches :

- Réduire la surface de manipulation (processus, validations, canaux officiels).

- Augmenter la capacité de détection (IA + signaux techniques + signaux comportementaux).

Les 5 moments où vos équipes sont le plus faciles à piéger

Les attaques deepfake réussissent quand elles s’alignent sur le contexte opérationnel. Les fraudeurs “collent” à vos routines.

- Fin de journée / fin de semaine (le fameux “virement avant 17h”).

- Clôture comptable, paie, périodes de fêtes (en décembre, l’urgence est permanente).

- Déplacements de dirigeants, salons, comités de direction.

- Changements d’IBAN fournisseurs, nouvelles filiales.

- Arrivées de nouveaux employés (moins de repères, plus d’envie de bien faire).

Le point dur à entendre : ce n’est pas un problème d’intelligence individuelle. C’est un problème de système : pression + autorité + canal “réaliste”.

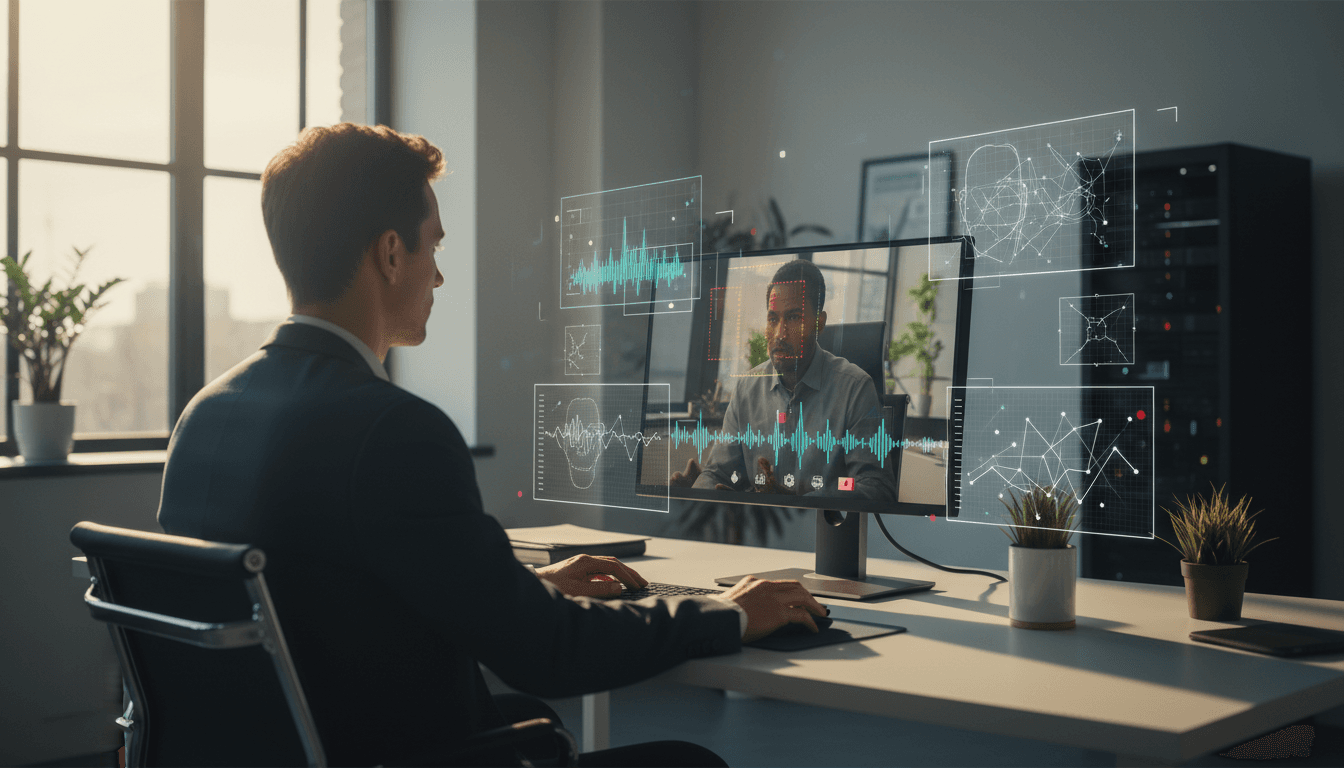

Comment l’IA aide vraiment contre l’ingénierie sociale (au-delà du buzz)

L’IA est utile contre les deepfakes quand elle se concentre sur la détection de la tromperie et l’analyse de patterns, pas quand elle promet une “détection magique” à 100%.

Voici trois usages concrets, efficaces en entreprise.

1) Détecter les anomalies de communication (et pas seulement le contenu)

Les meilleures détections viennent du contexte : qui contacte qui, quand, et par quel canal. Les modèles peuvent apprendre vos habitudes et repérer les écarts.

Exemples de signaux exploitables par IA :

- Un dirigeant “demande” un virement via un canal qu’il n’utilise jamais.

- Un manager écrit à une équipe finance à une heure atypique, avec une urgence inhabituelle.

- Un changement soudain de ton : plus directif, moins de détails, plus de pression.

Ce type de détection s’intègre souvent dans :

- passerelles email, messageries d’entreprise, outils anti-phishing,

- plateformes SOC/SIEM via corrélation,

- moteurs UEBA (User and Entity Behavior Analytics).

2) Repérer les deepfakes avec des indices techniques… et admettre leurs limites

La détection deepfake “pure” (audio/vidéo) progresse, mais reste une course-poursuite. Les algorithmes cherchent des incohérences : artefacts visuels, rythme des clignements, micro-variations audio, traces de génération.

Là où j’ai vu les équipes se tromper, c’est d’en faire un juge unique. Une meilleure stratégie :

- traiter la détection deepfake comme un signal parmi d’autres,

- déclencher une vérification humaine structurée quand le risque est élevé (paiement, changement d’IBAN, données sensibles).

3) Personnaliser la sensibilisation grâce à l’analyse comportementale

La sensibilisation efficace n’est pas la même pour un comptable, un assistant de direction ou un commercial. L’IA peut aider à cibler les formations et exercices sur les situations à risque réel.

Approche pragmatique :

- analyser les incidents et quasi-incidents (tentatives de fraude, signalements),

- identifier les équipes les plus exposées (flux de paiements, relation fournisseurs, direction),

- adapter les scénarios d’entraînement (ex. faux vocal du “CFO” plutôt que phishing générique).

Résultat : moins de modules “catalogue”, plus de mise en situation. Et un indicateur utile : le temps moyen avant escalade (combien de minutes avant qu’un employé demande une validation).

Mettre en place une défense anti-deepfake : check-list opérationnelle

La meilleure défense, c’est de rendre l’attaque coûteuse. Si un fraudeur doit franchir trois contrôles indépendants, il abandonne souvent pour une cible plus simple.

Les contrôles à instaurer (ou renforcer) sur 30 jours

-

Procédure de paiement “hors bande”

- Toute demande urgente de virement doit être confirmée via un second canal officiel (ex. appel à un numéro interne enregistré, pas celui fourni dans le message).

-

Règle des deux personnes (4-eyes) sur les actions sensibles

- Virements, changement d’IBAN, accès admin, export de données.

-

Liste blanche des canaux et des identités

- Un dirigeant ne valide pas un virement via messagerie personnelle. Point.

-

Mots de passe de procédure (phrase de validation)

- Une phrase convenue (et renouvelée) pour valider une action critique lors d’un appel. Simple, très efficace.

-

Journalisation + corrélation

- Centraliser événements email, messagerie, finance (ERP), IAM. L’IA n’est utile que si les données sont là.

Règle qui évite des drames : l’urgence n’annule jamais le contrôle.

Les réflexes à entraîner chez les équipes (sans les culpabiliser)

On ne “teste” pas les employés, on les équipe. Les deepfakes jouent sur la peur de mal faire. Votre programme doit rendre acceptable le fait de ralentir.

À ancrer dans les habitudes :

- “Je rappelle via l’annuaire interne.”

- “Je fais valider par une deuxième personne.”

- “Je ne traite pas une demande financière sur un canal non prévu.”

- “Si on me met la pression, j’escalade.”

Et côté management : valoriser publiquement les “bons refus”. Une entreprise où personne n’ose dire non est une entreprise facile à frauder.

Questions fréquentes (et réponses franches)

Un deepfake peut-il passer en visioconférence en direct ?

Oui. Ce qui compte, c’est votre protocole de validation, pas votre capacité à “deviner” à l’œil nu. Une visio ne doit jamais être une preuve suffisante pour une action critique.

La biométrie vocale suffit-elle contre la voix synthétique ?

Non, pas seule. La biométrie vocale doit être combinée à des contrôles de contexte (device, localisation, historique, canal) et à une étape de vérification hors bande.

Faut-il interdire les outils d’IA générative aux employés ?

Interdire “en bloc” marche rarement. Encadrer marche mieux : politique claire, outils approuvés, données sensibles interdites, supervision, et formation ciblée.

Faire de l’IA un allié : la prochaine étape de votre programme de sensibilisation

Les deepfakes rendent une chose très claire : la cybersécurité n’est plus seulement une affaire de malware, c’est une affaire de confiance. Et la confiance est désormais attaquée avec des moyens industriels.

Si vous pilotez une DSI, une RSSI, la finance ou les RH, je recommande un plan simple :

- cartographier vos processus “à fort enjeu” (paiements, fournisseurs, accès, données),

- ajouter des validations indépendantes,

- utiliser l’IA là où elle est forte : détection d’anomalies, corrélation, analyse comportementale,

- entraîner les équipes sur des scénarios réalistes (audio/vidéo), surtout en périodes sensibles comme décembre.

La question qui va compter en 2026 n’est pas “pouvons-nous reconnaître un deepfake ?” mais “avons-nous conçu nos processus pour qu’un deepfake ne suffise jamais ?”